Содержание

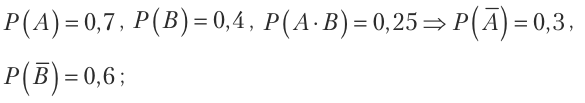

- Закономерности 7-8 лет

- Как установить закономерность

- Закономерность событий

- Числовые закономерности

- Закономерности с фигурами и символами

- Играй и учись!

- Закономерность что это простыми словами для детей

- Как понять найти закономерность

- Выбирайте игру для старта

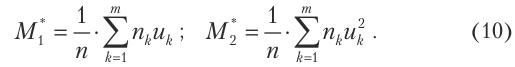

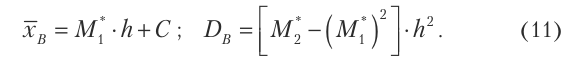

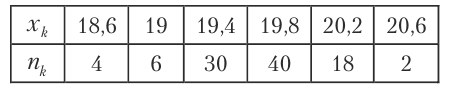

- Что такое закономерность в математике?

- Последовательность букв

- Закономерности 5-6 лет

- Подготовка к игре

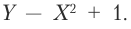

- Закономерность это в математике

- Выбирайте игру для старта

- Что такое закономерность в математике?

Закономерности 7-8 лет

Учимся узнавать закономерности расположения чисел и фигур, определять логическую последовательность действий и состояний в природе.

Игры на поиск закономерностей интересны в любом возрасте. Дети 7-8 лет уже знакомы с закономерностями в природе. Первоклашки умеют складывать и вычитать в пределах 20, делают вычисления в уме, поэтому задания для этого возраста будут содержать сюжетные картинки, комбинации чисел, геометрических фигур и символов.

Как установить закономерность

Установить закономерность – значит найти правило, по которому составлена последовательность элементов, продолжить или восстановить пропущенные элементы.

Закономерность событий

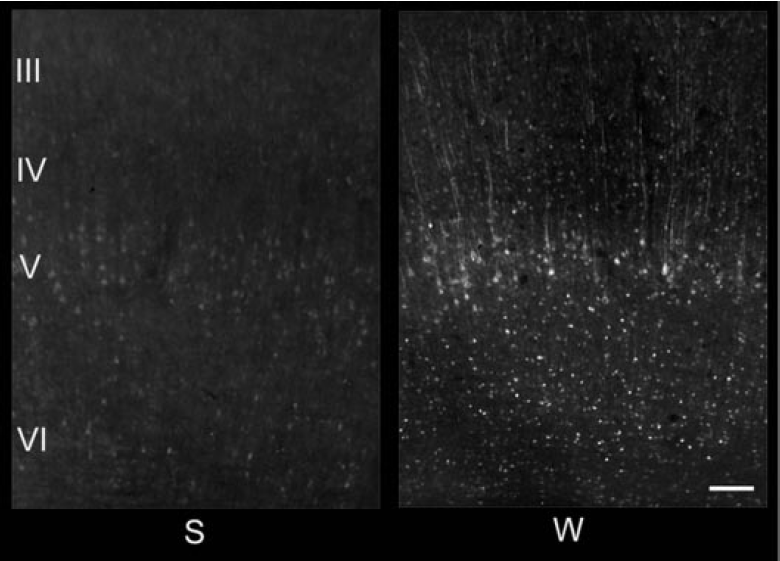

Для развития логики и речи предложите ребенку игру на установление закономерности в последовательности событий. Задания помогают раскрыть причинно–следственные связи и воссоздать временную последовательность: раньше — позже. Ребенок научится понимать взаимосвязь событий и выстраивать логическую цепочку действий или превращений.

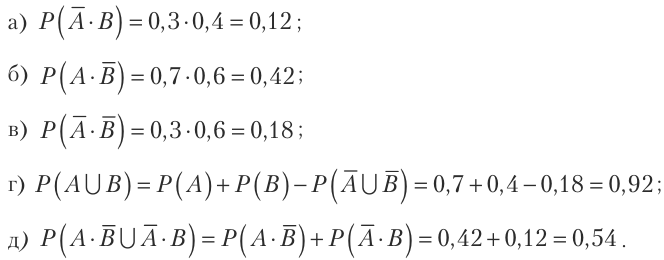

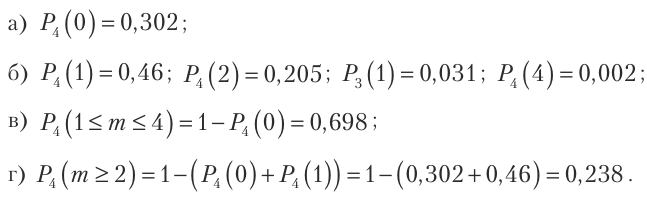

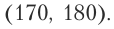

Числовые закономерности

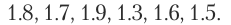

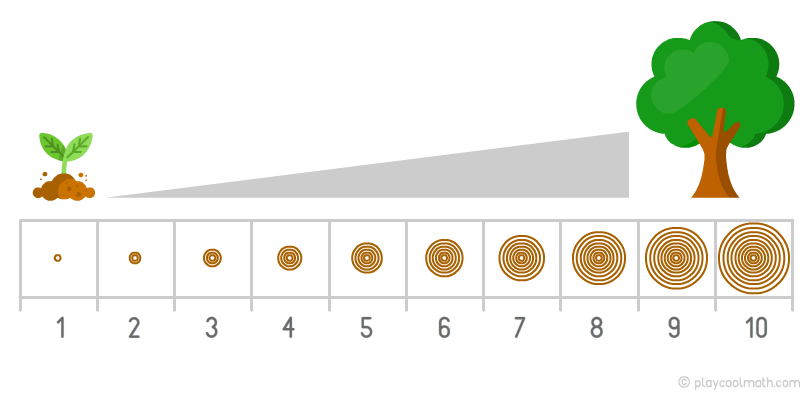

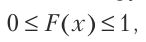

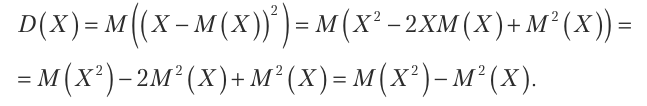

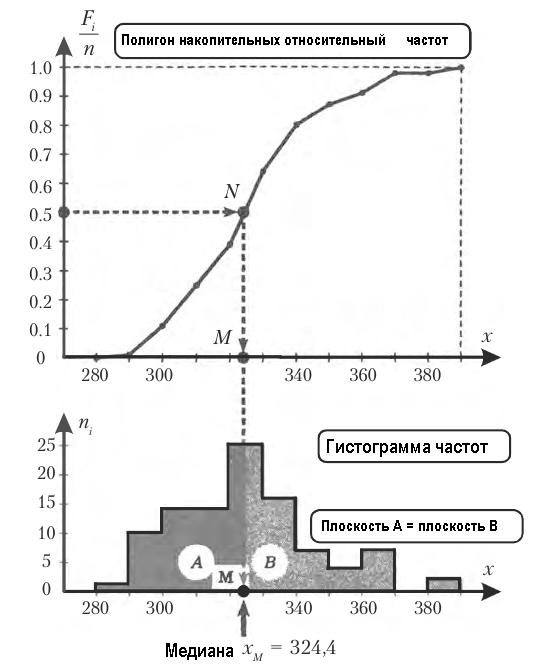

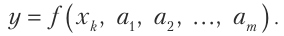

Закономерность, в которой числа увеличиваются называется возрастающая, а закономерность, где числа уменьшаются — убывающая.

Числа в циклической закономерности повторяются снова и снова, как лампочки на гирлянде.

Пример: 1 2 2 1 2 2 ? 2 2 1 2 2.

Прежде, чем приступать к заданиям — разберите с ребенком несколько примеров, которые доступно объясняют как устанавливать числовые закономерности.

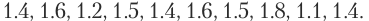

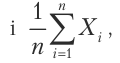

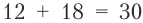

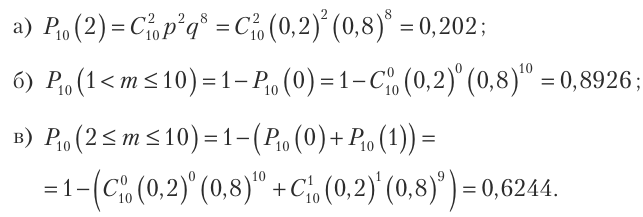

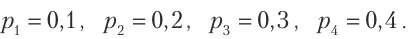

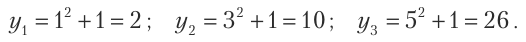

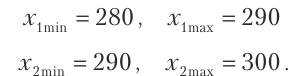

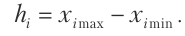

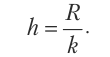

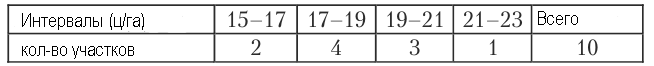

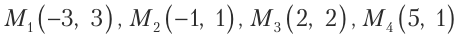

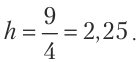

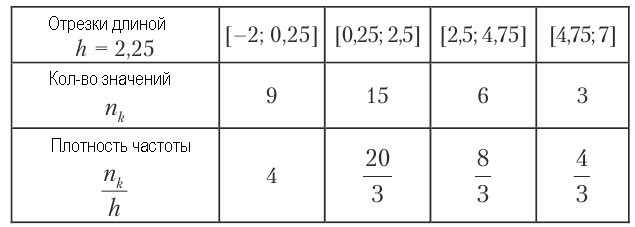

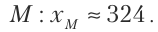

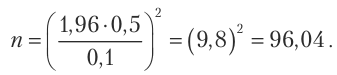

Пример 1. Продолжи закономерность чисел 1,3,5,7, ? Сначала найдем разность соседних чисел — из большего числа вычтем меньшее (предыдущее): 7-5=2 5-3=2 3-1=2

Вывод: числа закономерно увеличиваются на одно и тоже значение, каждое последующее число на 2 больше, чем предыдущее, значит неизвестное число будет на 2 больше, чем 7. 7+2=9 Ответ: 1,3,5,7,9.

В числовой закономерности должно быть не меньше трех чисел. Иногда одно число может быть суммой или произведением других двух чисел.

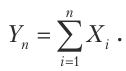

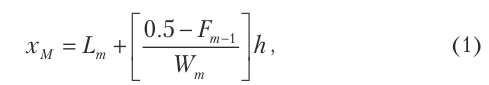

Пример 2. Продолжи ряд чисел 2,3,5,8, ?

Сначала найдем разность соседних чисел.

3-2=1 5-3=2 8-5=3

Какую закономерность можно отметить?

Вывод: разность соседних чисел увеличивается на 1, значит, чтобы узнать искомое число нужно предыдущее увеличить на 4(8+4=12). Ответ: 12.

Чтобы установить числовую закономерность найди разницу между соседними числами, определи правило составления последовательности и примени его к пропущенному числу.

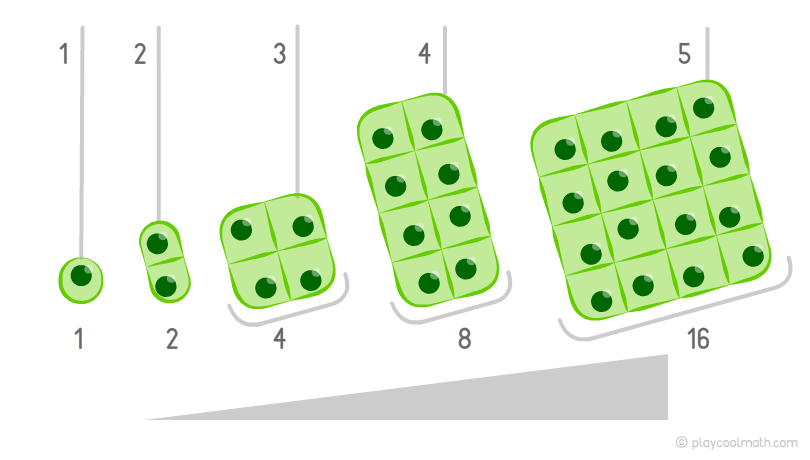

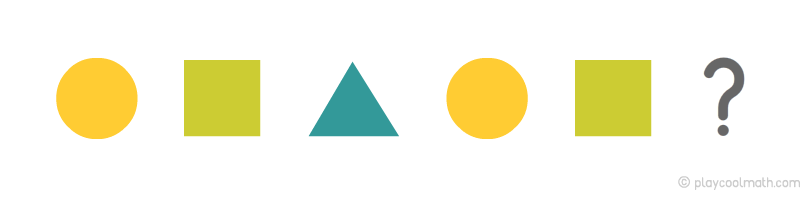

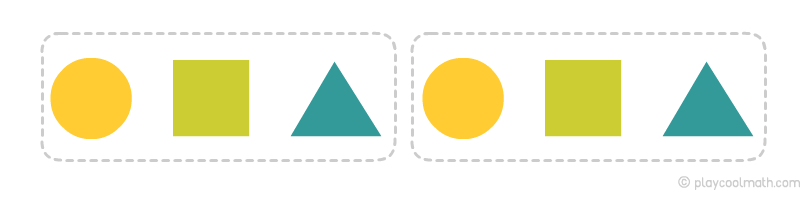

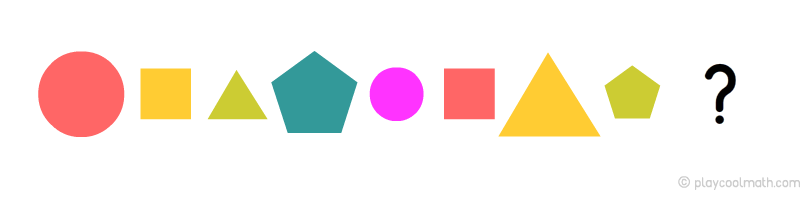

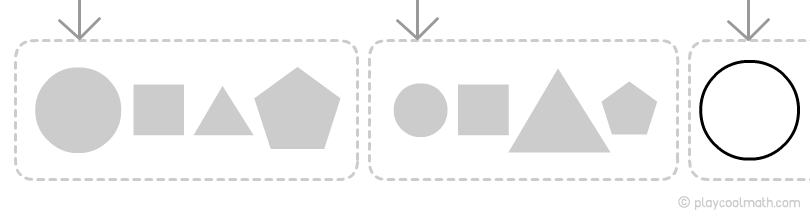

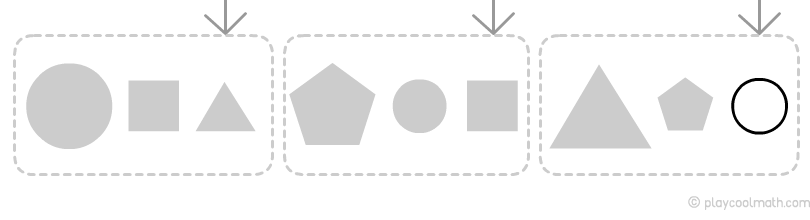

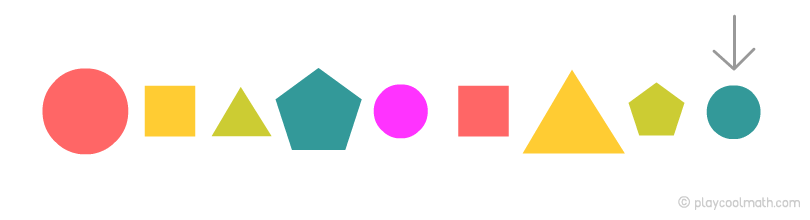

Закономерности с фигурами и символами

Закономерности с фигурами и символами развивают внимание, зрительную память, учат сравнивать и анализировать.

Детям 7-8 лет будет посильно и интересно выполнять задания, в которых «спрятано» несколько закономерностей одновременно.

После определения последовательности картинок попросите ребенка составить рассказ о происходящих событиях.

Играй и учись!

Установи порядок событий и составь рассказ о том, что изображено на картинках в логичной последовательности.

Проанализируй закономерности и найди числа, которых не хватает.

Продолжи ряд, выбери подходящую фигуру.

Источник

Закономерность что это простыми словами для детей

Как объяснить ребенку понятие закономерность? понятие ребенок закономерность

а как объяснить решее задачи, заданной на лето/1 класс/ продолжить ряд чисел не нарушая закономерноси: 5,2005,3005.

Еще, 50 лет назад, когда моя дочь пошла в 1-й класс, подобные задачки тоже ей задавали. Я, возмущаясь, говорил: один дурак может задать столько вопросов, что сто умных на них не ответят. И это продолжается. к сожалению.

Закономерности бывают разные. Если ваш ребенок школьник, могу предположить, что нужна математическая закономерность. Тут задачи на закономерности решаются логически. Самый простой пример. 1,2,3,4,5,6. Продолжить по закономерности ряд чисел. Логично же что дальше будет 7,8,9 и так далее..

формула событий. развитие событий на основе анализа предыдущих событий и свойств природы. Законов Вселенной… Гроза. Гром. Молния. Идёт дождь. Снегопад…. Отсутствие денег в бюджете при неразумном расходовании.. покупка игрушки любимой при правильном поведении.

На примере существования/наступления дня и ночи или времени года. Также постараться объяснить как и почему это происходит и желательно при этом использовать какие нибудь наглядные пособия. Это будет убедительным примером объективной закономерности.

Людмила, начните объяснять прямо сейчас. Спросите, что сейчас-день, ночь, потом, что будет? И так далее, лучше про дни рождения,праздники. Вот тут то и вставьте-это закономерность, дальше-сложнее. Удачи вам.

Всё вокруг нас подчиняется порядку. После лета осень, после осени зима. Не будет порядка, будет ералаш. Закономерность, это подчинение общим законам.

Можете ему показать на примере:-Налейте в чашку с водой немного масла и покажите ему что оно плавает на поверхности. Это закономерность.

НАШКОДИЛ ПРОВЕРИТЬ РЕМЕШКОМ ОТ КУДА НОГИ РАСТУТ ХОРОШО СЕБЯ ВЕЛ ПОЛУЧИ МОРОЖЕНОЕ ЭТО С МАЛОЛЕТСТВА А ДАЛЬШЕ ПРОЦЕСС САМ ПОЙДЕТ

после детского сада ребёнок идёт в школу это есть закономерность, закончив школу идет в армию или снова учится

Терпеливо объяснить,привести примеры,продемонстрировать. Взрослым это тоже полезно,кто не усвоил в детстве.

пусть сам на себе это прочувствует, всунув два пальца в розетку над которой написано НЕ ВЛАЗЬ,! УБЬЕТ!

Источник

Как понять найти закономерность

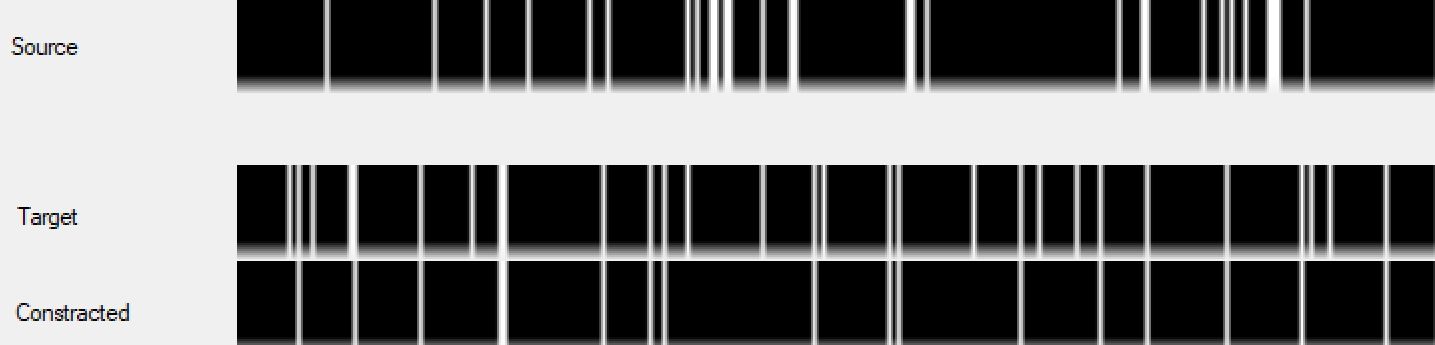

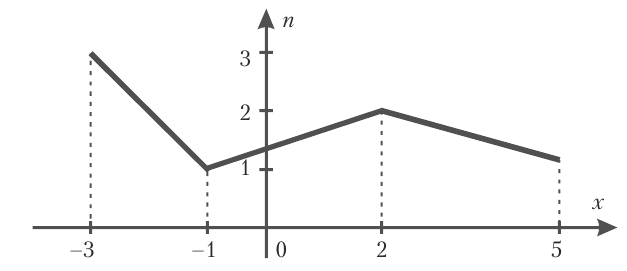

Тема: Закономерности в числах и фигурах

Всё в нашей жизни подчиняется каким-то правилам. Есть правила и в математике. Например, посмотрите на такой ряд чисел: 1, 2, 3. Числа стоят по порядку. Или такой ряд: 1, 3, 5: числа стоят через 1 число. 10, 20, 30: каждое следующее число больше предыдущего на 10. То есть при составлении какого-то последовательного ряда соблюдается какое-то правило. Это правило называется закономерность.

Закономерность – это правило, по которому что-то повторяется время от времени.

Повторяться могут изображения, буквы, числа и любые другие символы. Но обязательно в ряду должно быть не менее трёх чисел.

Например, 2, 3. Есть ли в этом ряду закономерность? Этого мы утверждать не можем. А если ряд 3, 6, 9, то какое число мы можем поставить дальше? Конечно. 12. Мы должны поставить это число по правилу данной закономерности (каждое число в ряду больше другого на 3).

В закономерности всегда не менее 3-х элементов!

На первых двух мы обычно предполагаем закономерность, а на третьем проверяем. Два элемента могут находиться рядом абсолютно случайно. А три – это уже правило.

Как находить закономерности?

1. Внимательно смотрим на ряд чисел, фигур или других картинок.

2. Если в этом ряду есть закономерность, то думаем, какая.

3. Проверяем, соблюдается ли это правило во всей последовательности чисел.

4. Вставляем числа (или фигуры), которые должны эту закономерность продолжить.

Как решать задания на закономерности, вы подробно можете посмотреть на сайте заочных школ на Методической страничке в пособии «Закономерности в цифрах и фигурах. Аналогичная закономерность». Скачайте и просмотрите. Там есть примеры аналогичных заданий.

Будьте очень внимательны при решении этих последовательностей!

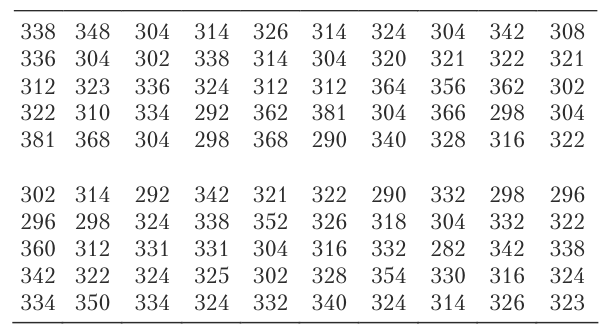

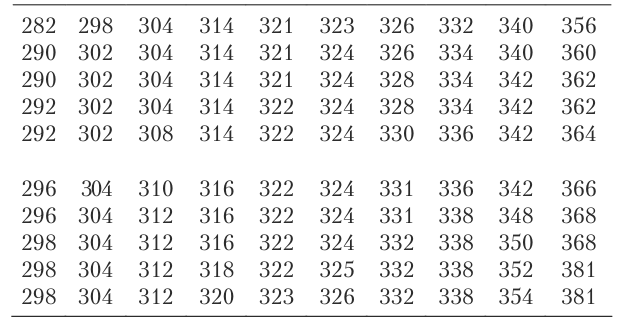

КОНТРОЛЬНАЯ РАБОТА № 3 по предмету «Математическая мозаика» для 1 класса

Фамилия _______________________________ Имя __________________

Школа _______________ Класс ______________

Задание 1. Назовите следующее число в ряду:

Задание 2. Помогите коту Мурзику выбрать из предлагаемых вариантов геометрическую фигуру, которую нужно поместить в пустую клетку.

Задание 3. Машенька – ужасная модница. У нее два ящика с красивыми косынками. В первом ящике: красная косынка, синяя косынка в белый горошек, желтая косынка в мухоморчик, красная косынка в рыбку, зеленая косынка с птичкой, зеленая косынка в мороженку. Во втором ящике: синяя косынка в белочку, красная косынка в горошек, зеленая косынка в мухоморчик. Сколько различных по цвету косынок у Машеньки? Ответ: ________

Задание 4. Определи, какую картинку надо вставить в пустую клетку.

Задание 5. Найдите числа, которых не хватает каждой змейке. Впишите цифры в ответе.

Жёлтая змейка (верхняя) – ____

Зелёная змейка (средняя) – ______

Малиновая змейка (нижняя) – _____

Задание 6. Какая фигура лишняя?

3 4 5 Ответ: _______

Задание 7. Какой пример соответствует картинке?

Задачи на поиск закономерностей развивают логическое мышление ребёнка, учат сравнивать, рассуждать, классифицировать и делать выводы.

Выбирайте игру для старта

На платформе LogicLike.com дети с удовольствием развивают логику и способности к математике (смотреть отзывы). У нас 3500 занимательных заданий с ответами и пояснениями!

Что такое закономерность в математике?

Математическая закономерность – это определенное правило, по которому в числовом, фигурном или другом ряду элементов происходит повторение или изменение самих элементов или их свойств в соответствии с заданным правилом.

Из учебных материалов с картинками и видео, подготовленных опытными педагогами, ваш ребёнок узнает:

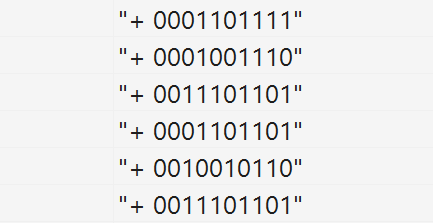

Очень часто в головоломках на закономерность встречаются буквы и цифры. Иногда могут встречаться и геометрические фигуры, и различные картинки, но это очень редко. Именно исходя из представленных букв и цифр, необходимо найти закономерность и додумать, какое же число или буква будет идти следующим. Очень часто в таких головоломках на закономерность буквы означают какие либо количественные признаки, а цифры – наоборот, зачастую обозначают буквы, или даже целые слова.

Последовательность букв

Автор получил 7 рублей за добавление этой Головоломки на сайт

Хочу так же

Источник

Закономерности 5-6 лет

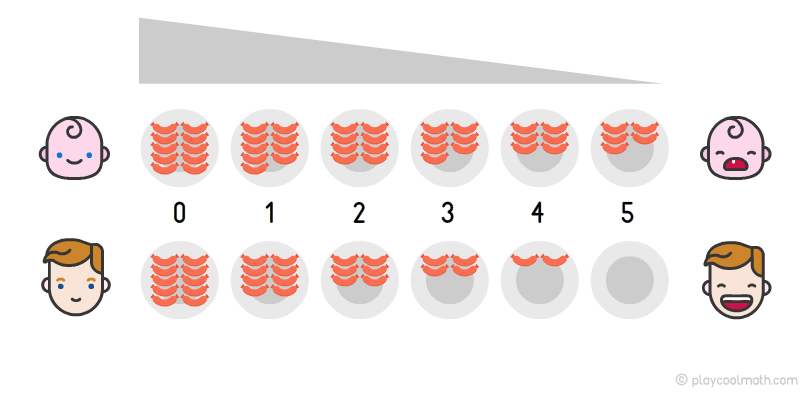

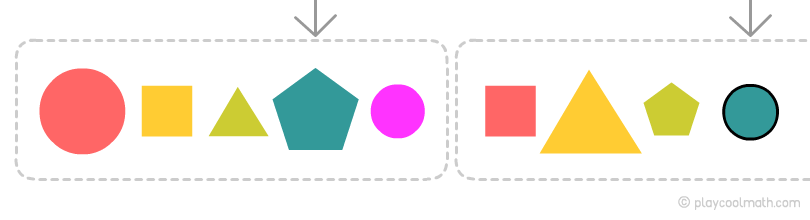

Нахождение закономерностей – один из способов развития логического мышления. Игры на поиск логических закономерностей научат ребенка анализировать, сравнивать, обобщать и делать выводы. Такие задания тренируют ум, развивают смекалку и находчивость.

Логическая закономерность – это правило, по которому происходит повторение или изменение свойств предметов, чисел или других элементов в соответствии с заданным правилом.

Подготовка к игре

Прежде, чем приступать к игровым заданиям, наглядно объясните ребенку, что такое закономерность. Для этого возьмите три- четыре предмета и составьте ряд, в котором будет прослеживаться закономерность. Попросите ребенка рассмотреть предметы и выдвинуть гипотезу: по какой закономерности составлен ряд. После этого ребенок сам сможет правильно продолжить ряд предметов.

Закономерность наглядно показывают с помощью предметов, чисел, фигур или других элементов.

Расскажите ребенку, что признак может закономерно добавляться или уменьшаться. Предложите малышу внимательно посмотреть на божьих коровок и сказать, что изменяется. Верно, количество точек увеличивается на одну. Уточните, какой рисунок спрятался под вопросом. Малыш наверняка догадался – это божья коровка с 4-мя точками.

Решая логическую задачу, ребенок научится устанавливать разнообразные связи, выявлять причину по следствию и комбинировать исходные элементы.

Играя в игру «Найди закономерность» ребенок научится устанавливать логические связи, выявлять причину по следствию и комбинировать исходные элементы. Рассматривайте картинки и находите логические закономерности вместе с ребенком.

Если ваш ребенок смог самостоятельно выполнить последнее задание — смело переходите на страницу для детей 6-7 лет со следующим уровнем сложности игры!

Источник

Закономерность это в математике

Задачи на поиск закономерностей развивают логическое мышление ребёнка, учат сравнивать, рассуждать, классифицировать и делать выводы.

Выбирайте игру для старта

На платформе LogicLike.com дети с удовольствием развивают логику и способности к математике (смотреть отзывы). У нас 3500 занимательных заданий с ответами и пояснениями!

Что такое закономерность в математике?

Математическая закономерность – это определенное правило, по которому в числовом, фигурном или другом ряду элементов происходит повторение или изменение самих элементов или их свойств в соответствии с заданным правилом.

Из учебных материалов с картинками и видео, подготовленных опытными педагогами, ваш ребёнок узнает:

Тема: Закономерности в числах и фигурах

Всё в нашей жизни подчиняется каким-то правилам. Есть правила и в математике. Например, посмотрите на такой ряд чисел: 1, 2, 3. Числа стоят по порядку. Или такой ряд: 1, 3, 5: числа стоят через 1 число. 10, 20, 30: каждое следующее число больше предыдущего на 10. То есть при составлении какого-то последовательного ряда соблюдается какое-то правило. Это правило называется закономерность.

Закономерность – это правило, по которому что-то повторяется время от времени.

Повторяться могут изображения, буквы, числа и любые другие символы. Но обязательно в ряду должно быть не менее трёх чисел.

Например, 2, 3. Есть ли в этом ряду закономерность? Этого мы утверждать не можем. А если ряд 3, 6, 9, то какое число мы можем поставить дальше? Конечно. 12. Мы должны поставить это число по правилу данной закономерности (каждое число в ряду больше другого на 3).

В закономерности всегда не менее 3-х элементов!

На первых двух мы обычно предполагаем закономерность, а на третьем проверяем. Два элемента могут находиться рядом абсолютно случайно. А три – это уже правило.

Как находить закономерности?

1. Внимательно смотрим на ряд чисел, фигур или других картинок.

2. Если в этом ряду есть закономерность, то думаем, какая.

3. Проверяем, соблюдается ли это правило во всей последовательности чисел.

4. Вставляем числа (или фигуры), которые должны эту закономерность продолжить.

Как решать задания на закономерности, вы подробно можете посмотреть на сайте заочных школ на Методической страничке в пособии «Закономерности в цифрах и фигурах. Аналогичная закономерность». Скачайте и просмотрите. Там есть примеры аналогичных заданий.

Будьте очень внимательны при решении этих последовательностей!

КОНТРОЛЬНАЯ РАБОТА № 3 по предмету «Математическая мозаика» для 1 класса

Фамилия _______________________________ Имя __________________

Школа _______________ Класс ______________

Задание 1. Назовите следующее число в ряду:

Задание 2. Помогите коту Мурзику выбрать из предлагаемых вариантов геометрическую фигуру, которую нужно поместить в пустую клетку.

Задание 3. Машенька – ужасная модница. У нее два ящика с красивыми косынками. В первом ящике: красная косынка, синяя косынка в белый горошек, желтая косынка в мухоморчик, красная косынка в рыбку, зеленая косынка с птичкой, зеленая косынка в мороженку. Во втором ящике: синяя косынка в белочку, красная косынка в горошек, зеленая косынка в мухоморчик. Сколько различных по цвету косынок у Машеньки? Ответ: ________

Задание 4. Определи, какую картинку надо вставить в пустую клетку.

Задание 5. Найдите числа, которых не хватает каждой змейке. Впишите цифры в ответе.

Жёлтая змейка (верхняя) – ____

Зелёная змейка (средняя) – ______

Малиновая змейка (нижняя) – _____

Задание 6. Какая фигура лишняя?

3 4 5 Ответ: _______

Задание 7. Какой пример соответствует картинке?

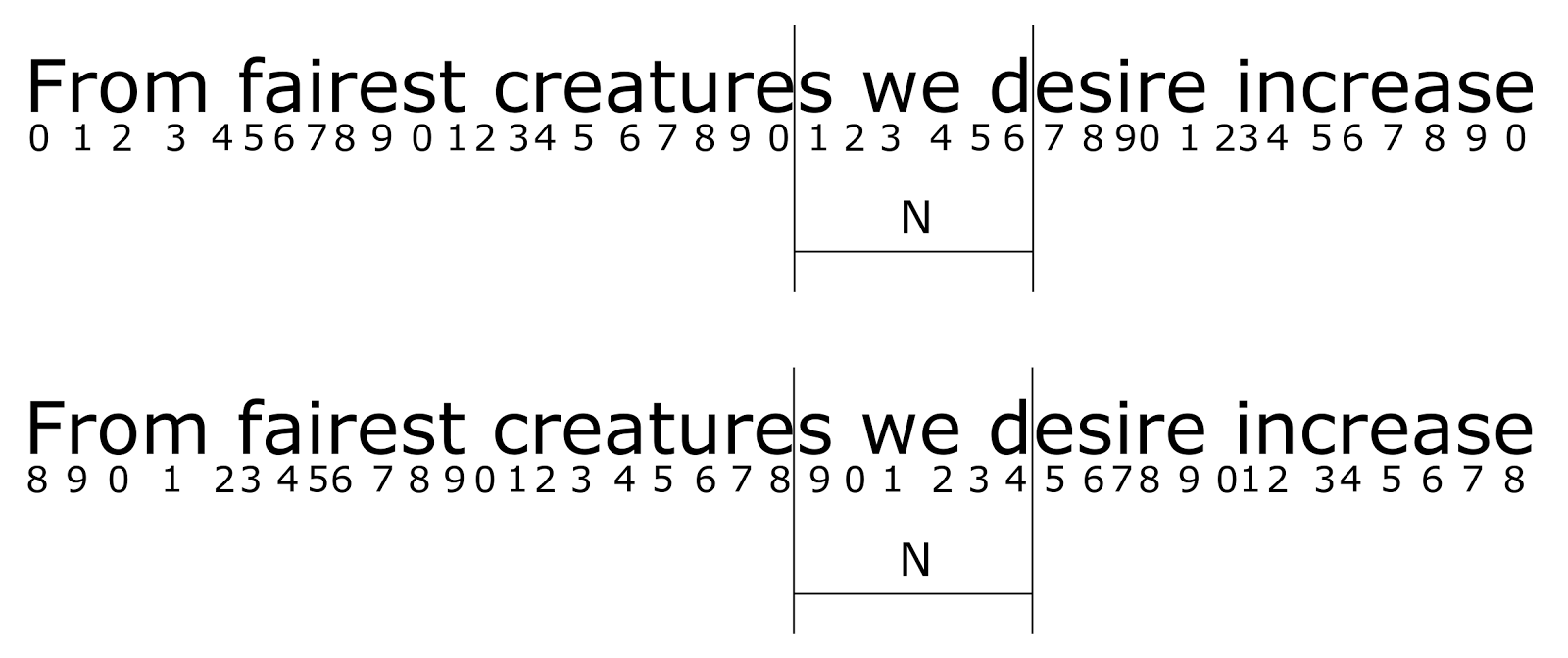

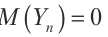

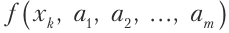

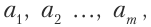

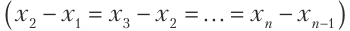

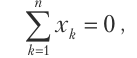

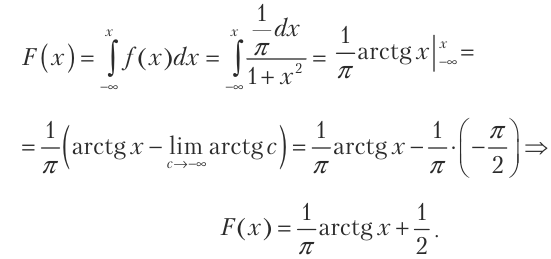

Недавно, решая какую-то математическую задачу, ко мне в голову вдруг вклинилась мысль о том, что надо найти какую-нибудь закономерность в каких-то числах. С чего бы вдруг это – я не знаю.

Закономерность долго не заставила себя ждать. Я вывел интересную на мой взгляд, но при этом абсолютно бесполезную закономерность(хотя может, когда-нибудь её и доведут до чего-нибудь полезного).

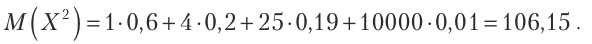

Вся суть в квадратах чисел. Между квадратами соседних чисел существует определённый порядок, закономерность. Например:

0) 0^2 = 0

1) 1^2 = 1

2) 2^2 = 4

3) 3^2 = 9

4) 4^2 = 16

5) 5^2 = 25

.

Каждое следующее число(результат) увеличивается на определённое значение, а именно: 1,3,5,7,9,11 и т.д.

Так, к примеру, разница между 5^2 и 6^2 составляет 11, между 6^2 и 7^2 – 13.

Скорее всего кто-то когда-то уже и до меня додумался до этого, но я нигде не встречал)) Может у кого-то из этого и получится что-то полезное сделать)

Источник

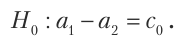

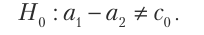

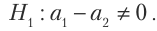

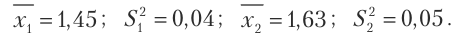

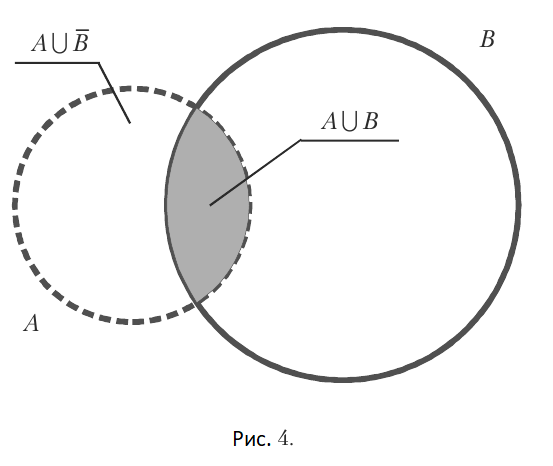

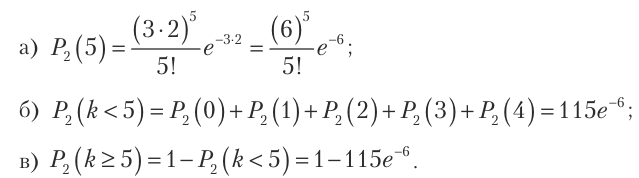

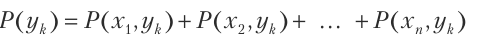

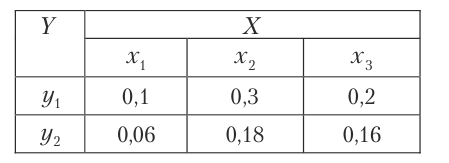

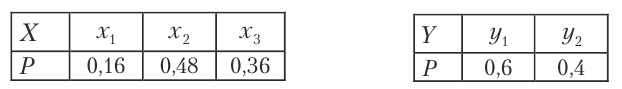

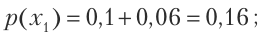

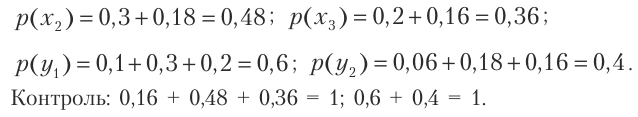

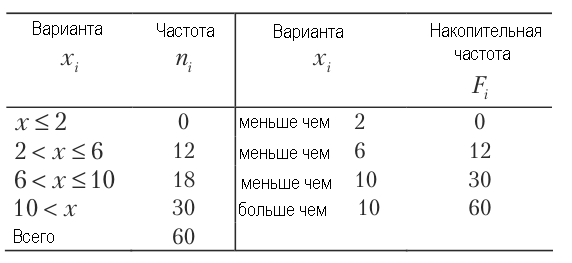

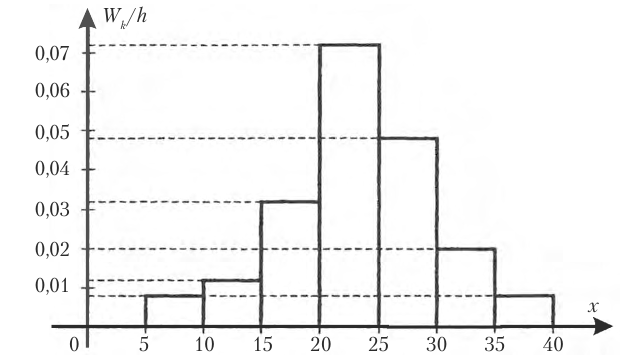

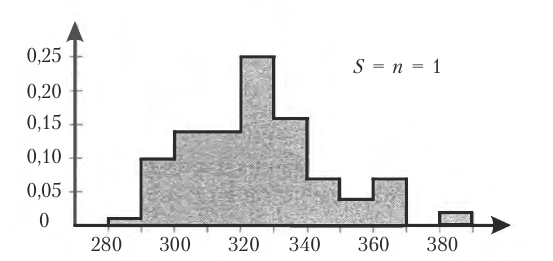

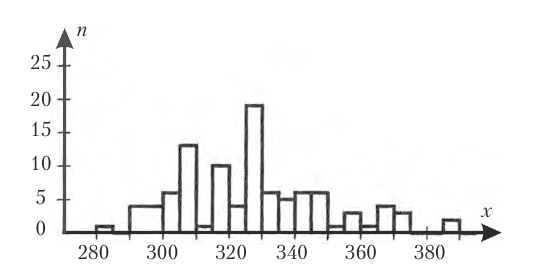

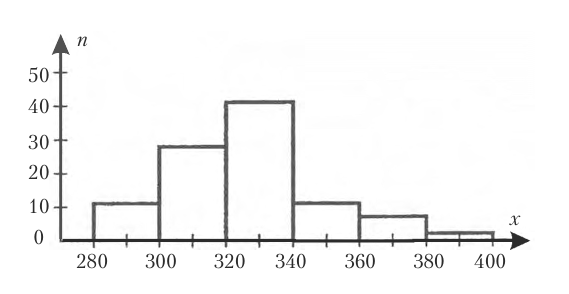

ЗАКОНОМЕРНОСТИ СЛУЧАЙНЫХ СОБЫТИЙ

- Авторы

- Руководители

- Файлы работы

- Наградные документы

Шустрова Ю.П. 1

1МБОУ СОШ №12

Жукова Л.М. 1

1МБОУ СОШ №12

Текст работы размещён без изображений и формул.

Полная версия работы доступна во вкладке «Файлы работы» в формате PDF

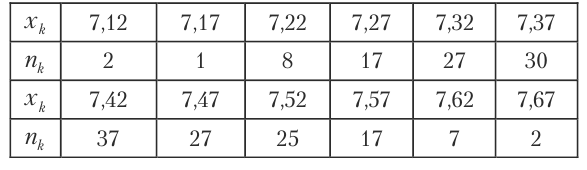

Введение.

Как говорил Бертран Рассел: «Математика заключает в себе не только истину, но и высочайшую красоту – красоту холодную и строгую, подобную красоте скульптуры».

В окружающем нас мире всё время происходят явления, которые заранее невозможно предсказать: это и ядерные реакции, и передача наследственных признаков, и солнечные вспышки… Можно ли какими-либо точными методами изучать случайность? Кажется, что одно исключает другое. Однако существует теория вероятностей, которая всецело посвящена именно теории случайных явлений. Меня заинтересовала эта тема, и я решила провести исследовательскую работу «Закономерности случайных событий».

Актуальность темы:

Теория вероятностей и закон больших чисел утверждают: иногда нужно пытаться снова и снова, чтобы получить желаемый результат. Чем больше пытаешься, тем скорее получится. Если проще: иногда надо просто не сдаваться.

Гипотеза:

С помощью теории вероятностей можно реально оценить происходящие события.

Цель:

Выявить закономерности возникновения вероятностных событий в повседневной жизни.

Задачи:

Изучить историю появления теории вероятностей как науки.

Рассмотреть вероятностные события в жизни, приводящие к возникновению закономерностей.

Обосновать выдвинутую гипотезу эмпирическим способом.

Подвести итоги полученных результатов.

История возникновения. По одной из версий в 17 веке был один азартный игрок, француз де Мере, который очень хотел разбогатеть. Однажды он обратился к своему другу, известному математику и философу Б. Паскалю с вопросом: «Сколько раз надо бросать две игральные кости, чтобы случаев выпадения сразу двух шестерок было больше половины от общего числа бросаний?». Паскаль попросил помощи у математика П. Ферма и они вместе стали заниматься этой проблемой. Таким образом и появилась теория вероятностей. Полное обоснование она получила в 1922 году. Этому способствовали русские математики, а именно П.Л. Чебышев, А.М. Ляпунов и А.А. Марков. В наши дни она широко применяется во многих областях: при прогнозировании погоды, в статистике, биологии, экономике и т. д.

«Метод решения хорош, если с самого начала мы можем предвидеть — и далее подтвердить это, — что, следуя этому методу, мы достигнем цели» — Г. Лейбниц. Это высказывание иллюстрирует теорию вероятностей.

Основная часть.

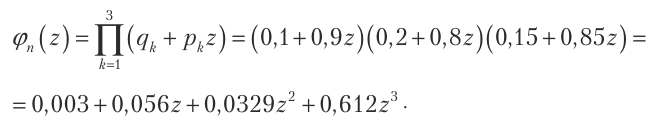

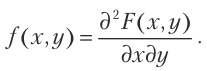

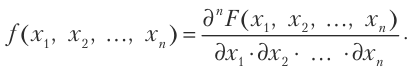

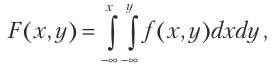

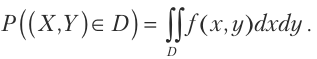

Теория вероятностей — математическая наука, изучающая закономерности в случайных явлениях.

Виды событий:

Достоверное событие – событие, которое обязательно произойдёт.

Случайное событие – событие, которое может произойти, а может и не произойти.

Невозможное событие – событие, которое не может произойти.

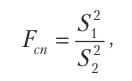

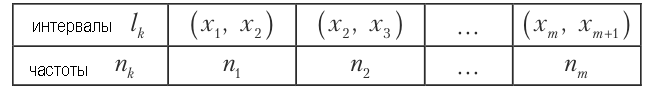

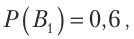

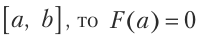

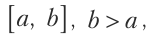

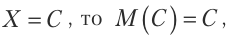

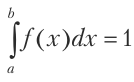

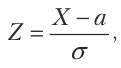

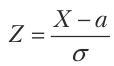

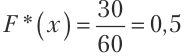

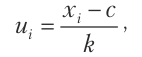

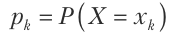

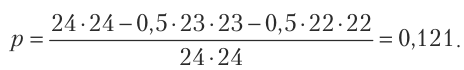

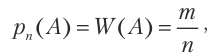

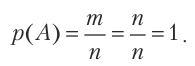

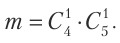

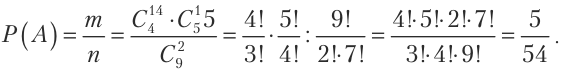

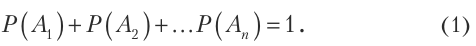

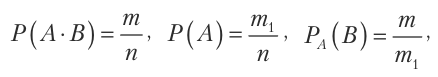

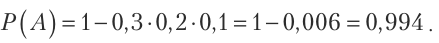

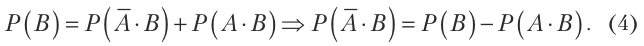

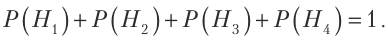

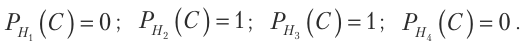

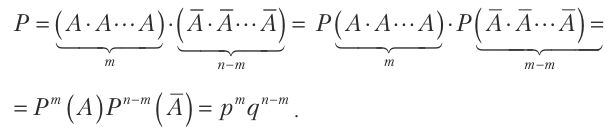

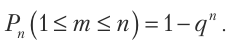

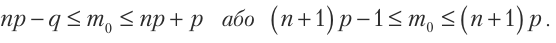

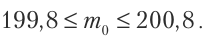

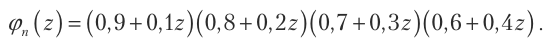

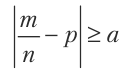

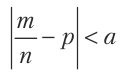

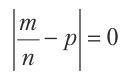

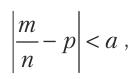

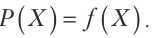

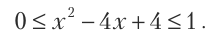

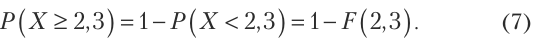

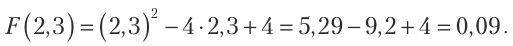

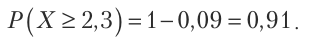

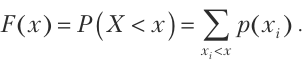

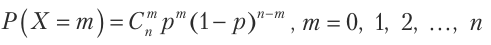

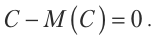

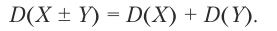

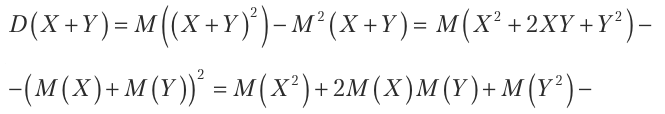

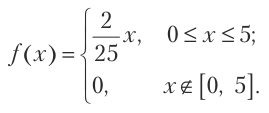

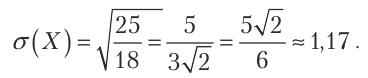

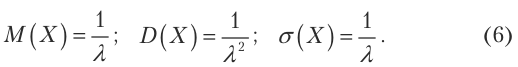

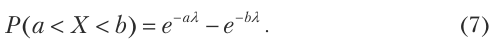

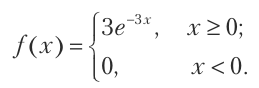

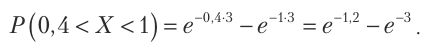

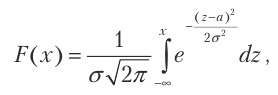

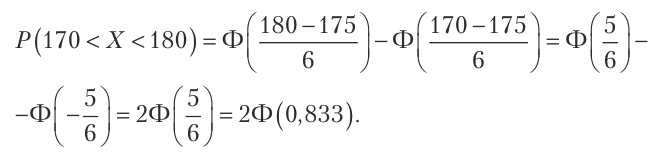

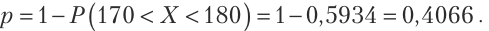

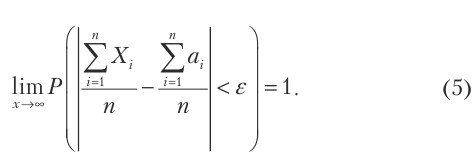

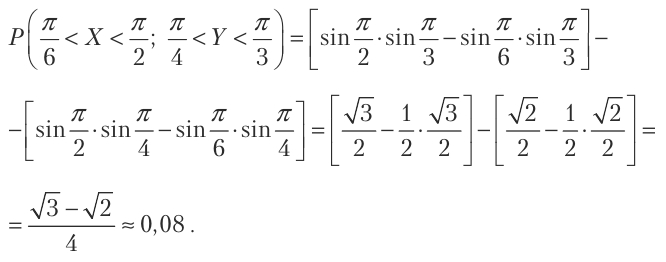

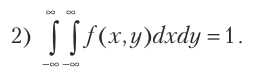

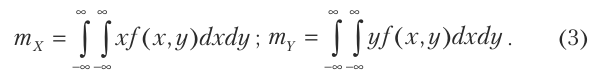

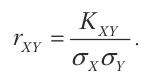

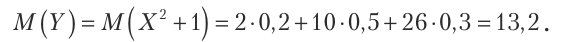

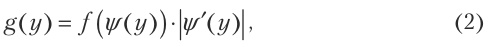

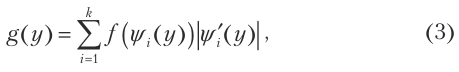

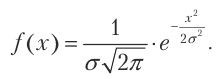

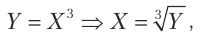

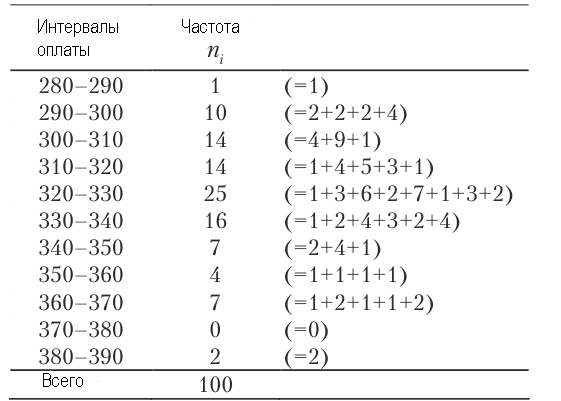

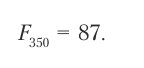

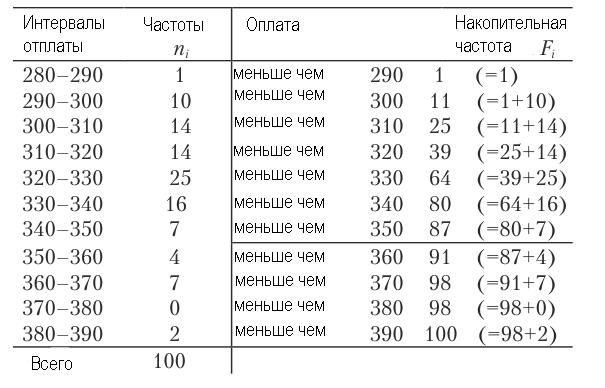

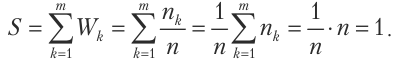

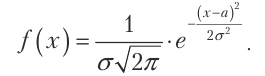

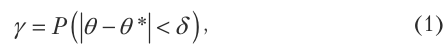

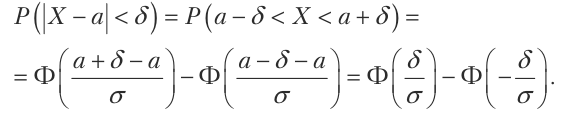

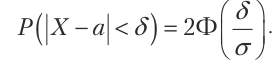

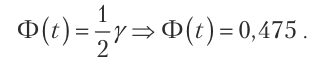

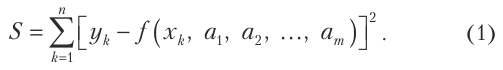

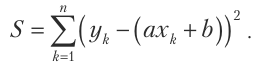

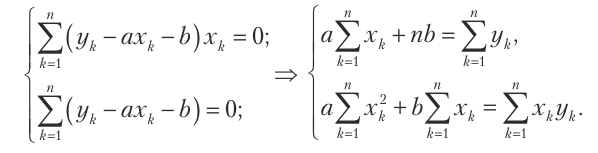

Классическая формула для вычисления вероятности случайного события: P=m/n, где m – число благоприятных исходов, а n – число всех возможных исходов.

Вероятность события никогда не будет больше 1 или меньше 0. Она равна 0 у событий, которые не могут произойти.

Вероятность равна 1, если мы говорим о событиях, которые точно произойдут. В нашем примере это вероятность того, что «все числа будут делиться на 1»

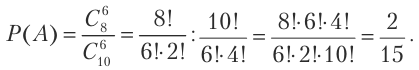

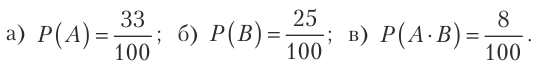

Рассмотрим теорию вероятностей на примере задачи из ОГЭ по математике.

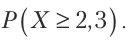

Задача:

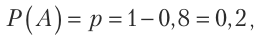

Витя выбрал трёхзначное число. Нужно найти вероятность того, что оно делится на 5.

Решение: Вычислим вероятность с помощью формулы.

Общее число всех возможных исходов: 900 (всего существует трёхзначных чисел). Число благоприятных для события «А» исходов: 180 (количество чисел, делящихся на 5).

P(A)=180/900=0,2

Ответ: 0,2

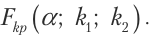

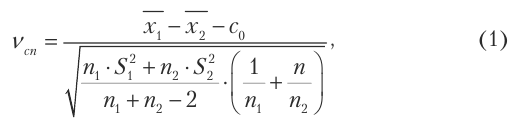

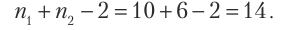

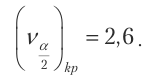

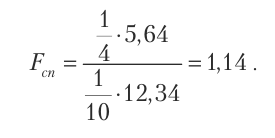

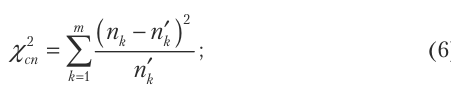

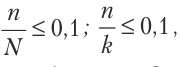

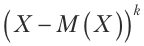

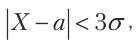

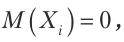

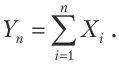

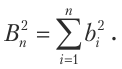

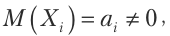

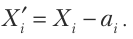

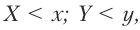

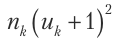

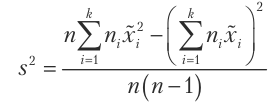

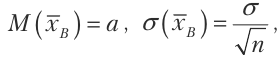

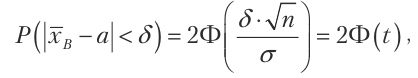

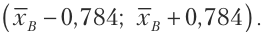

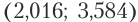

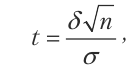

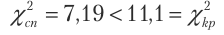

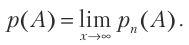

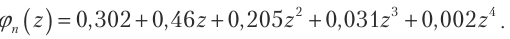

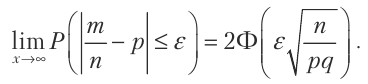

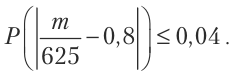

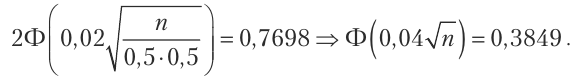

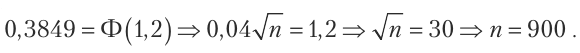

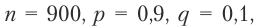

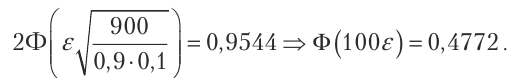

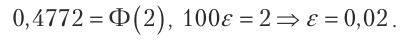

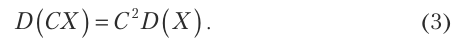

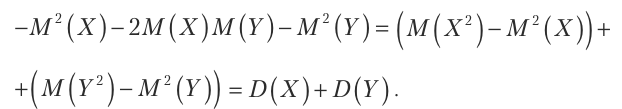

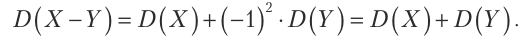

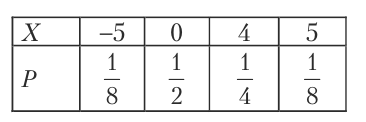

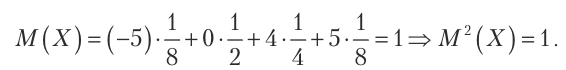

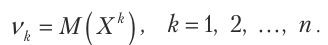

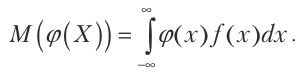

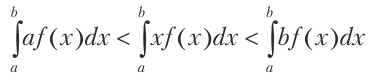

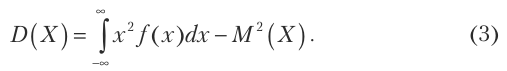

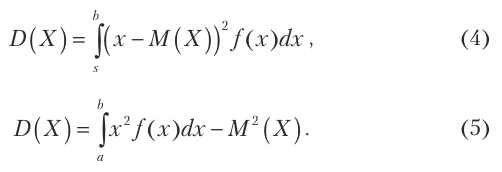

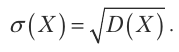

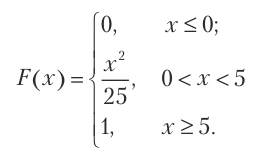

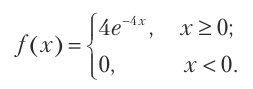

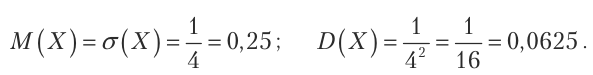

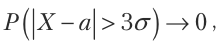

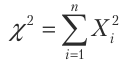

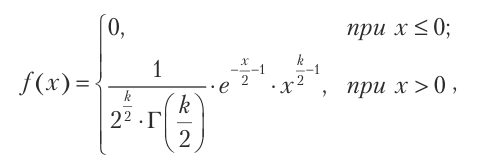

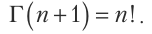

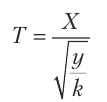

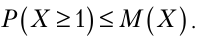

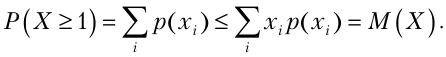

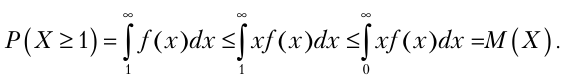

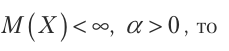

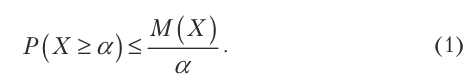

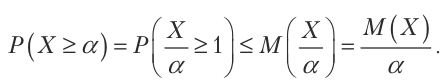

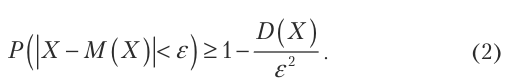

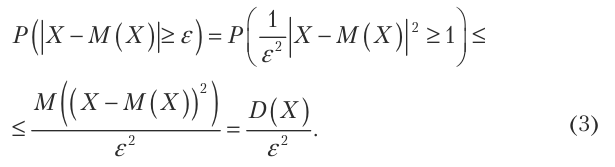

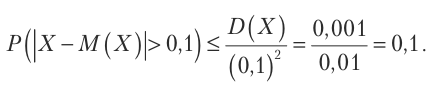

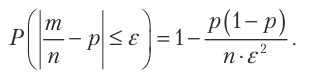

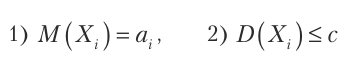

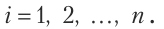

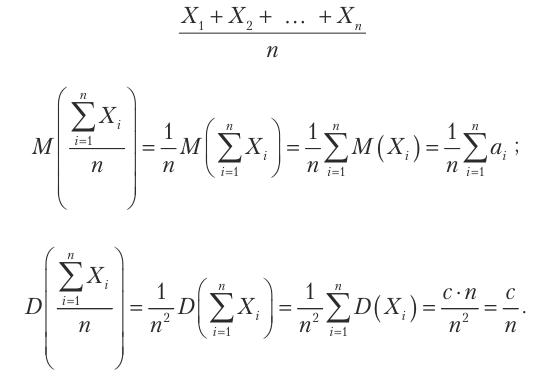

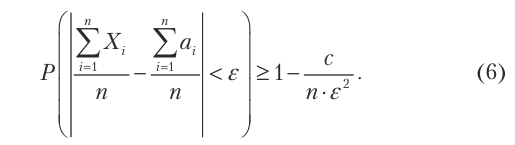

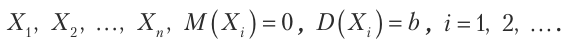

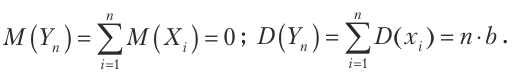

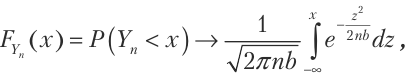

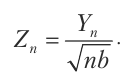

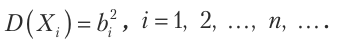

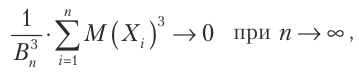

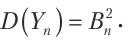

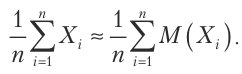

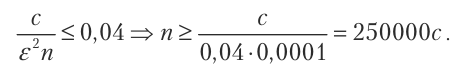

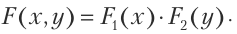

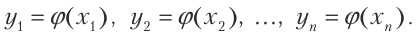

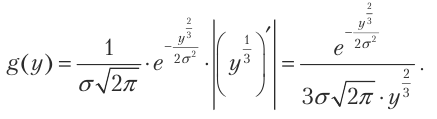

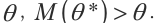

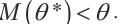

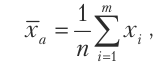

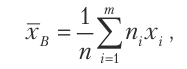

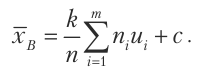

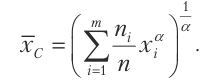

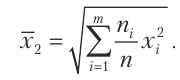

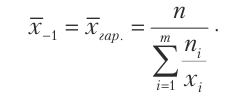

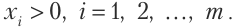

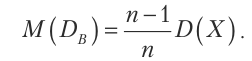

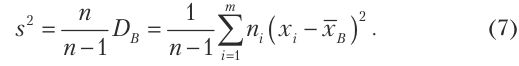

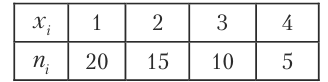

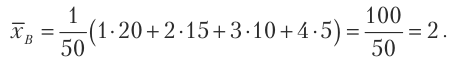

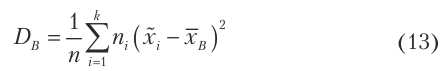

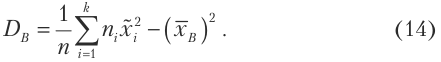

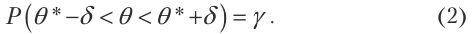

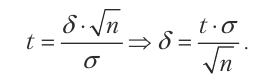

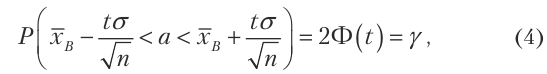

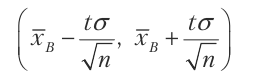

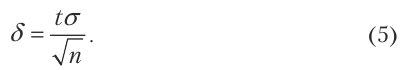

Закон больших чисел (ЗБЧ) — это обобщённое название нескольких теорем, описывающих результат выполнения одного и того же опыта много раз. К ним относятся теоремы Чебышева (наиболее общий закон больших чисел) и Бернулли (простейший). Согласно закону, среднее значение конечной выборки из фиксированного распределения близко к математическому ожиданию этого распределения. В основе доказательства теорем лежит неравенство Чебышева:

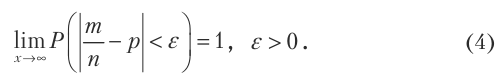

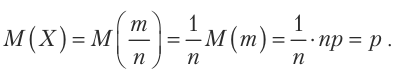

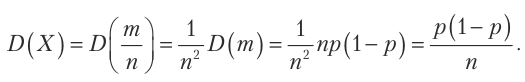

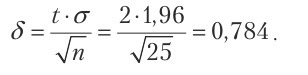

Примером этого закона может служить обычное бросание монетки. Теоретически и орел, и решка могут выпасть с одинаковой вероятностью 50%. Например, если бросить монетку 20 раз, 10 из них должен выпасть орёл и 10 – решка. Но на практике это обычно не работает, ведь частота выпадения может быть 4 к 6, 3 к 7 и т.д. Однако с увеличением количества бросков монетки, к примеру, до 1000, вероятность выпадения орла или решки будет 12. Согласно закону больших чисел, если бросать монетку бесконечно, вероятность выпадения орла или решки всегда будет стремиться к 50%.

Также задания на эту тему присутствуют в ЕГЭ по математике.

Теория вероятности в жизни.

Многие боятся летать на самолётах, потому что считают, что они опасны. Но на самом деле машины намного опаснее. Вероятность того, что человек, погибнет в авиакатастрофе составляет примерно 1/8000000. Таким образом, если пассажир будет садиться каждый день на случайный рейс, ему понадобится 21000 лет, чтобы погибнуть. На самом деле опаснее переходить дорогу по зебре, чем лететь на самолете.

Или другой пример – от падения кокосов погибает около 150 человек в год. Это в десятки раз больше, чем от укуса акул. Но почему-то фильма «Кокос-убийца» пока не снято. Подсчитано, что шанс человека встретиться с акулой составляет 1 к 11,5 миллионам, а шанс погибнуть от такой встречи 1 к двумстам шестидесяти четырём миллионам. За прошлый год от акул в США погиб только 1 человек.

Теория вероятностей может ответить на многие вопросы. Например, почемув плюсе всегда остаётся только казино? Давайте решим простую задачку:

С какой вероятностью вы выиграете в рулетке в казино, поставив на чёрное?

Всего в рулетке 18 чёрных чисел, но общее количество клеток – 37 (18 чёрных, 18 красных и зеро). Так что вероятность выигрыша получается приблизительно 0,49.

Азартные игры. Это игры в кости, лотереи, карточные игры и т.д. В их основе лежит вероятность. По подсчётам, вероятность выиграть в «Гослото 5 из 36» равна одному к трёмстам семидесяти семи тысячам, в «Гослото 6 из 45» — одному к восьми миллионам, в Евроджекпот – одному к пятидесяти девяти миллионам, а в международную лотерею «PowerBall» — одному к ста семидесяти пяти миллионам.

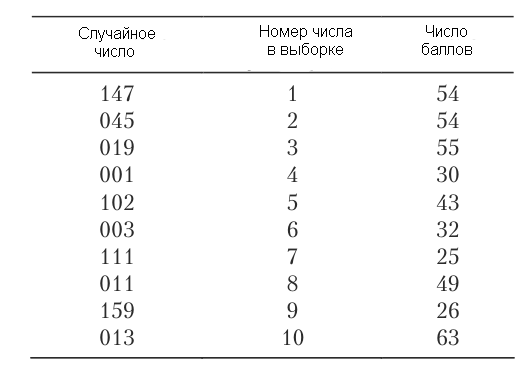

Практическая часть.

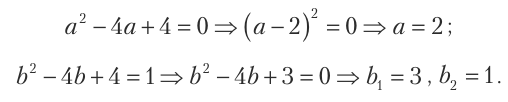

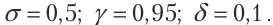

Существует один парадокс: «Представьте группу из 23 человек. Какова вероятность того, что хотя бы два человека из них отмечают день рождения в один день?»

Интуитивное мышление сразу подсказывает, что это можно легко проверить по формуле теории вероятностей: Р(А)=23/365=0,063…

Но на самом деле всё далеко не так. Вероятность такого события равна чуть меньше 0,51. Давайте разберёмся, почему.

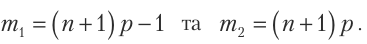

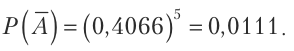

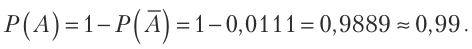

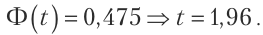

Дело в том, что если взять двоих человек, то вероятность совпадения дней рождения действительно равна Р(А)=1/365=0,003, но если людей больше, то их уже нужно учитывать не по отдельности, а попарно. Таким образом, из 23 человек можно составить 253 пары. Вероятность того, что хотя бы в одной паре дни рождения совпадут, конечно, намного больше, и рассчитывается она именно так: Учтём, что существует только 2 исхода: либо у кого-то дни рождения совпадают, либо вообще все родились в разные дни (ни у кого дни рождения не совпадают). Точно будет либо так, либо так. Тогда давайте найдём вероятность второго исхода, вычтем результат из единицы и получим искомое (хотя бы у двоих человек день рождения будет в один день).

Начнём с 2 человек, там всё просто. Первый может родиться в любой день в году. Тогда второму остаётся 364 дня, ведь 1 уже занят. Вероятность несовпадения дней рождения у них составляет P(A)=364/365. Если человека 3, то второму остаётся 364 дня, а третьему 363 (ведь 2 уже занято). Всё это должно произойти одновременно, поэтому общая вероятность находится умножением (364/365 * 363/365), то есть для троих человек вероятность несовпадения дней рождения Р=0,9917…

Таким образом, можно наращивать вероятность, и каждому человеку будет доставаться на 1 день меньше. Когда мы дойдём до 23 человек, не совпадать дни рождения будут в 0,4927. Значит в остальных случаях (0,5073) хотя бы у двоих из них дни рождения совпадут. Что интересно, растёт эта вероятность очень быстро. Когда в группе 60 человек, она достигает уже 0,99.

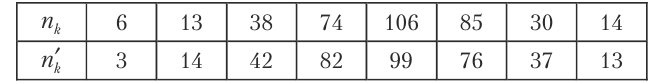

Мы решили проверить этот парадокс в нашей школе. Таблицу вы можете видеть на слайде. Красным отмечены классы, в которых более 2 совпадений, жёлтым – ровно 2. Всего у нас 37 классов. Из них в 15 дни рождения совпадают у двоих человек, а в 7 – более чем у двоих человек. Значит, вероятность совпадения дней рождения в классах нашей школы составляет примерно 0,68 (22 из 37). Также мы решили проверить группы из 3 классов (более 60 человек) и в каждой группе дни рождения совпадали у двоих, 4, а то и у 6 человек.

Конечно, в наших классах не ровно 23 человека, поэтому мы решили проверить составы команд сборных Чемпионата мира по футболу 2018 года. Там в каждой команде ровно по 23 человека. Из 32 команд в 12 дни рождения совпадают у двоих человек, а в 6 – более чем у двоих человек. Таким образом, вероятность равна примерно пятидесяти шести сотым (18 из 32).

Парадокс Монти Холла.

Парадокс назван в честь ведущего популярной американской телепередачи 2-ой половины 20-ого века. Передача называется «Let’s make a deal», что переводится как «Давайте заключим сделку».

Эта задача звучит так: «Представьте, что вы участник игры, в которой вам нужно выбрать одну из трёх дверей. За одной дверью находится автомобиль, за двумя другими — козы. Допустим, вы выбираете дверь номер 1, после этого ведущий, который знает, где находится автомобиль, а где — козы, открывает одну из оставшихся дверей, например, номер 2, за которой находится коза. После этого он спрашивает вас — хотите ли вы изменить свой выбор и выбрать дверь номер 3? Увеличатся ли ваши шансы выиграть автомобиль, если вы примете предложение ведущего и измените свой выбор?»

Вот типичный ход рассуждений: после того, как ведущий открыл одну из дверей и показал козу, игроку остается выбрать между двумя дверями. Машина находится за одной из них, значит, вероятность ее угадать составляет ½. Так что нет разницы — менять свой выбор или нет. И тем не менее, теория вероятностей гласит, что можно увеличить свои шансы на выигрыш, изменив решение. Разберемся, почему это так.

Для начала давайте вернёмся на шаг назад. В тот момент, когда мы сделали свой изначальный выбор, мы разделили двери на две части: выбранная нами и две остальные. Очевидно, что вероятность того, что автомобиль прячется за «нашей» дверью, составляет ⅓ — соответственно, автомобиль находится за одной из двух оставшихся дверей с вероятностью ⅔. Когда ведущий показывает, что за одной из этих дверей — коза, получается, что эти ⅔ шанса приходятся на вторую дверь. А это сводит выбор игрока к двум дверям, за одной из которых (изначально выбранной) автомобиль находится с вероятностью ⅓, а за другой — с вероятностью ⅔. Выбор становится очевидным. Что, разумеется, не отменяет того факта, что с самого начала игрок мог выбрать дверь с автомобилем.

Статистика показывает, что игроки, изменившие свой выбор на другую дверь, выигрывали автомобиль чаще, чем те, кто предпочёл открыть первоначальную дверь. Также этот парадокс описывается в фильме «Двадцать одно».

Ещё более наглядной ситуация становится, если представить, что дверей не 3, а, скажем 1000, и после выбора игрока ведущий убирает 998 лишних, оставляя 2 двери: ту, которую выбрал игрок и ещё одну. Представляется более очевидным, что вероятности нахождения приза за этими дверями различны, и не равны ½. Вероятность того, что автомобиль находится за изначально выбранной дверью, равно 1/1000, а за другой – 999/1000. В случае с 3 дверьми логика сохраняется, но вероятность выигрыша при смене решения соответственно 2⁄3, а не 999⁄1000.

Результаты

В ходе моей исследовательской работы я расширила свои знания по математической статистике, что позволило мне реально оценить происходящие события. Также я проверила гипотезу о днях рождения на статистических данных по нашей школе и ещё раз подтвердила её на данных составов команд, участвующих в Чемпионате Мира по футболу 2018 года. Я выяснила, что теория вероятностей позволяет выявить закономерности возникновения вероятностных событий в повседневной жизни; проверила и подтвердила гипотезу. Цель достигнута, задачи выполнены. В дальнейшем я продолжу работу по данной теме.

Выводы

Во время работы над проектом, я увидела, насколько широко применяется теория вероятности и как она влияет на нашу жизнь. Данный материал можно использовать на уроках математики при изучении темы «Элементы комбинаторики и теории вероятностей», а также при подготовке к итоговой аттестации.

Список используемых источников

1. Скороход, А. В. Вероятность вокруг нас / А. В. Скороход // Советский математик. – 1980. – С. 1

2. Балдин, К. В. Теория вероятностей и математическая статика / К. В. Балдин, В. Н. Башлыков, А. В. Рукосуев // – 2009. – С. 9

3. Денежкина, И. Е. Теория вероятностей и математическая статика в вопросах и задачах / И. Е. Денежкина, С. Е. Степанов, И. И. Цыганок // – 2019. – С. 13

Приложение.

9

Просмотров работы: 491

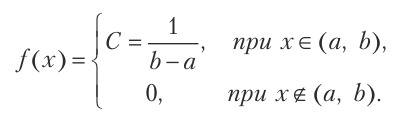

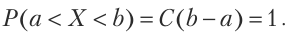

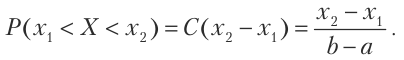

Теория вероятностей — это математическая наука, которая изучает закономерности случайных явлений. Случайные явления определяются как явления с неопределенным исходом, возникающие при многократном воспроизведении определенного набора условий.

На данной странице находится курс лекций по теории вероятности по всем темам предмета «Теория вероятностей«.

Лекции по теории вероятностей содержат большое количество примеров решения задач и выполнения заданий.

Содержание:

Основные понятия о теории вероятностей

Теория вероятностей — это математическая наука, изучающая закономерности случайных явлений. Случайные явления определяются как явления с неопределенным исходом, возникающие при многократном воспроизведении (повторении) одного и того же опыта в одних и тех же условиях.

В природе и технике, экономике и спорте нет ни одного физического явления, не содержащего элементов случайности. Разработка и изучение методов теории вероятностей и вероятностных моделей позволяет понять различные свойства случайных явлений на абстрактном и обобщенном уровне, не прибегая к экспериментам.

Цель вероятностных методов — обойти чрезмерно сложное (и часто невозможное) изучение одного случая, исследовать закономерности массовых случайных явлений, предсказать их характеристики, повлиять на ход этих явлений, контролировать их, ограничить масштаб случайности.

Фундамент каждой науки — ее важные понятия, основа красивого здания, которое пригодится на всю жизнь.

Предмет теории вероятностей

Рассмотрим некоторый эксперимент, в результате которого может появиться или не появиться событие А. Примерами такого эксперимента могут быть:

- а) эксперимент — изготовление определенного изделия, событие А — стандартность этого изделия;

- б) эксперимент — подкидывание монеты, событие А — выпал герб;

- в) эксперимент — стрельба пятью выстрелами в мишень, событие А — выбито 30 очков;

- г) эксперимент — введение программы в компьютер, событие А — безошибочный ввод.

Общим для всех экспериментов является то, что каждый из них может реализовываться в определенных условиях сколько угодно раз. Такие эксперименты называют испытаниями.

События бывают достоверные, случайные и невозможные.

Достоверным называют такое событие, которое при рассмотренных условиях обязательно случится.

Невозможным называют такое событие, которое при рассмотренных условиях не может случится.

Случайным называют такое событие, которое при рассмотренных условиях может случится, а может и не случится.

например, если в урне есть только белые шары, то добывание белого шара из урны — достоверное событие, а добывание из этой урны шара другого цвета -невозможное событие.

Если бросить монету на плоскость, то появление герба будет случайным событием, потому что вместо герба может появиться надпись.

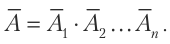

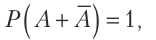

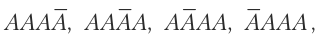

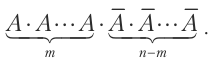

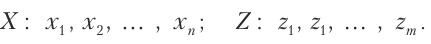

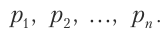

Случайные события обозначают большими буквами, например

Каждое случайное событие является следствием многих случайных или неизвестных нам причин, которые влияют на событие. Поэтому невозможно предсказать исход однофакторного испытания.

Но если рассматривать случайное событие много раз при одинаковых условиях, то можно выявить определенную закономерность его появления или не появления. Такую закономерность называют возможной закономерностью массовых случайных событий.

В теории вероятностей под массовыми однородными случайными событиями понимают такие события, которые осуществляются многократно при одинаковых условиях или много одинаковых событий.

Например, бросить одну монету 1000 раз или 1000 одинаковых монет бросить один раз в теории вероятностей считают одинаковыми событиями.

Предметом теории вероятностей является изучение вероятностных закономерностей массовых однородных случайных событий.

Основные понятия, методы, теоремы и формулы теории вероятностей эффективно применяются в науке, технике, экономике, в теориях надежности и массового обслуживания, в планировании и организации производства, в страховом и налоговом делах, в социологии и политологии, в демографии и охране здоровья.

Краткая история о теории вероятностей

Первые работы, в которых возникли основные понятия теории вероятностей, появились в

Следующий этап (конец

Я. Бернулли сделал первые теоретические обоснования накопленных ранее фактов.

В

Только в конце

Дальнейшим развитием теории вероятностей и случайных процессов обязаны таким математикам, как С.Н. Бернштейн, А.М. Колмогоров, Б.В. Гниденко, А.В. Скороход, В.С. Королюк, Ю. Нейман, И.И. Гихман, И.М. Коваленко.

Алгебра случайных событий

сначала познакомимся с разновидностями случайных событий.

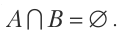

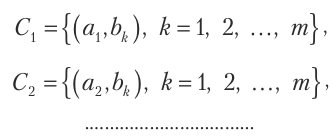

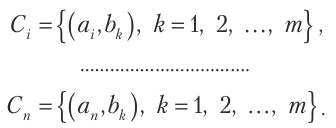

Определение 1. События называют несовместными, если появление одного из них исключает появление других событий в одном и том же испытании.

Пример №1

Среди однородных деталей есть стандартные и нестандартные. Наугад берут из ящика одну деталь.

События

А — взята стандартная деталь,

В — взята нестандартная деталь

несовместны потому, что взята только одна деталь, которая не может быть одновременно стандартной и нестандартной.

Определение 2. События называют совместными, если появление одного из них не исключает возможности появления других (не обязательно одновременно).

Пример №2

Два стрелка стреляют в мишень.

События

будут совместными случайными событиями.

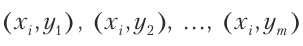

Определение 3. Случайные события

Пример №3

Бросают шестигранный кубик. Обозначим события так

События

В примере 2 события

Определение 4. События называют равновозможными, если нет причин утверждать, что любое из них вероятнее другого.

Пример №4

События — появление 1, 2, 3, 4, 5 или 6 очков при бросании шестигранного кубика — равновозможные, при условии, что центр его тяжести не смещенный.

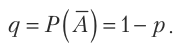

Определение 5. Два несовместных события , которые образуют полную группу , называют противоположными.

Событие, противоположное событию А, обозначается

Пример №5

Если обозначить через А событие, при котором при стрельбе по мишени выбито 8 очков, то событие — при котором при стрельбе по мишени выбито любое другое число очков.

Теперь рассмотрим важное понятие пространства элементарных исходов.

Путь выполняется некоторый эксперимент, который имеет элементы случайности. Каждое испытание может иметь разные исходов.

Так, при бросании монеты могут быть два возможных исхода: герб или надпись

При бросании игрального кубика могут быть шесть возможных исходов.

В испытании «выстрел в мишень» можно рассматривать такие исходы, как попадание в цель, или количество выбитых очков, или координаты точки попадания.

Следовательно, что принимать за исход испытания, зависит от условия задачи.

Определение 6. Элементарными исходами называют такие события, которые невозможно разделить на более простые.

Множество всех возможных элементарных исходов называют пространством элементарных исходов.

Пространство элементарных исходов может содержать конечное, счетное, или несчетное множество элементов.

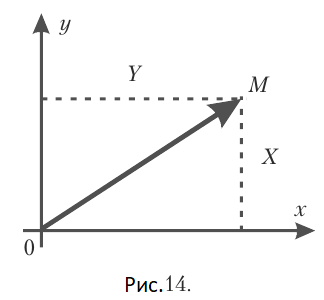

В роли элементарных исходов можно рассматривать точки

В большинстве случаев, которые рассматриваются, допускают, что элементарные исходы равновозможные.

Пример №6

а) При двукратном бросании монеты пространство элементарных исходов содержит 4 точки

где

б) Пусть в мишень стреляют одиночными выстрелами до первого попадания. Возможные такие элементарные события:

и т.д.

В этом случае пространство элементарных исходов может иметь бесконечное количество точек, которые можно путем нумерации перечислить. Поэтому пространство элементарных исходов будет счетным.

в) При производстве кинескопов возникают неодинаковые условия технологического процесса, поэтому время работы кинескопа отличается от его номинального значения, то есть будет случайным событием.

Пространство элементарных исходов в этом случае будет бесконечным несчетным множеством, элементы которого невозможно пронумеровать.

Теперь ознакомимся с алгеброй случайных событий.

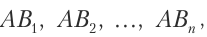

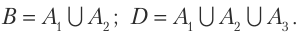

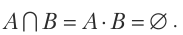

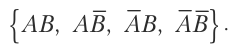

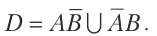

Пусть

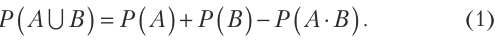

Объединением (суммой) случайных событий

А или В

или

А и В.

Если А и В — несовместимы, то

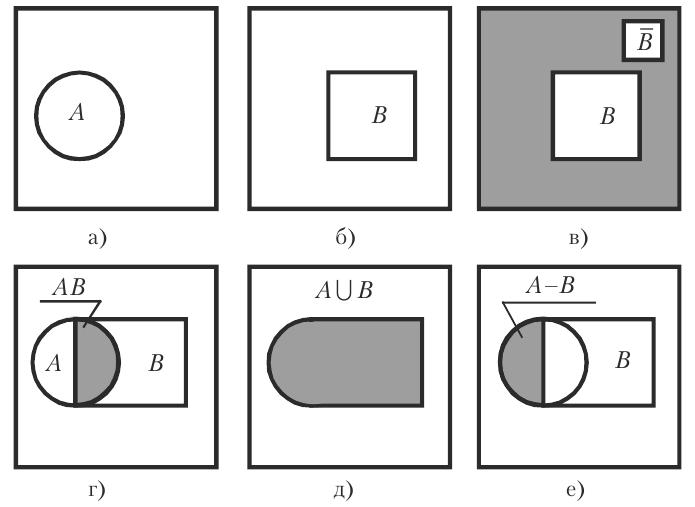

Рис. 1а и 1б. Событие В и противоположное ему

Рис. 1г. Заштрихованная площадь — произведение событий АВ.

Рис. 1д. Заштрихованная площадь — сумма событий

Рис. 1е. Заштрихованная площадь — разность событий

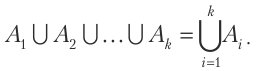

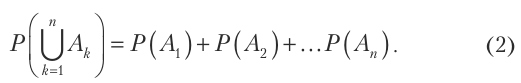

Аналогично определяют объединение (сумму) большего количества случайных событий.

Определение 7. Объединением (суммой) случайных событий

Если события парно несовместимы, то их сумма заключается в том, что должно появиться событие

Пример №7

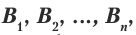

Стрелок совершает один выстрел в мишень, разделенную на три области. Обозначим

событие

событие

событие

событие

событие

событие

Тогда получим

Отметим, что события

Определение 8. Разностью

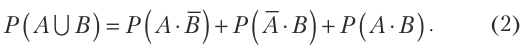

Произведением (пересечением)

Если А и В — несовместимые, то произведение

Таким образом, в случае несовместимости событий

Определение 9. Произведением (пересечением) конечного количества случайных событий

Событие

Указанные соотношения между событиями являются обычными соотношениями между множествами, которые можно представить графически (см. рис.1).

Пример №8

Стрелок стреляет дважды в мишень. Описать пространство элементарных исходов. Записать, событие, которое заключается в том, что:

а) стрелок попал в мишень хотя бы один раз (событие С); б) стрелок попал ровно один раз (событие

Решение.

Обозначим

Событие

событие

Пространство элементарных исходов состоит из четырех событий

а) Если стрелок попал в мишень хотя бы один раз, то это означает, что он попал или с первого выстрела

То есть,

б) Ровно одно попадание может быть только тогда, когда стрелок с первого выстрела попал, а со второго — нет, или с первого выстрела не попал, а со второго — попал.

Поэтому,

в) Если стрелок не попал в мишень, то это означает, что он не попал с обоих выстрелов,

То есть,

Определение и свойства вероятности и частоты

Для сравнения случайных событий по степени их возможности необходимо каждое событие связать с определенным числом, которое должно быть тем больше, чем более возможно событие. Такое число

Определение 1. Вероятностью события является мера степени объективной возможности этого события.

Это определение вероятности определяет философскую суть вероятности, но не показывает закон нахождения вероятности любого события.

Определение 2 (классическое). Вероятность события А равна отношению числа элементарных исходов, которые способствуют появлению события А, к общему числу всех единственно возможных и равновозможных элементарных исходов.

Вероятность события

где

Пример №9

В урне 6 одинаковых по размеру шаров: 2 красных, 3 синих, 1 белый. Найти вероятность появления красного шара, если берут один шар из урны наугад.

Решение. Пусть событие

Замечание 1. При решении многих задач нахождение чисел

Замечание 2. Классическое определение вероятности имеет место только тогда, когда

Если множество элементарных исходов бесконечно или элементарные исходы не равновозможные, то формулой (1) пользоваться нельзя.

Если множество всех элементарных исходов бесконечно и, как следствие, занимает некоторую область

Определение 3 (геометрическое). Вероятность случайного события А равна отношению меры

Замечание 3. Если область

В общем случае меры области определяют аксиомами.

Пример №10

Два туристических парохода должны причалить к одному причалу. Время прибытия обоих пароходов равновозможное в течение суток.

Определить вероятность того, что одному из пароходов придется ждать освобождения причала, если время стоянки первого парохода равно одному часу, а второго — двум часам.

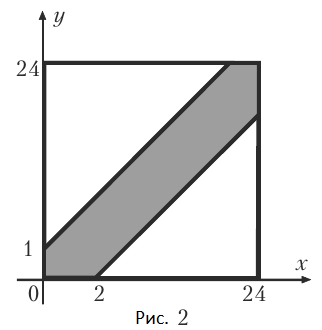

Решение. Пусть

Возможные значения

Благоприятные значения:

Построим эту область (см. рис. 2)

Отношение площади заштрихованной фигуры

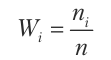

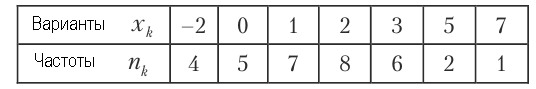

Определение 4. Относительной частотой или частостью события А называют отношение числа испытаний, в которых событие А появилось, к числу фактически выполненных испытаний.

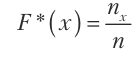

Относительную частоту события А обозначают

где

Пример №11

Отдел технического контроля среди 100 изделий выявил 8 нестандартных. Чему равна относительная частота появления нестандартных изделий?

Решение. Обозначим через

Замечание 4. Подчеркнем, что вероятность

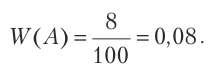

Частота имеет свойство стойкости: при большом количестве испытаний частота изменяется очень мало, колеблясь около некоторого постоянного числа — вероятности появления этого события, то есть

Определение 5. Статистическая вероятность — это относительная частота (частость) или число, близкое к ней.

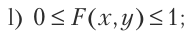

Теперь рассмотрим основные свойства вероятности, используя формулу (1) классического определения вероятности события А.

- Если событие А достоверно, то его вероятность равна единице, то есть

- Если событие А невозможно, то его вероятность равна нулю, то есть

- Если событие А случайное, то его вероятность удовлетворяет соотношение

Действительно, при рассматриваемых условиях достоверное событие обязательно появится, как вследствие, все возможные элементарные исходы способствуют событию А, то есть

Если при условиях, которые рассматриваются, событие А невозможно, тогда среди всех возможных исходов нет тех, которые способствуют событию А, то есть

Если событие А случайное то среди всех

Замечание 5. Последнее свойство вероятности случайных событий используется для осуществления самоконтроля при решении многих задач теории вероятностей.

Основные понятия и принцип комбинаторики

Часто для нахождения чисел

Классификация и свойства таких соединений, а также формулы для вычисления количества разных соединений разработаны математиками и содержатся в разделе «Комбинаторика» курса алгебры.

Ознакомимся с основными понятиями и формулами комбинаторики.

Определение 1. Разные группы, составленные из любых элементов, которые отличаются элементами или порядком этих элементов, называют соединениями или комбинациями этих элементов.

Пример №12

Из цифр

Все возможные соединения целесообразно классифицировать. Соединения бывают трех видов:

— перестановка;

— размещение;

— сочетание.

Определение 2. Соединения из

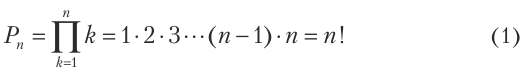

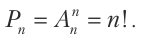

Количество перестановок из

Обозначение

По определению

Пример №13

Сколько пятизначных чисел можно записать, используя пять разных цифр (кроме нуля)?

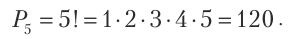

Решение. Соединения, которые образуют из пяти разных цифр пятизначные числа, могут отличаться только порядком цифр, поэтому такие соединения будут перестановкой из 5 элементов. Согласно формуле (1) их количество будет

Определение 3. Размещением из

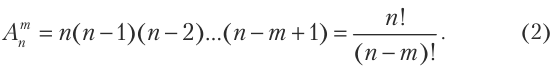

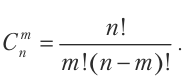

Количество размещений из

Пример №14

Студенты второго курса согласно учебного плана изучают 10 дисциплин. На один день можно планировать занятия по 4 дисциплинам. Сколькими способами можно составить расписание занятий на один день?

Решение. Все возможные расписания занятий на один день — это соединения из 10 по 4, которые могут отличаться дисциплинами или их порядком, то есть эти соединения — размещение. Количество таких размещений согласно формуле (2) будет

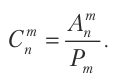

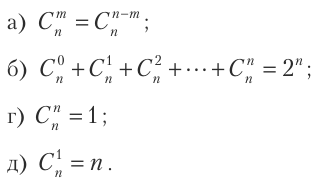

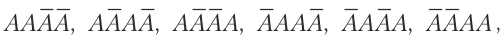

Определение 4. Сочетанием из

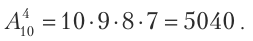

Количество сочетаний из

Замечание 1. Перестановку можно рассматривать как частный случай размещения

Между количеством перестановок, размещений и сочетаний сцуществует простая связь

Часто целесообразно использовать такие свойства соединений:

Пример №15

В ящике 10 изделий, из которых 2 нестандартные. Наугад берут 6 изделий. Какая вероятность того, что все взятые изделия будут стандартными?

Решение. Обозначим событие

Поэтому количество всех возможных элементарных исходов будет

Событию

Следовательно, согласно классическому определению вероятности события А, получим

Теперь ознакомимся с основными принципами комбинаторики.

Принцип суммы. Если множество

Доказательство. Осуществляется простым подсчетом элементов множества

Сначала считаем все элементы множества А. Они получат номера от 1 до

Теперь будем считать элементы множества

Таким подсчетом все элементы множества

Замечание 2. Принцип суммы имеет место для суммы

Принцип произведения. Если множество

Доказательство. Множество С разобьем на подмножества

Поскольку

Аналогично получаем, что

Теперь докажем, что

Действительно, пусть

Пример №16

В корзине 4 яблока первого сорта и 5 яблок второго сорта. Наугад берут 2 яблока. Найти вероятность того, что будут взяты яблоки разных сортов.

Решение. Пусть событие А — наугад взятые 2 яблока разных сортов.

Всего яблок 9, из них сочетаний по 2 будет

Событию А будут способствовать сочетания, созданные из пар, элементами которых будут яблоки разных сортов. Согласно принципу умножения, количество таких пар будет равно

Используя классическое определение вероятности, получим искомую вероятность события А

Основные теоремы теории вероятностей

Основными теоремами теории вероятностей являются две: теорема сложения вероятностей и теорема умножения вероятностей. Обе эти теоремы являются теоремами и могут быть доказаны только для событий, сводящихся к схеме случаев.

Сложение вероятностей несовместных событий

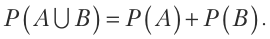

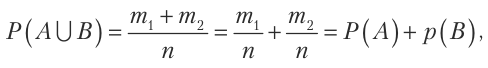

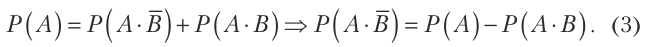

Теорема 1. Вероятность объединения двух случайных несовместных событий равна сумме их вероятностей

Доказательство. Пусть число всех возможных элементарных исходов появления событий А и В равно

то есть утверждение теоремы доказано.

Совсем аналогично можно доказать следующее утверждение.

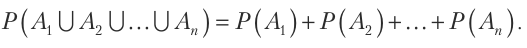

Теорема 2. Если случайные события

Пример №17

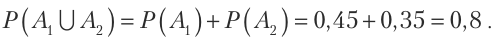

Вероятность попадания стрелком в первую область мишени равна 0,45, во вторую область — 0,35, в третью — 0,15. Найти вероятность того, что с одного выстрела стрелок попадет в первую или вторую область мишени.

Решение. Обозначим событием

С одного выстрела события

Теорема 3. Сумма вероятностей полной группы случайных событий равна единице

Доказательство. Если случайные события

Вероятность достоверного события равна единице, поэтому

Левые части равенств (2) и (3) одинаковые, поэтому правые части будут равными, то есть имеет место равенство (1). Теорема доказана.

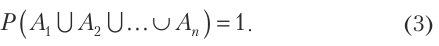

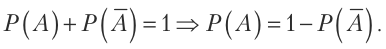

Следствие. Два противоположных события

из которого получаем формулу

нахождения вероятности противоположного события.

Пример №18

Вероятность получить сообщение от определенного лица в течение суток равна 0,25. Найти вероятность того, что сообщение в течение суток от этого лица не будет получено.

Решение. Обозначим событием А — сообщение от этого лица в течение суток поступит. По условию задачи имеет место соотношение

В страховом деле необходимо высчитывать, например, такую задачу.

Пример №19

По статистическим показателям государства можно сделать вывод, что 68% мужчин, которые достигли 60-тилетия, достигают также и 70-тилетия. Какая вероятность того, что 60-тилетний мужчина не достигнет своего 70-тилетия?

Решение. Если событие А — 60-тилетний мужчина достигает своего 70-тилетия, то противоположное событие

Следовательно, используя статистические данные государства, можно вычислить вероятность того, что 32% 60-тилетних мужчин умрет в течение 10 лет.

Зависимые и независимые события, условные вероятности

Определение 1. Случайные события А и В называют зависимыми, если вероятность появления одного из них зависит от появления или непоявления второго события.

Если вероятность появления одного события не зависит от появления или непоявления второго, то такие события называют независимыми.

Определение 2. Вероятность события В, вычисленная при условии появления События А, называют условной вероятностью события В и обозначают

Пример №20

В урне 10 шаров: 3 белых и 7 черных. Наугад берут два шара. Пусть событие А — взят белый шар; событие В — взят черный шар.

Если шар, который взяли первым, возвращают в урну, то вероятность появления второго шара не зависит от того, какой взят первый шар.

Если первый шар не возвращается в урну, то вероятность второго события зависит от результата первого испытания.

Если первым взяли белый шар, то в урне осталось 2 белых шара и 7 черных, поэтому

Если первым взяли черный шар, то в урне осталось 3 белых шара и 6 черных шаров, поэтому

Следовательно, вероятность события В зависит от появления или непоявления события А.

Замечание. Если события А и В независимые, то условная вероятность равна безусловной вероятности, то есть

Умножение вероятностей

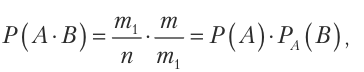

Теорема 4. Вероятность совместного появления двух случайных событий А и В равна произведению вероятностей одного из этих событий и условной вероятности второго события при условии, что первое событие появилось

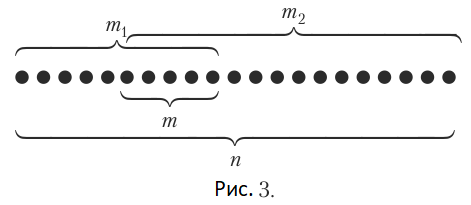

Доказательство. Все элементарные исходы изобразим в виде точек (рис. 3).

Пусть появлению события А способствуют

Так как

то

что и требовалось доказать.

Соотношения (1) называют формулой умножения вероятностей зависимых случайных событий.

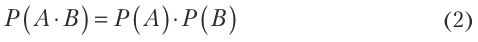

Следствие. В случае независимых случайных событий А и В формула (1) принимает вид

и называется формулой умножения вероятностей независимых случайных событий.

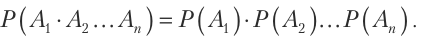

В случае конечного количества независимых случайных событий Формула (2) принимает вид

Пример №21

В некотором сообществе людей 70% курят, 40% болеют раком легких и 25% курят и имеют рак легких. Найти вероятность того, что наугад взятое человек из этого общества:

а) не курит, но имеет рак легких;

б) курит, но не имеет рак легких;

в) никогда не курит и не имеет рак легких;

г) или курит или имеет рак легких.

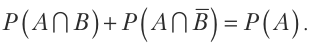

Решение. Обозначим события: А — человек курит; В — человек болеет раком легких. Тогда по условию задачи получим

Пример №22

Привести иллюстративную диаграмму свойства

Ответ. См. рис. 4.

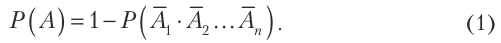

Вероятность появления хотя бы одного случайного события

Пусть существует

Отсюда получим

По этой формуле необходимо вычислять вероятность появления хотя бы одного случайного события из

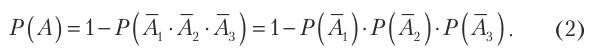

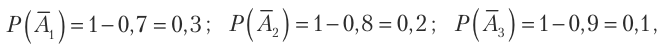

Пример №23

Вероятность попадания в мишень первого стрелка равна 0,7, второго стрелка — 0,8, а третьего стрелка — 0,9. Найти вероятность попадания в мишень хотя бы одного стрелка.

Решение. Обозначим события

По условию задачи события

Согласно формуле (1) и формуле умножения вероятностей независимых событий получим

Так как

то по формуле (2) получим

Теорема сложения вероятностей совместных событий

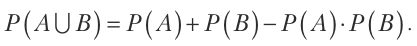

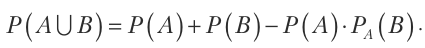

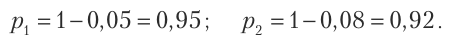

Теорема 5. Если случайные событие А и В совместные, то вероятность их объединения равна сумме их вероятностей без вероятности их совместного появления, то сеть

Доказательство. Согласно условию теоремы события А и В совместные, поэтому

Согласно теореме сложения вероятностей несовместных событий получим

Событие А появится, если появится одно из двух несовместных событий

Согласно теореме сложения вероятностей несовместных событий

Аналогично получим

Подставим (3) и (4) в формулу (2), тогда получим равенство (1), которое требовалось доказать.

Замечание. Если события А и В независимые, то формула (1) принимает вид

Для зависимых случайных событий получим

Пример №24

В зависимости от наличия сырья предприятие может производить и отправлять заказчикам ежедневно количество определенной продукции от 1 до 100. Какая вероятность того, что полученное количество продукции можно распределить без остатка

а) трем заказчикам;

б) четырем заказчикам;

в) двенадцати заказчикам;

г) трем или четырем заказчикам?

Решение. Обозначим события

А — полученное количество изделий делится на 3 без остатка;

В — полученное количество изделий делится на 4 без остатка.

Используя классическое определение вероятности, находим

События А и В — совместные, поэтому по формуле (1) получим

Надежность системы

Определение 1. Надежностью системы называют вероятность ее безотказной работы в определенное время

Системы состоят из элементов, соединенных последовательно

или параллельно

При вычислении надежности систем необходимо выразить надежность системы через надежность элементов и блоков.

Надежность элементов считается известной, так как она связана с технологией их производства.

Обозначим

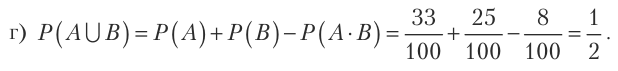

Рассмотрим блок, все элементы которого независимые и соединенные последовательно (см. рис. 5).

Такой блок будет работать безотказно только в то время, когда все элементы работают безотказно. Согласно теореме умножения вероятностей независимых событий вероятность

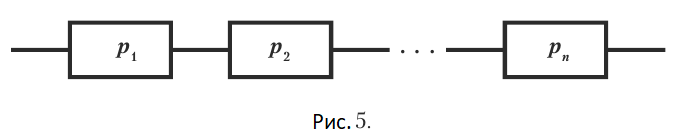

Теперь рассмотрим блок, элементы которого соединенные параллельно (см. рис. 6).

Такой блок будет работать безотказно, если хотя бы один элемент не выйдет из строя. Поэтому вероятность

Любую сложную систему можно рассматривать как последовательное или параллельное соединение блоков, надежность которых вычисляют по формулам (1) и (2).

Пример №25

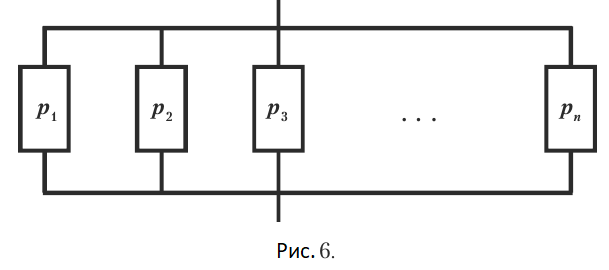

Прибор собран из двух блоков, соединенных последовательно и независимо работающих. Вероятность отказа блоков равна 0,05 и 0,08. Найти вероятность отказа прибора.

Решение. Отказом прибора является событие противоположное его безотказной работе. Вероятности безотказной работы блоков составят

Вероятность безотказной работы прибора составит согласно формуле (1)

Поэтому вероятность отказа прибора составит

Формулы полной вероятности и Байеса

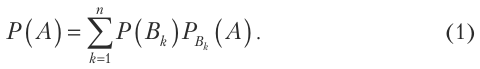

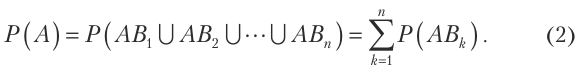

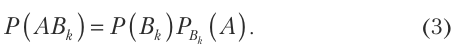

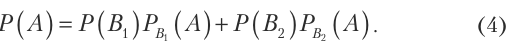

Теорема 6. Если случайное событие А может появится только совместно с одним из несовместных между собой событий

Доказательство. По условию теоремы появление события А означает появление одного из событий

События

События А и

Подставим (3) в формулу (2) и получим равенство (1), которое требовалось доказать.

Формулу (1) называют формулой полной вероятности.

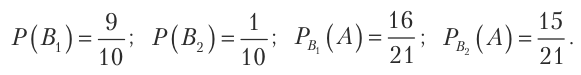

Пример №26

В первом ящике 20 деталей, из которых 15 стандартных. Во втором ящике 0 деталей, из которых 9 стандартных. Из второго ящика берут наугад одну деталь и перекладывают ее в первый ящик. Найти вероятность того, что взятая после этого наугад деталь из первого ящика стандартная.

Решение. Обозначим такие события: А — из первого ящика взята стандартная деталь;

Согласно условия задачи, из первого ящика модно взять деталь только после того, как произойдет событие

События

Найдем нужные вероятности

Подставим эти значения в формулу (4) и получим

Теперь познакомимся с формулами Байеса.

По условиям Теоремы 1 неизвестно, с каким событием из несовместных событий

Если испытание проведено и в результате его событие А появилось, то условная вероятность

Сравнение вероятностей

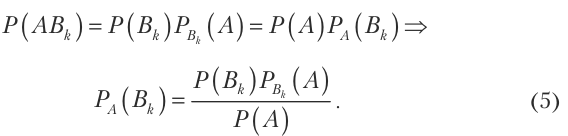

Для получения условной вероятности используем теорему умножения вероятностей зависимых событий

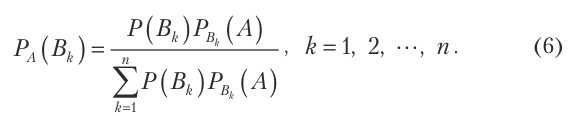

Подставим в формулу (5) вместо

Формулы (6) называют формулами Байеса. Они позволяют переоценить вероятности гипотез. Это важно при контроле или ревизиях.

Пример №27

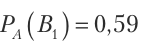

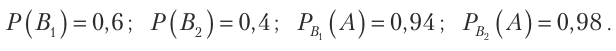

Детали, изготовленные цехом завода, попадают для проверки их стандартности к одному из двух контролеров. Вероятность того, что деталь попадет к первому контролеру равна 0,6, а ко второму — 0,4. Вероятность того, что пригодная деталь будет признана стандартной первым контролером равна 0,94, а вторым — 0,98.

Пригодная деталь при проверке признана стандартной. Найти вероятность того, что деталь проверял первый контролер.

Решение. Обозначим такие события: А — пригодная деталь признана стандартной;

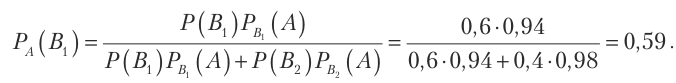

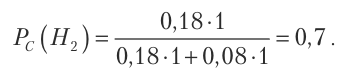

По формуле Байеса (6) при

Отметим, что до появления события А вероятность

Пример №28

Вероятность уничтожения самолета с одного выстрела для первой пушки равна 0,2, а для второй пушки — 0,1. Каждая пушка делает по одному выстрелу, причем было одно попадание в самолет. Какая вероятность того, что попала первая пушка?

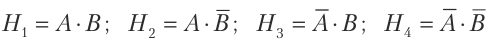

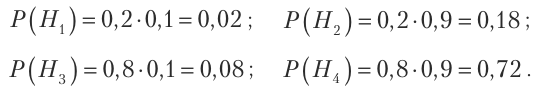

Решение. Обозначим такие события: А — уничтожение самолета с первого выстрела первой пушкой; В — уничтожение самолета с первого выстрела второй пушкой; С — одно попадание в самолет. Имеем четыре гипотезы

которые образуют полную группу событий. Вероятностями этих гипотез будут

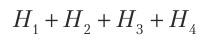

Так как сумма

является достоверным событием, то

Условные вероятности события С будут

Теперь по формуле Байеса находим искомую вероятность

Последовательности испытаний

Схемой Бернулли или последовательностью независимых одинаковых испытаний, или биномиальной схемой испытаний называют последовательность n испытаний, удовлетворяющих условиям.

Схема и формула Бернулли

Во многих задачах теории вероятностей, статистике и повседневной практике необходимо исследовать последовательность (серию)

Определение 1. Если все

Пусть случайное событие А может появится в каждом испытании с вероятностью

Поставим задачу: найти вероятность того, что при

Сначала рассмотрим появление события А три раза в четырех испытаниях. Возможны такие события

то есть их

Если событие А появилось 2 раза в 4 испытаниях, то возможны такие события

их

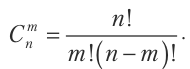

В общем случае, когда событие А появляется

Вычислим вероятность одного сложного события, например

Вероятность совместного появления

Количество таких сложных событий

Формулу (1) называют формулой Бернулли .Она позволяет находить вероятность появления события А

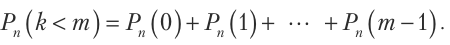

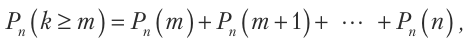

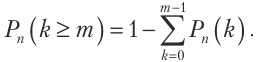

Замечание 1. Вероятность появления события А в

Вероятность появления события А не менее

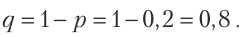

или по формуле

Вероятность появления события А хотя бы один раз в

Замечание 2. Во многих случаях необходимо находить наиболее вероятное значение

Число

Замечание 3. Если вероятность появления события А в каждом испытании равна

Пример №29

Прибор собран из 10 блоков, надежность каждого из них 0,8. Блоки могут выходить из строя независимо друг от друга. Найти вероятность того, что

а) откажут два блока;

б) откажет хотя бы один блок;

в) откажут не менее двух блоков.

Решение. Обозначим событием А отказ блока. Тогда вероятность события А по условию примера будет

Согласно условию задачи

Пример №30

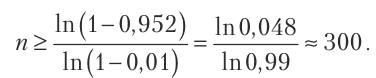

За один час автомат производит 20 деталей. За сколько часов вероятность производства хотя бы одной бракованной детали будет не менее 0,952, если вероятность брака любой детали равна 0,01?

Решение. Используя формулу (2), найдем сначала такое количество произведенных деталей, чтобы с вероятностью

Следовательно, за время

Пример №31

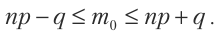

При новом технологическом процессе 80% всей произведенной продукции имеет наивысшее качество. Найти наиболее вероятное число произведенных изделий наивысшего качества среди 250 произведенных изделий.

Решение. Обозначим искомое число

Согласно Замечанию 2

По условию примера

Но

Предельные теоремы в схеме Бернулли

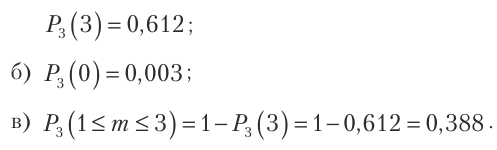

Нахождение вероятностей

Укажем без доказательства три предельных теоремы, которые содержат приближенные формулы для вероятностей

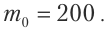

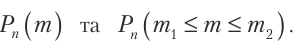

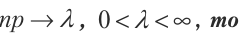

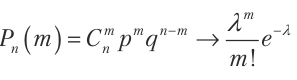

Теорема 1 (Теорема Пуассона). Если

для любого постоянного

Следствие. Вероятность появления события А

где

Формулу (1) целесообразно применять при больших

Пример №32

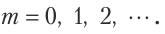

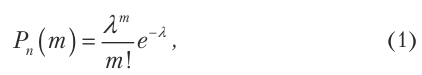

Учебник напечатан тиражом 100000 экземпляров. Вероятность неправильной брошюровки учебника равна 0,0001. Найти вероятность того, что тираж имеет 5 бракованных учебников.

Решение. Брошюровку каждого учебника можно рассматривать как испытание. Испытания независимые и имеют одинаковую вероятность неправильной брошюровки, поэтому задача укладывается в схему Бернулли. Согласно условию задачи

Используя формулу Пуассона (1), получим

Для приведения еще двух предельных теорем необходимо сначала определить локальную и интегральную функции Лапласа и ознакомится с их основными свойствами.

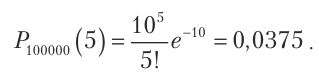

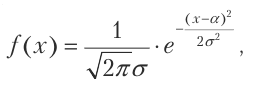

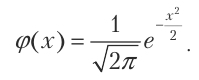

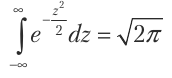

Определение 1. Локальной функцией Лапласа называют функцию вида

Эта функция часто используется, поэтому ее значение для разных

Основные свойства локальной функции Лапласа

- Функция Лапласа

четная, то есть

- Функция

определена для всех

-

когда

-

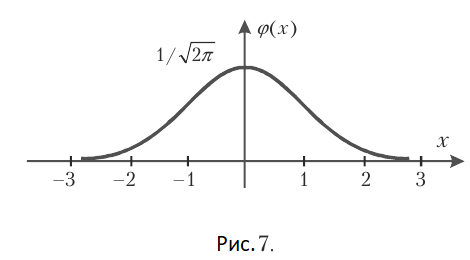

График локальной функции Лапласа имеет вид, показанный на рис. 7.

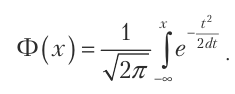

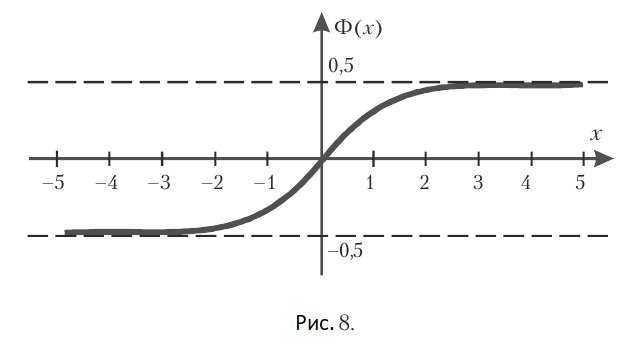

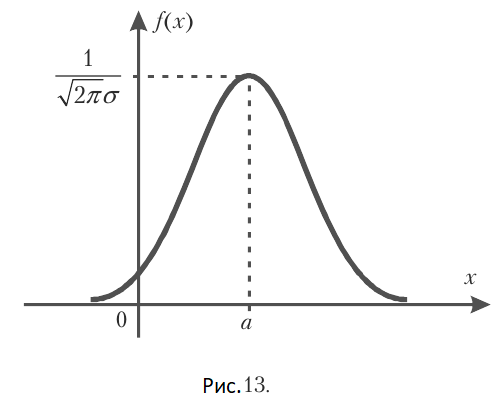

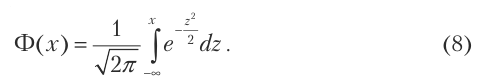

Определение 2. Интегральной функцией Лапласа называют функцию

Легко увидеть, что между локальной функцией

Основные свойства интегральной функции Лапласа

- Интегральная функция Лапласа является нечетной функцией

-

-

График интегральной функции Лапласа изображен на рис. 8.

Интегральная функция Лапласа

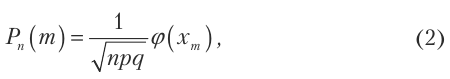

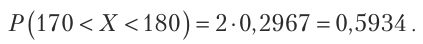

Теорема 2 (Локальная теорема Муавра-Лапласа). Если в схеме Бернулли количество испытаний

где

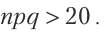

Замечание. Формулу (2) целесообразно использовать при

Пример №33

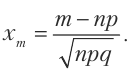

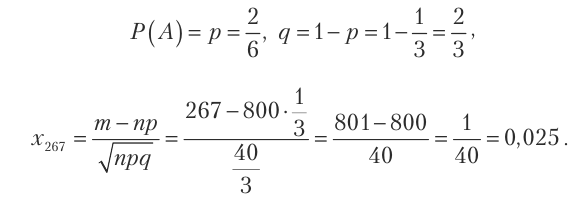

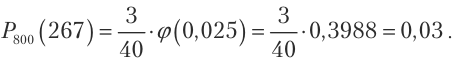

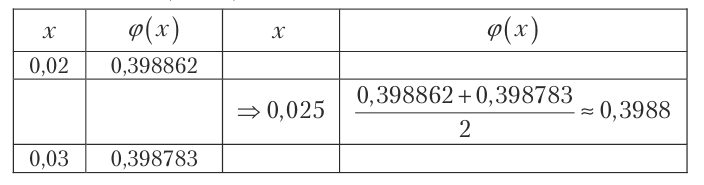

Игральный кубик бросают 800 раз. Какая вероятность того, что количество очков, кратное трем, появится 267 раз.

Решение. В данном случае

Следовательно, по формуле (2) получим

Значение

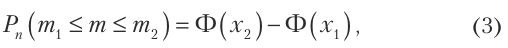

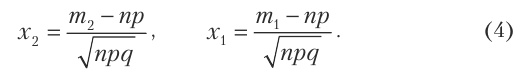

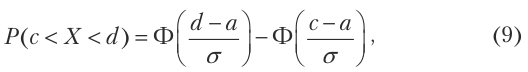

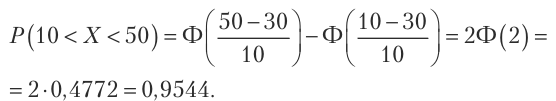

Теорема 3 (Интегральная теорема Муавра-Лапласа). Если в схеме Бернулли в каждом из

где

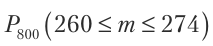

Пример №34

Игральный кубик бросают 800 раз. Какая вероятность того, что количество очков, кратное трем, появится не меньше 260 и не больше 274 раз?

Решение. Для нахождения вероятности

используем формулы (4) и (3). Получим

Значение интегральной функции Лапласа взято из таблицы и применяется свойство нечетности

Последовательность испытаний с разными вероятностями

В схеме Бернулли вероятность появления события А во всех испытаниях одинаковая. Но на практике иногда встречаются и такие случаи, когда в

Тогда вероятности непоявления события А также будут разными

В этом случае нельзя вычислять по формуле Бернулли вероятность появления события А

Правило. Искомая вероятность

Пример №35

Вероятности отказа каждого из 4 приборов в 4 независимых испытаниях разные и равны

Найти вероятность того, что вследствие испытаний

а) не откажет ни один прибор;

б) откажут один, два, три, четыре прибора;

в) откажет хотя бы один прибор;

г) откажут не менее двух приборов.

Решение. Вероятности отказа приборов в испытаниях разные, поэтому используем производную функцию (1), которая в данном случае имеет вид

Раскроем скобки и приведем подобные члены. Тогда получим

Согласно Правилу, отсюда получаем ответы на вопросы примера

Пример №36

Работник обслуживает три станка, которые работают независимо друг от друга. Вероятность того, что в течение часа первый станок не потребует внимания работника, равна 0,9, а для второго и третьего станков — 0,8 и 0,85 соответственно. Какой является вероятность того, что в течение часа

а) ни один станок не потребует внимания работника;

б) все три станка потребуют внимания работника;

в) хотя бы один станок потребует внимания работника?

Решение. Этот пример можно решить с использованием теорем умножения и сложения вероятностей (смотри упражнение 15 Раздела 2). Решим теперь этот пример с использованием производной функции, которая в данном случае принимает вид

Следовательно, коэффициент при

а) вероятность того, что все три станка не потребуют внимания работника равна коэффициенту при

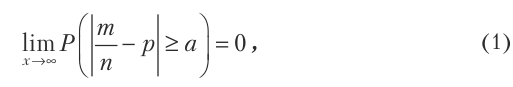

Теорема Бернулли

Теорема Бернулли устанавливает связь теории вероятностей с ее практическим использованием. Она была доказана Я. Бернулли в конце

Теорема 4 (Я. Бернулли). Если в

Согласно определению предела равенство (1) означает, что

Это означает, что событие

практически невозможно. Но тогда противоположное событие

практически достоверно для любого положительного числа

Следствие теоремы Бернулли

Равенство

может отличаться от практически достоверного события

Это значит, что

Другую формулировку и доказательство теоремы Бернулли смотри в подразделе 4.4.3 Раздела 4.

Замечание. Формулу (1) можно записать, используя интегральную функцию Лапласа

Отсюда получим важную формулу

которая позволяет решать много задач.

Пример №37

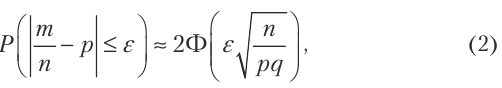

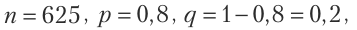

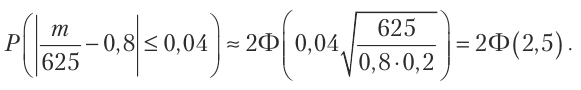

Вероятность появления события в каждом из 625 независимых испытаний равна 0,8. Найти вероятность того, что частота появления события отклоняется от вероятности по абсолютной величине не больше чем на 0,04.

Решение. По условию примера

По формуле (2) получим

Из таблицы значений функции Лапласа

Таким образом, искомая вероятность приближенно равна

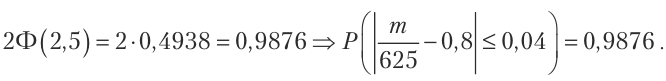

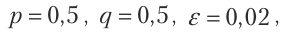

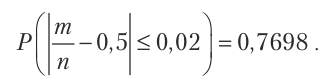

Пример №38

Вероятность появления события в каждом из независимых испытаний равна 0,5. Найти число испытания

Решение. По условию задачи

Используем формулу (2). Тогда согласно условию получим

По таблице значений интегральной функции Лапласа найдем

Следовательно, искомая вероятность испытаний

Пример №39

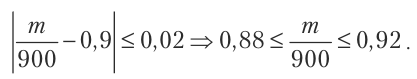

Отдел технического контроля проверяет стандартность 900 изделий. Вероятность того, что изделие стандартное, равна 0,9. Найти с вероятностью 0,9544 границы интервала, который содержит число

Решение. По условию

По таблице значений интегральной функции Лапласа находим

Следовательно, с вероятностью 0,9544 отклонение частоты количества стандартных изделий от вероятности 0,9 удовлетворяет неравенство

Из последних соотношений следует, что искомое число

Простой поток событий

Определение 1. Потоком событий называют последовательность таких событий, которые появляются в случайные моменты времени.

Например, заявление в диспетчерский пункт по вызову такси.

Определение 2. Поток событий называется пуассоновским, если он:

- Стационарный, то есть зависит от количества

появлений событий и времени

и не зависит от момента своего начала.

- Имеет свойство отсутствия последействия, то есть вероятность появления события не зависит от появления или не появления события раньше и влияет на ближайшее будущее.

- Ординарный, то есть вероятностью появления больше одного события за малый промежуток времени является величина бесконечно малая по сравнению с вероятностью появления события один раз в этот промежуток времени.

Определение 3. Среднее число

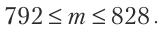

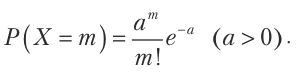

Теорема 5. Если поток событий пуассоновский, то вероятность появления события А

где

Замечание 1. Формулу (1) иногда называют математической моделью простого потока событий.

Пример №40

Среднее количество заказов, которые поступают в комбинат бытового обслуживания каждый час, равно 3. Найти вероятность того, что за два часа поступят

а) 5 заказов;

б) меньше 5 заказов;

в) не меньше 5 заказов.

Решение. Имеем простой поток событий с интенсивностью

Замечание 2. Примерами простого потока могут быть: появление вызовов на АТС, на пункты скорой медицинской помощи, прибытие самолетов в аэропорт или клиентов на предприятие бытового обслуживания, серия отказов элементов или блоков приборов и так далее.

Случайны величины

Случайные величины бывают:

- непрерывные – значения которых непрерывно заполняют какой-либо промежуток (например: давление крови человека, температура его тела или состав крови);

- дискретные – принимающие отдельные друг от друга значения (например: число звонков на станцию скорой помощи в течение часа или количество очков, выпадающих при бросании игрального кубика).

Виды случайных величин и способы их задания

При исследовании многих проблем возникают такие случайные события, исходом которых является появление некоторого числа, заранее неизвестного. Поэтому такие числовые значения — случайные.

Примером такого события является: количество очков, которое выпадает при бросании игрального кубика; количество студентов, которые придут на лекцию; количество сахарной свеклы, которое ожидают получить с одного гектара.

Случайной величиной называют такую величину, которая вследствие испытания может принять только одно числовое значение, заранее неизвестное и обусловленное случайными причинами.

Случайные величины целесообразно обозначать большими буквами

Случайные величины бывают дискретными и непрерывными.

Определение 1. Дискретной случайной величиной (ДСВ) называют такую величину, которая может принимать отдельные изолированные друг от друга числовые значения (их можно пронумеровать) с соответствующими вероятностями.

Пример:

Количество попаданий в мишень при трех выстрелах будет

Количество вызовов такси

Определение 2. Непрерывной случайной величиной (НСВ) называют величину, которая может принимать любое числовое значение из некоторого конечного или бесконечного интервала

Пример:

Величина погрешности, которая может быть при измерении расстояния; время безотказной работы прибора; рост человека; размеры детали, которую производит станок-автомат.

Пример:

Рассмотрим случайные величины: количество очков,

Вероятность появления любого значения

Таким образом, для полной характеристики случайной величины необходимо указать не только все ее возможные значения, а и закон, по которому находят вероятности каждого значения

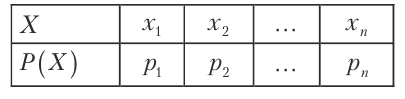

Определение 3. Законом распределения случайной величины называют такое соотношение, которое устанавливает связь между возможными значениями случайной величины и соответствующими им вероятностями.

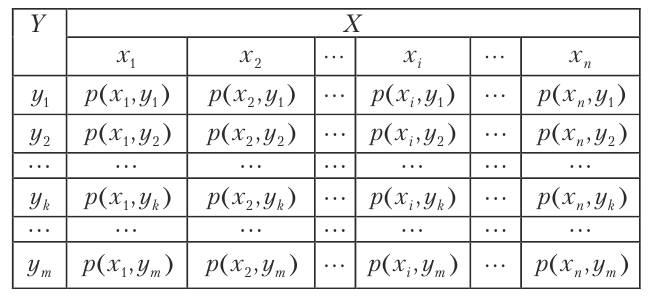

В случае дискретной случайной величины

В экономических дисциплинах все эти способы задания ДСВ имеют другие названия, поэтому ознакомимся с ними более детально в следующем разделе.

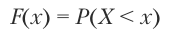

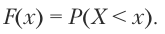

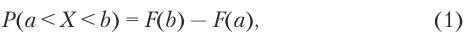

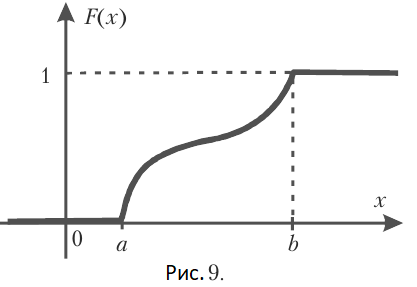

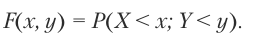

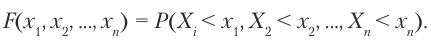

Определение 4. Интегральной функцией распределения (функцией распределения) называют вероятность того, что случайная величина

Функцию распределения обозначают

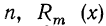

Если НСВ

Формулу (1) часто называют основной формулой теории вероятностей.

Замечание. Непрерывная случайная величина

Определение интегральной функции распределения и свойства вероятности

График функции распределения

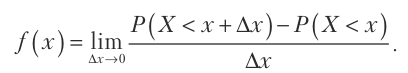

Определение 5. Дифференциальной функцией распределения или плотностью вероятностей непрерывной случайной величины называют производную первого порядка от ее интегральной функции распределения и обозначают

Название «плотность вероятностей» следует из равенства

Из формулы (2) следует, что функция распределения

Теорема 1. Вероятность того, что непрерывная случайная величина

Доказательство. Интегральная функция распределения

Правые части равенств (1) и (4) равные, поэтому и левые их части равные, то есть имеет место равенство (3), которое и требовалось доказать.

Следствие. Если дифференциальная функция распределения (плотность вероятности)

Дифференциальная функция распределения НСВ

График плотности вероятности

Пример №41

Случайная величина имеет плотности вероятностей

Решение. Параметр

Следовательно, получим

Функцию распределения найдем по формуле (5)

Пример №42

Случайная величина

Определить область значений случайной величины

Решение. Согласно свойствам функции распределения получим

поэтому должны выполняться условия

Если область значений случайной величины

Но в промежутке

Теперь найдем вероятность

Из равенства (6) получаем

Теперь по формуле (7) находим

Законы распределения и числовые характеристики дискретных случайных величин

Законом распределения дискретной случайной величины называют соответствие между полученными на опыте значениями этой величины и их вероятностями.

Способы задания и законы распределения

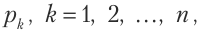

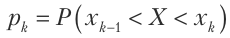

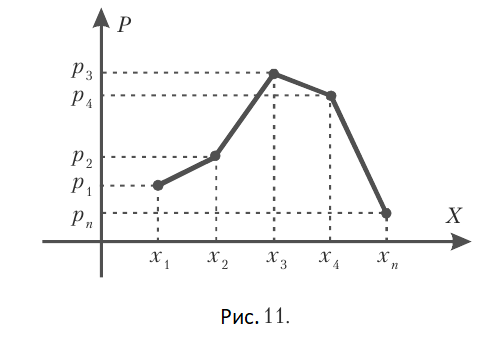

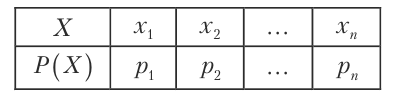

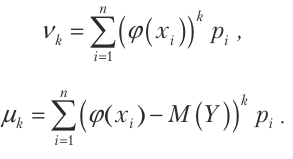

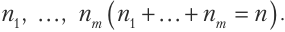

Пусть случайная дискретная величина

Задать закон распределения такой случайной величины — это задать равенство

Поэтому закон распределения

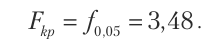

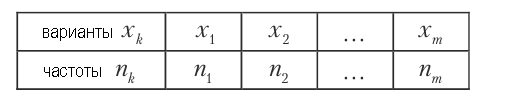

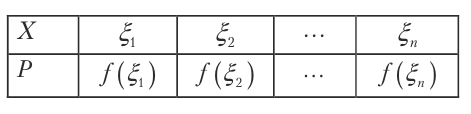

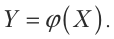

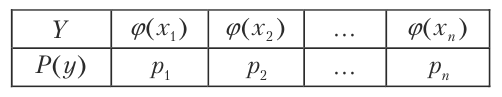

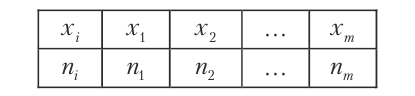

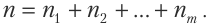

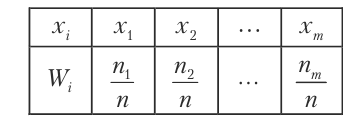

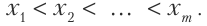

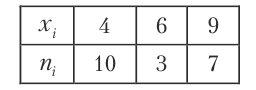

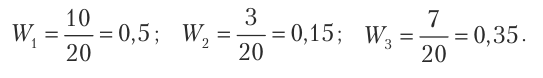

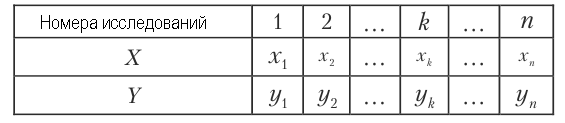

Чаще всего используют табличный способ задания ДСВ, который называют рядом распределения и изображают в виде

В первом ряду записаны все возможные значения

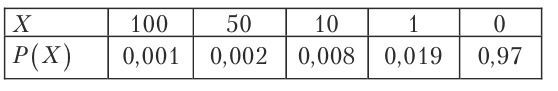

Пример №43

Условиями лотереи предусмотрены: один выигрыш — 100 рублей, два — 50 рублей, восемь — 10 рублей, девятнадцать — 1 рубль. Найти закон распределения суммы выигрыша владельцем одного лотерейного билета, если продано 1000 билетов.

Решение. Будем искать закон распределения суммы выигрыша

где

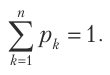

Замечание 1. Если случайная дискретная величина может принимать бесконечное количество значений, то ее ряд распределения (таблица) будет иметь бесконечное количество элементов в каждом ряду, причем ряд

Графический способ. Возьмем прямоугольную систему координат. На оси абсцисс будем откладывать возможные значения ДСВ, а на оси ординат — соответствующие значения вероятности. Получим точки с координатами

Соединив эти точки прямыми, получим график (см. рис. 11) в виде многоугольника распределения случайной дискретной величины.

Значение ДСВ, вероятность которой самая большая, называют модой. На рисунке 11 мода —

Аналитический способ задания дискретной случайной величины основан на задании определенной функции, по которой можно найти вероятность

Укажем некоторые важнейшие законы распределения ДСВ и задачи, в которых они встречаются.

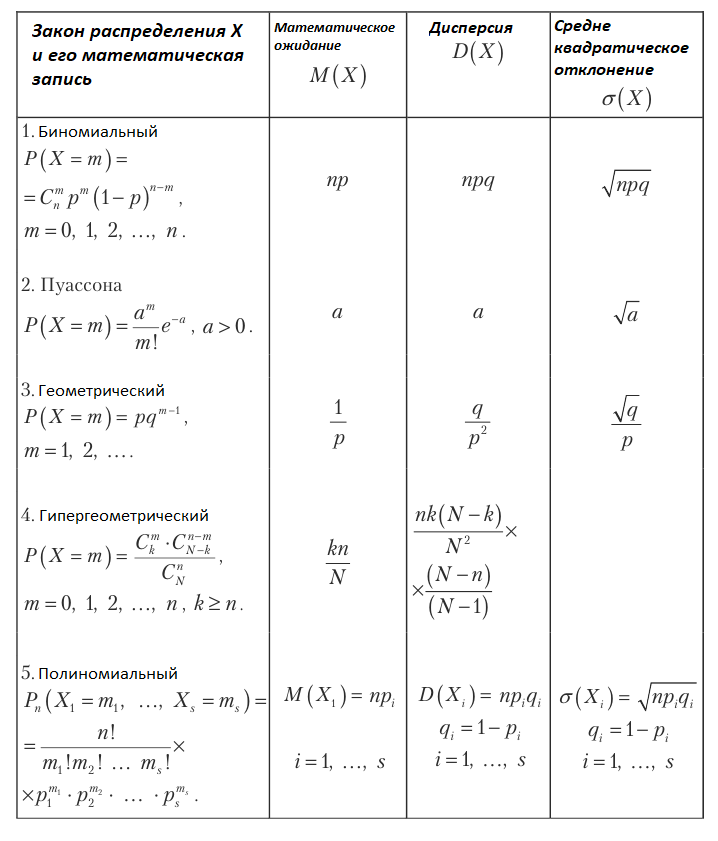

Биномиальный закон распределения

Этот закон имеет вид

и используется в схеме Бернулли, то есть в случае

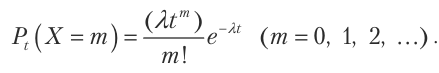

Закон распределения Пуассона

ДСВ

Это распределение используют в задачах статистического контроля качества, в теории надежности, теории массового обслуживания, для вычисления: количества требований на выплату стразовых сумм за год, количества дефектов одинаковых изделий.

Если в схеме независимых повторяющихся событий

Замечание 2. Если в формулу Пуассона поставить

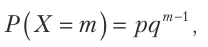

Геометрическое распределение

Это распределение имеет вид

где

Ряд вероятностей этого распределения бесконечно убывающей геометрической прогрессией со знаменателем

Геометрическое распределение используют в разнообразных задачах статистического контроля качества приборов, в теории надежности и в страховых расчетах.

Гипергеометрическое распределение

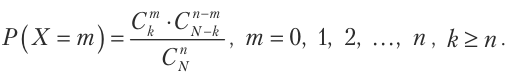

Это распределение имеет вид

Оно показывает вероятность появления

Это распределение используют во многих задачах статистического контроля качества.

Замечание 3. Если объем выборки

В статистике это означает, что расчеты вероятностей для бесповторной выборки будут мало отличаться от расчетов вероятностей для повторной выборки.

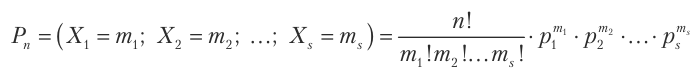

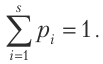

Полиномиальное распределение

Это распределение имеет вид

Оно применяется тогда, когда вследствие каждого из проведенных повторяющихся независимых испытаний может появится

Числовые характеристики

Законы распределения ДСВ полностью характеризуют случайные величины и позволяют решать все связанные с ними задачи.

Но в практической деятельности не всегда удается получить закон распределения, или закон слишком сложный для практических расчетов. Поэтому появилась необходимость характеризовать ДСВ с помощью числовых характеристик, которые достаточно характеризуют особенности случайных величин.

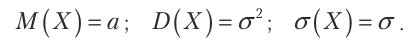

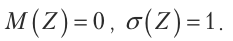

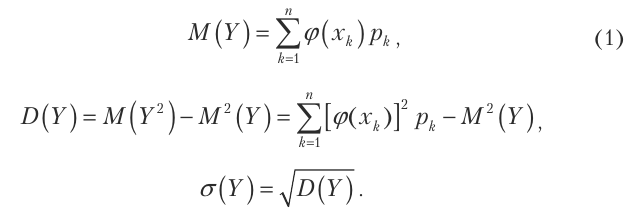

Чаще всего используют три числовых характеристики: математическое ожидание, дисперсию и среднеквадратическое отклонение от математического ожидания.

Ознакомимся с этими числовыми характеристиками и их свойствами.

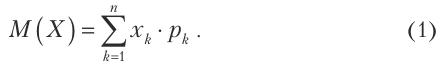

Математическое ожидание и его основные свойства

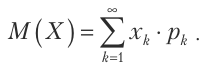

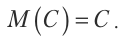

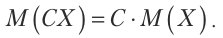

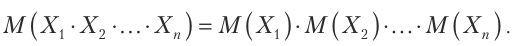

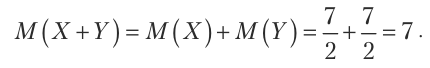

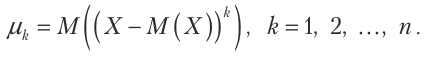

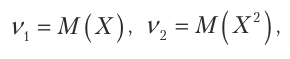

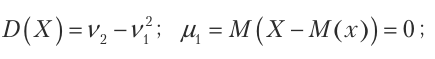

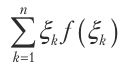

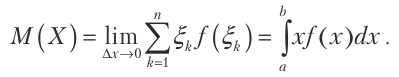

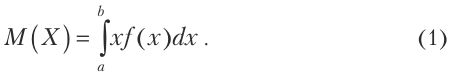

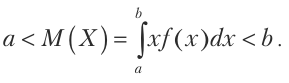

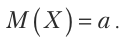

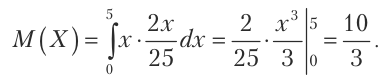

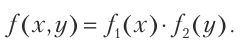

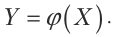

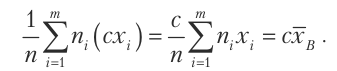

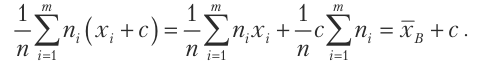

Определение 1. Математическим ожиданием дискретной случайной величины

Математическое ожидание ДСВ

Если

Математическое ожидание ДСВ

Основные свойства математического ожидания

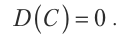

1. Математическое ожидание постоянной величины равно самой постоянной

2. Постоянный множитель можно выносить за знак математического ожидания

Свойства 1 и 2 следуют непосредственно из Определения 1.

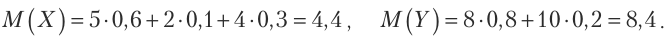

3. Математическое ожидание произведения нескольких взаимно независимых дискретных случайных величин равно произведению их математических ожиданий, то сеть

Доказательство. Если две величины

(для упрощения выкладок взято только по 2 возможных значения), тогда закон распределения произведения

По формуле (1) получим математическое ожидание

В случае трех случайных величин получим

Методом математической индукции теперь не сложно завершить доказательство.

Аналогично, но немного сложнее, можно доказать следующее свойство.

4. Математическое ожидание суммы случайных величин равно сумме их математических ожиданий, то есть

Пример №44

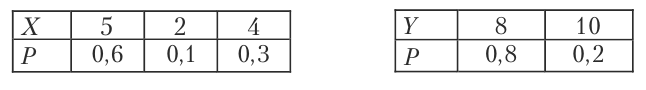

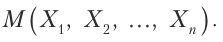

Независимые случайные величины

Найти математическое ожидание случайной величины

Решение. Сначала найдем математические ожидания каждой их этих величин. По формуле (1) получим

Случайные величины

Пример №45

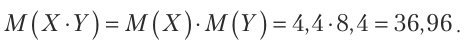

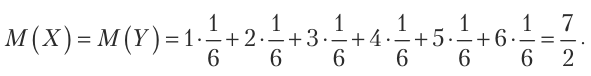

Найти математическое ожидание суммы числа очков, которые могут появиться при бросании двух игральных кубиков.

Решение. Обозначим количество очков, которые могут появиться на первом кубике

Согласно свойства 4 математического ожидания, получим

Следовательно, математическое ожидание суммы числа очков, которые могут появиться при бросании двух игральных кубиков равно 7.

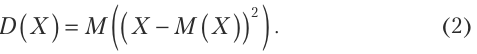

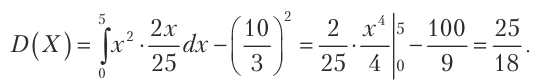

Дисперсия и ее свойства

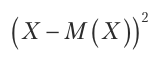

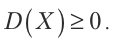

Математическое ожидание характеризует центр распределения дискретной случайной величины. Но этой характеристики недостаточно, так как возможно значительное отклонение возможных значений от центра распределения. Для характеристики рассеивания возможных значений