Г.3.1.1.1

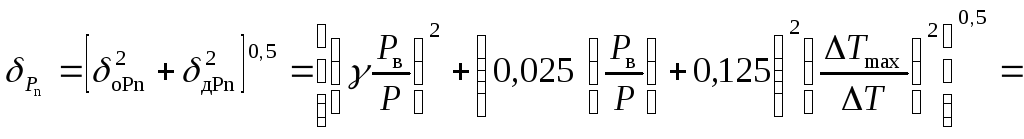

Составляющую относительной погрешности

измерения абсолютного давления

,

обусловленную погрешностью первичного

преобразователя давления (см. формулу

(25)),

рассчитывают по формуле

(Г.9)

где

γ — класс точности первичного преобразователя

абсолютного давления (0,25 %);

Рв

— верхний предел измерений абсолютного

давления (0,63 МПа);

Р

— давление газа (0,10 МПа);

—

наибольшее отклонение температуры

окружающей среды от нормального значения

(tнорм

— tmin

= 20°С + 20°С = 40°С);

ΔT

-диапазон изменения температуры

окружающей среды, для которого нормирован

предел дополнительной погрешности (20

°С).

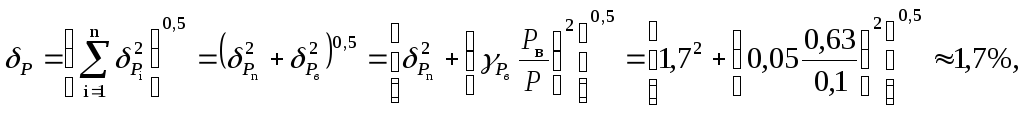

Г.3.1.1.2

Относительную погрешность измерения

абсолютного давления δР

с помощью комплекта, состоящего из

первичного преобразователя давления

и измерительного канала давления

вычислителя, рассчитывают по формуле

(26):

где

— относительная погрешность вычислителя

по каналу измерения давления.

Г.3.1.2

Расчет относительной погрешности

измерения температуры

Г.3.1.2.1

Составляющую относительной погрешности

измерения температуры

,

обусловленную погрешностью преобразователя

температуры, рассчитывают по формуле

(20)

(Г.11)

где

Δt

— абсолютная погрешность преобразователя

температуры;

T

—

температура газа (273,15 — 10 = 263,15) К.

Г.3.1.2.2

Определение относительной погрешности

измерения температуры δT

с

помощью комплекта, состоящего из

первичного преобразователя температуры

и измерительного канала температуры

вычислителя, рассчитывают по формуле

(26):

(Г.12)

где

— относительная погрешность вычислителя

по каналу измерения температуры.

Г.3.1.3

Расчет коэффициентов влияния.

По

формулам (43)-(55)

TгР

= 171,6; TгР

= 187,3;

= 123,0.

Так

как температура газа больше этих значений

в соответствии с 12.3.8

настоящих Правил, то коэффициенты

влияния давления и температуры на

величину расхода примем равными единице,

а коэффициент влияния плотности при

стандартных условиях примем равным

нулю.

Г.3.1.4

Относительная погрешность определения

коэффициента сжимаемости

Г.3.1.4.1

В соответствии с ГОСТ

30319.2,

таблица 1, относительная погрешность

расчета коэффициента сжимаемости δ

составляет 0,11 %.

Погрешность

δи.д

в соответствии с формулами (42),(49)

примем равной нулю.

Тогда погрешность

определения коэффициента сжимаемости

в соответствии с формулой (40)

будет равна 0,11%.

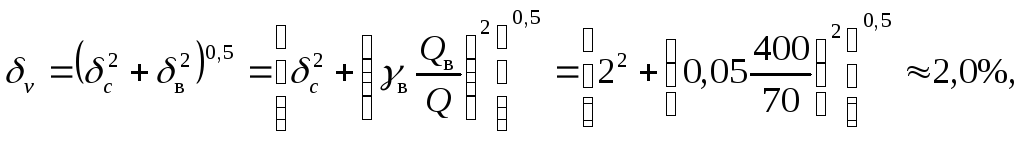

Г.3.1.5

Относительная погрешность измерения

объема газа δv

при рабочих условиях составляет

(Г.13)

где

δc

— относительная погрешность счетчика

при расходе 70 м3/ч;

γв

— приведенная погрешность вычислителя

по каналу измерения объемного расхода

газа.

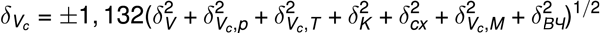

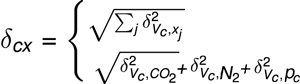

Г.3.1.6

Относительную погрешность определения

объема газа

,

приведенного к стандартным условиям

приTmin,

Pmin,

рассчитывают по формуле (36):

(Г.14)

Г.3.2

Расчет наибольшей относительной

погрешности определения энергосодержания

Наибольшую

погрешность определения энергосодержания

δЕ

газа рассчитывают по значениям наибольших

погрешностей вычислений объема газа,

приведенного к стандартным условиям,

и удельной объемной теплоты сгорания.

Относительную погрешность определения

энергосодержания газа вычисляют по

формуле (37):

(Г.15)

где

— по Г.2.2.1.

Ключевые

слова:

объем газа; энергосодержание; измерение;

счетчики ротационные, турбинные, вихревые

Соседние файлы в предмете [НЕСОРТИРОВАННОЕ]

- #

- #

- #

- #

- #

- #

- #

- #

- #

- #

- #

Это значит, что допустимая погрешность манометра 1.5% от шкалы измерения, т.е.0.15 кгс/см2. Если погрешность прибора при проверке больше — то прибор необходимо менять.

Как определить погрешность у манометра?

Определение погрешности — Владельцев измерительных приборов интересует, прежде всего, величина максимальной погрешности, характерной для манометра. Она зависит не только от класса точности, но и от диапазона измерений. Таким образом, чтобы получить значение погрешности, нужно произвести некоторые вычисления. Необходимо отметить, что таким способом можно посчитать только основную погрешность. Ее величина определяется идеальными условиями эксплуатации. На нее оказывают влияние только конструктивные характеристики, а также особенности сборки прибора, например, точность градуировки делений на шкале, сила трения в измерительном механизме.

Однако эта величина может отличаться от фактической, поскольку существует также дополнительная погрешность, определяемая условиями, в которых эксплуатируется манометр. На нее может влиять вибрация трубопровода или оборудования, температура, уровень влажности и другие параметры. Также точность измерения давления зависит от еще одной характеристики манометра — величины его вариации, которую определяют в ходе поверки.

Это максимальная разница показаний измерителя, выявленная по результатам нескольких измерений. Величина вариации в значительной мере зависит от конструкции манометра, а именно от способа уравновешивания, которое может быть жидкостным (давлением столба жидкости) или механическим (пружиной).

Какой класс точности должен иметь манометр?

Манометры должны иметь класс точности не ниже: 2,5 — при рабочем давлении сосуда до 2,5 МПа (25 кгс/см2), 1,5 — при рабочем давлении сосуда свыше 2,5 МПа (25 кгс/см2).5.3.3. Манометр должен выбираться с такой шкалой, чтобы предел измерения рабочего давления находился во второй трети шкалы.

В чем измеряется класс точности манометра?

Класс точности определяется по вычислению ОДПП прибора. Основная допустимая приведенная погрешность прибора измеряется в процентном соотношении от предельно допустимой абсолютной погрешности к номинальной величине. Чем выше процент – тем менее точен прибор, и наоборот.

Что означает класс точности 1?

Так, для вольтметра, работающего в диапазоне измерений 0 — 30 В, класс точности 1,0 определяет, что указанная погрешность при положении стрелки в любом месте шкалы не превышает 0,3 В.

Что означает класс точности 1 5?

Класс точности – это основная метрологическая характеристика прибора, определяющая допустимые значения основных и дополнительных погрешностей, влияющих на точность измерения. Погрешность может нормироваться, в частности, по отношению к:

результату измерения (по относительной погрешности), в этом случае, по ГОСТ 8.401-80 (взамен ГОСТ 13600-68), цифровое обозначение класса точности (в процентах) заключается в кружок. длине (верхнему пределу) шкалы прибора (по приведенной погрешности)

Для стрелочных приборов принято указывать класс точности, записываемый в виде числа, например, 1,5 или 2,5. Это число даёт максимально возможную погрешность прибора, выраженную в процентах от наибольшего значения величины, измеряемой в данном диапазоне работы прибора.

Например, для манометра ДМ 93-100-1-М, работающего в диапазоне измерений 0-10 кгс/см 2, класс точности 1,0 определяет, что указанная погрешность при положении стрелки в любом месте шкалы не превышает 0,1 кгс/см 2, Относительная погрешность результата зависит от значения измеряемого давления, становясь недопустимо высокой для малых давлений.

Конкретно в данном случае это означает, что таким манометром не следует пытаться измерить давление, меняющееся в диапазоне 0,01.0,2 кгс/см 2, точного результата не получить. Обычно цена наименьшего деления шкалы стрелочного прибора согласована с погрешностью самого прибора.

- Если класс точности используемого прибора неизвестен, за погрешность прибора всегда принимают половину цены его наименьшего деления.

- Понятно, что при считывании показаний со шкалы нецелесообразно стараться определить доли деления, так как результат измерения от этого не станет точнее.

- У манометров, которые мы предлагаем, на цифеблатах нанесена круговая шкала в соответствии с ГОСТ 2405-88.

Пределы допускаемой приведённой основной погрешности выражены в процентах от дипапзона измерений: ±0,15%; ±0,25%; ±0,4%; ±0,6%; ±1%; ±1,5%; ±2,5%; ±4%. Класс точности выбирается из ряда 0,15; 0,25; 0,4; 0,6; 1; 1,5; 2,5; 4, в соответствии с пределами допускаемой приведённой основной погрешности.

- Класс точности у обычных технических показывающих манометров с диаметром шкалы 40; 50 мм, как правило, 2,5 или 4.

- У манометров с диаметром шкалы 60 (63) мм 1,5; 2,5 или 4.

- У манометров со шкалами 100 и 150 (160) мм класс точности 1,5 или, под заказ, 1.

- Классы точности 0,4; 0,6 характерны для манометров точных измерений, а 0,15; 0,25 – для манометров образцовых.

Исходя из вышеизложенного, можно ответить на вопрос «какой класс точности выше, 1 или 1,5?», что выше класс точности 1.

Что измеряется манометром?

У этого термина существуют и другие значения, см. Манометр, Мано́метр ( др.-греч. μανός «неплотный» и μετρέω «измеряю» ) — прибор, измеряющий давление жидкости или газа в замкнутом пространстве,

Сколько годен манометр?

Раз в год или раз в пять лет? — Периодичность поверки манометров указана в их техническом паспорте. Она зависит от конструкции и от модели прибора. Обычно сроки поверки манометров составляют 1 раз в год для старых моделей и 1 раз в 2-5 лет — для моделей, разработанных после 2000 года.

Как считать на манометре?

Как правильно измерять давление манометром — Мерить давление очень просто, если понимать общий принцип действия, характерный для всех механических манометров. Прибор имеет уравновешивающий элемент (пружину, поршень, мембрану и т.д.), который воспринимает нагрузку от напора рабочей среды и деформируется либо перемещается под ее воздействием.

- Уравновешивающий элемент размещается внутри корпуса прибора и имеет механическую связь со стрелкой.

- Таким образом, перемещение стрелки измерителя зависит от величины действующего давления.

- Эта величина отображается стрелкой на шкале прибора.

- Чтобы получить показания, достаточно просто смотреть на шкалу манометра.

Стрелка на ней указывает на шкале величину давления, которое действует в системе в настоящий момент. При изменении измеряемой величины стрелка одновременно перемещается по шкале на соответствующее значение. Это делает измерение максимально удобным и доступным практически для любого человека.

техническая атмосфера. Величина атмосферного давления, действующего на уровне Мирового океана. Одна атмосфера соответствует 1 кг/см2; величина водяного столба. Соответствует гидростатическому давлению столба воды нормальной плотности высотой 1 мм температурой 4 °C, которое действует на плоское основание. Эта единица часто применяется при осуществлении гидравлических расчетов; бар — техническая величина, которая примерно соответствует 1 атмосфере и 10 м водяного столба. Часто используется в характеристиках насосов, арматурных устройств, котлов, другого оборудования; паскаль. Единица измерения, принятая в системе СИ, равная 1 Н/м2. Величина, равная 0,1 МПа, примерно соответствует 1 атмосфере или 1 бар.

Сколько всего классов точности?

В отечественном машиностроении приняты десять классов точности : 1-й, 2-й, 2a, 3-й, За, 4-й, 5-й, 7-й, 8-й и 9-й.1-й класс является (по точности ) высшим. Наибольшее распространение в машиностроении имеют 2-й, 3-й и 4-й классы. Чем выше принят класс точности, тем выше стоимость изготавливаемой детали.

Чему равен класс точности?

Текущая версия страницы пока не проверялась опытными участниками и может значительно отличаться от версии, проверенной 24 мая 2018 года; проверки требуют 13 правок, Класс точности — обобщённая характеристика средств измерений, определяемая пределами допускаемых основных и дополнительных погрешностей, а также рядом других свойств, влияющих на точность осуществляемых с их помощью измерений.

результату измерения (по относительной погрешности)

в этом случае, по ГОСТ 8.401-80, цифровое обозначение класса точности (в процентах) заключается в кружок.

длине (верхнему пределу) шкалы измерительного прибора (по приведенной погрешности).

Для стрелочных приборов принято указывать класс точности, записываемый в виде числа, например, 0,05 или 4,0. Это число дает максимально возможную погрешность прибора, выраженную в процентах от наибольшего значения величины, измеряемой в данном диапазоне работы прибора.

Так, для вольтметра, работающего в диапазоне измерений 0—30 В, класс точности 1,0 определяет, что указанная погрешность при положении стрелки в любом месте шкалы не превышает 0,3 В. Относительная погрешность результата, полученного с помощью указанного вольтметра, зависит от значения измеряемого напряжения, становясь недопустимо высокой для малых напряжений.

При измерении напряжения 0,5 В погрешность составит 60 %. Как следствие, такой прибор не годится для исследования процессов, в которых напряжение меняется на 0,1—0,5 В. Обычно цена наименьшего деления шкалы стрелочного прибора согласована с погрешностью самого прибора.

- Если класс точности используемого прибора неизвестен, за погрешность s прибора всегда принимают половину цены его наименьшего деления.

- Понятно, что при считывании показаний со шкалы нецелесообразно стараться определить доли деления, так как результат измерения от этого не станет точнее.

- Следует иметь в виду, что понятие класса точности встречается в различных областях техники.

Так, в станкостроении имеется понятие класса точности металлорежущего станка, класса точности электроэрозионных станков (по ГОСТ 20551). Обозначения класса точности могут иметь вид заглавных букв латинского алфавита, римских цифр и арабских цифр с добавлением условных знаков.

- Если класс точности обозначается латинскими буквами, то класс точности определяется пределами абсолютной погрешности.

- Если класс точности обозначается арабскими цифрами без условных знаков, то класс точности определяется пределами приведённой погрешности и в качестве нормирующего значения используется наибольший по модулю из пределов измерений.

Если класс точности обозначается арабскими цифрами с галочкой, то класс точности определяется пределами приведённой погрешности, но в качестве нормирующего значения используется длина шкалы. Если класс точности обозначается римскими цифрами, то класс точности определяется пределами относительной погрешности.

Какой класс точности выше 1 или 2?

Класс точности ИПУ и ОДПУ различаются — Класс точности прибора учёта электроэнергии – это максимальная погрешность, которая может возникнуть при измерении потребления электрической энергии. Класс точности выражается в процентах: при 1.0 он составляет ± 1%, при 2.0 – ± 2%. При этом, как указано в п.142 ПП РФ № 442, если у потребителя до мая 2012 года был установлен ИПУ с классом точности ниже 2.0 (чаще всего, это 2.5), то им можно пользоваться до момента истечения срока его поверки. Затем его необходимо заменить, установив новый прибор учёта, соответствующий требованиям п.138 ПП РФ № 442, Как ввести в эксплуатацию и опломбировать индивидуальный счётчик

Какие есть классы точности?

Класс точности средств измерений

| Обозначение класса точности | Пределы допускаемой основной погрешности | |

|---|---|---|

| 0,5 | Класс точности 0,5 | γ = ±0,5% |

| Класс точности 0,5 | γ = ±0,5% | |

| Класс точности 0,5 | δ = ±0,5% | |

| 0,02/0,01 | Класс точности 0,02/0,01 | δ = ± % |

Как определить погрешность измерения?

Измерение физических величин основано на том, что физика исследует объективные закономерности, которые происходят в природе. Найти значение физической величины — умножить конкретное число на единицу измерения данной величины, которая стандартизирована ( эталоны ).

расположение наблюдателя относительно измерительного прибора: если на линейку смотреть сбоку, погрешность измерений произойдёт по причине неточного определения полученного значения;деформация измерительного прибора: металлические и пластиковые линейки могут изогнуться, сантиметровая лента растягивается со временем;несоответствие шкалы прибора эталонным значениям: при множественном копировании эталонов может произойти ошибка, которая будет множиться;физический износ шкалы измерений, что приводит к невозможности распознавания значений.

Рассмотрим на примере измерения длины бруска линейкой с сантиметровой шкалой. Рис. (1). Линейка и брусок Внимательно рассмотрим шкалу. Расстояние между двумя соседними метками составляет (1) см. Если этой линейкой измерять брусок, который изображён на рисунке, то правый конец бруска будет находиться между (9) и (10) метками.

- У нас есть два варианта определения длины этого бруска. (1).

- Если мы заявим, что длина бруска — (9) сантиметров, то недостаток длины от истинной составит более половины сантиметра ((0,5) см (= 5) мм). (2).

- Если мы заявим, что длина бруска — (10) сантиметров, то избыток длины от истинной составит менее половины сантиметра ((0,5) см (= 5) мм).

Погрешность измерений — это отклонение полученного значения измерения от истинного. Погрешность измерительного прибора равна цене деления прибора. Для первой линейки цена деления составляет (1) сантиметр. Значит, погрешность этой линейки (1) см. Если нам необходимо произвести более точные измерения, то следует поменять линейку на другую, например, с миллиметровыми делениями. Рис. (2). Деревянная линейка Если же необходимы ещё более точные измерения, то нужно найти прибор с меньшей ценой деления, например, штангенциркуль. Существуют штангенциркули с ценой деления (0,1) мм и (0,05) мм, Рис. (3). Штангенциркуль На процесс измерения влияют следующие факторы: масштаб шкалы прибора, который определяет значения делений и расстояние между ними; уровень экспериментальных умений. Считается, что погрешность прибора превосходит по величине погрешность метода вычисления, поэтому за абсолютную погрешность принимают погрешность прибора.

Как определить погрешность?

Измерение физических величин основано на том, что физика исследует объективные закономерности, которые происходят в природе. Найти значение физической величины — умножить конкретное число на единицу измерения данной величины, которая стандартизирована ( эталоны ).

расположение наблюдателя относительно измерительного прибора: если на линейку смотреть сбоку, погрешность измерений произойдёт по причине неточного определения полученного значения;деформация измерительного прибора: металлические и пластиковые линейки могут изогнуться, сантиметровая лента растягивается со временем;несоответствие шкалы прибора эталонным значениям: при множественном копировании эталонов может произойти ошибка, которая будет множиться;физический износ шкалы измерений, что приводит к невозможности распознавания значений.

Рассмотрим на примере измерения длины бруска линейкой с сантиметровой шкалой. Рис. (1). Линейка и брусок Внимательно рассмотрим шкалу. Расстояние между двумя соседними метками составляет (1) см. Если этой линейкой измерять брусок, который изображён на рисунке, то правый конец бруска будет находиться между (9) и (10) метками.

- У нас есть два варианта определения длины этого бруска. (1).

- Если мы заявим, что длина бруска — (9) сантиметров, то недостаток длины от истинной составит более половины сантиметра ((0,5) см (= 5) мм). (2).

- Если мы заявим, что длина бруска — (10) сантиметров, то избыток длины от истинной составит менее половины сантиметра ((0,5) см (= 5) мм).

Погрешность измерений — это отклонение полученного значения измерения от истинного. Погрешность измерительного прибора равна цене деления прибора. Для первой линейки цена деления составляет (1) сантиметр. Значит, погрешность этой линейки (1) см. Если нам необходимо произвести более точные измерения, то следует поменять линейку на другую, например, с миллиметровыми делениями. Рис. (2). Деревянная линейка Если же необходимы ещё более точные измерения, то нужно найти прибор с меньшей ценой деления, например, штангенциркуль. Существуют штангенциркули с ценой деления (0,1) мм и (0,05) мм, Рис. (3). Штангенциркуль На процесс измерения влияют следующие факторы: масштаб шкалы прибора, который определяет значения делений и расстояние между ними; уровень экспериментальных умений. Считается, что погрешность прибора превосходит по величине погрешность метода вычисления, поэтому за абсолютную погрешность принимают погрешность прибора.

Как найти погрешность давления?

С помощью барометра проводились измерения атмосферного давления. Верхняя шкала барометра проградуирована в кПа, а нижняя шкала – в мм рт. ст. (см. рисунок). Погрешность измерений давления равна цене деления шкалы барометра. Чему равны показания барометра с учётом погрешности измерений?

( ) мм рт. ст. ( ) мм рт. ст. ( ) кПа ( ) кПа

В ответ запишите цифру, соответствующую выбранным показаниям.

Что означает 2 3 шкалы манометра?

Если измеряемое давление меньше 1/ 3 шкалы, то резко возрастет погрешность измерения давления. Если измеряемое давление больше 2 / 3 шкалы, тогда механизм прибора будет работать в режиме перегрузки и может выйти из строя раньше гарантийного срока.

Погрешности датчиков давления.

К инструментальным погрешностям манометра относятся:

2. Погрешности, вызываемые трением в механизме;

3. Погрешности от неуравновешенности деталей передаточно-множительного механизма;

4. Температурные погрешности;

5. Погрешности гистерезиса.

Наибольшую величину имеют погрешности от трения и температурные погрешности.

Погрешность, вызываемая трением в механизме, обусловлена наличием сил трения в сопряженных деталях кинематической цепи (в шарнирах, осях, зубчатых парах и т.д.) и трением между щеткой и потенциометром.

Изменение температуры окружающей среды по сравнению с температурой градуировки приводит к следующим погрешностям:

а) изменение модуля упругости материала, из которого изготовлен упругий чувствительный элемент;

б) неодинаковое линейное расширение деталей из различных материалов при изменении температуры;

в) изменение сопротивлений рамок логометра.

Величина погрешности от изменения модуля упругости неодинакова по всей шкале: при нулевой разности давлений, погрешность равна нулю; с увеличением разности давлений погрешность возрастает.

Абсолютное значение температурной погрешности, вызванное изменением модуля упругости

где l — температурный коэффициент модуля упругости;

Dt — изменение температуры окружающей среды.

Неодинаковое линейное расширение деталей при изменении температуры приводит к дополнительному перемещению передаточно-множительного механизма и, соответственно, к смещению стрелки прибора. Возникающая при этом погрешность показания прибора пропорциональна величине изменения температуры и имеет одинаковую величину по всей шкале, т.е. не зависит от измеряемого давления. Для устранения этой погрешности основание и тягу механизма следует изготовлять из одинакового материала.

Кроме того, для устранения контактного трения щеток потенциометра применяют бесконтактные преобразователи — индуктивный датчик перемещения, якорь которого связан с жестким центром мембраны.

Электрический сигнал рассогласования, снимаемый с индуктивного датчика через выпрямительный мост, подается на логометрический указатель аналогично потенциометрическому датчику.

Описание лабораторной установки

Схема установки (рис. 1.6) содержит в своем составе: три исследуемых датчика давления: потенциометрический ДП, два индуктивных ИКД и ИД. Выходные сигналы с датчиков нормируются и посредством переключателя подаются на указатель.

K — кран, Рес — ресивер, Ред — редуктор, М — манометр, ДП— датчик потенциометрический— ПI-Б, ИКД— индуктивный датчик ИКД-27ДФ, ИД -индуктивный датчик ДИ-4, mV— милливольтметр.

Порядок выполнения работы

1. Изучить принцип работы и конструкцию потенциометрического и индуктивного датчиков давления.

2. Создать давление в ресивере.

3. Установить переключатель в соответствующее положение, снять зависимость выходного сигнала каждого датчика от величины входного давления.

4. Измерения произвести для десяти значений входного давления. Данные занести в таблицу 1.

№ пп № пп |

Давление по шкале манометра | Показания mV ДП | Показания mV ИКД | ||

| Uср | Δ | ε | Uср | Δ | ε |

По полученным данным построить графики зависимости

Определить погрешности датчиков давления и сравнить полученные результаты.

Содержание отчета

3. Результаты измерений, сведенные в таблицу;

4. Графики, построенные по результатам измерений;

1.6. Контрольные вопросы

1. Принцип действия потенциометрического датчика давления.

2. Принцип действия индуктивного датчика давления.

3. Погрешности исследуемых датчиков давления и методы их уменьшения.

4. Конструкция датчиков давления.

5. Перечислите погрешности манометров с потенциометрическими датчиками.

6. Перечислите погрешности манометров с индуктивными датчиками.

7. Методы устранения погрешностей манометров различного типа.

1. Боднер В.А. “Приборы первичной информации”. М. Машиностроение, 1981 г.

2. Дорофеев С.С. Авиационные приборы. М.: Воениздат, 1992 г.

3. Панфилов Д.И. Иванов В.С. Датчики фирмы “ Motorola”. М.: Додэка, 2000 г.

4. Уолт Кестер. Учебник фирмы Analog Devices. / Перевод с английского — Горшков Б.Л., Санкт-Петербург: Автекс, 1998 г., электронная версия.

Источник

Расчет погрешности датчика давления

У поверяемого датчика давления со шкалой измерения от 0 до 250 mbar основная относительная погрешность измерения во всем диапазоне измерений равна 5%. Датчик имеет токовый выход 4…20 мА. На датчик калибратором подано давление 125 mbar, при этом его выходной сигнал равен 12,62 мА. Необходимо определить укладываются ли показания датчика в допустимые пределы.

Показать полностью.

Во-первых, необходимо вычислить каким должен быть выходной ток датчика Iвых.т при давлении Рт = 125 mbar.

Iвых.т = Iш.вых.мин + ((Iш.вых.макс – Iш.вых.мин)/(Рш.макс – Рш.мин))*Рт

где Iвых.т – выходной ток датчика при заданном давлении 125 mbar, мА.

Iш.вых.мин – минимальный выходной ток датчика, мА. Для датчика с выходом 4…20 мА Iш.вых.мин = 4 мА, для датчика с выходом 0…5 или 0…20 мА Iш.вых.мин = 0.

Iш.вых.макс — максимальный выходной ток датчика, мА. Для датчика с выходом 0…20 или 4…20 мА Iш.вых.макс = 20 мА, для датчика с выходом 0…5 мА Iш.вых.макс = 5 мА.

Рш.макс – максимум шкалы датчика давления, mbar. Рш.макс = 250 mbar.

Рш.мин – минимум шкалы датчика давления, mbar. Рш.мин = 0 mbar.

Рт – поданное с калибратора на датчик давление, mbar. Рт = 125 mbar.

Подставив известные значения получим:

Iвых.т = 4 + ((20-4)/(250-0))*125 = 12 мА

То есть при поданном на датчик давлении равном 125 mbar на его токовом выходе должно быть 12 мА. Считаем, в каких пределах может изменяться расчетное значение выходного тока, учитывая, что основная относительная погрешность измерения равна ± 5%.

ΔIвых.т =12 ± (12*5%)/100% = (12 ± 0,6) мА

То есть при поданном на датчик давлении равном 125 mbar на его токовом выходе выходной сигнал должен быть в пределах от 11,40 до 12,60 мА. По условию задачи мы имеем выходной сигнал 12,62 мА, значит наш датчик не уложился в определенную производителем погрешность измерения и требует настройки.

Основная относительная погрешность измерения нашего датчика равна:

Источник

Давление: измеряемые типы, погрешность. Справочная информация.

Это устройство, преобразующее давление среды — то есть силу, с которой эта среда давит на мембрану датчика — в электрический выходной сигнал, который по соединительным проводам поступает на управляющий прибор ( ПЛК , регулятор типа ТРМ и т.п.). Обычно выходной сигнал таких преобразователей аналоговый непрерывный. Чаще всего это 4. 20 миллиАмпер (“токовая петля”) или 0. 10 Вольт (“3-х проводный”). Также рынок потихоньку начинают завоевывать преобразователи с цифровыми интерфейсами — например, с RS-485. Небольшой анонс: скоро у ОВЕН появится датчик давления ПД100И с таким интерфейсом “на борту”.

- Избыточное давление ДИ – это дополнительно созданное относительно атмосферного давление («наддув», «напор») в измеряемом процессе. Это самый распространенный вид давления — оно присутствует и в батареях отопления, и в кофемашинах, и в паровых котлах на ТЭЦ. И везде его требуется измерять 🙂

- Давление вакуумметрическое ДВ – это созданное относительно атмосферного давления разрежение («тяга») в измеряемом процессе. Например, в дымоходах котельных и коробах вентиляционных систем торговых центров.

- Давление избыточно-вакуумметрическое ДИВ – это когда давление в процессе может быть то ниже атмосферного, то выше (т.н. “тягонапорометрия”). Такое давление измеряется, например, непосредственно в котлах котельных.

- Дифференциальное давление ДД — разница между давлением в любых двух точках измеряемого процесса. Этот тип измерений не зависит и не привязан к атмосферному давлению. Часто в промышленности с помощью такого давления измеряют расход жидкости или ее уровень в ёмкостях с избыточным давлением.

- Абсолютное давление ДА — созданное относительно абсолютного (космического) вакуума давление («наддув») в измеряемом процессе. Абсолютное давление измеряется в “особых” случаях, когда требуется исключить влияние атмосферы на измерения — узлы учёта газа на границах государств, стенды испытания двигателей самолётов и т.п.

Конечно, у всех датчиков давления есть погрешность. То есть они измеряют давление с ошибкой, указанной производителем. Будьте внимательны: серьезные производители всегда указывают суммарную погрешность измерения своих датчиков. Если такой информации в паспорте изделия или на его бирке не найти, возможно, это подделка или датчик низкого качества с непредсказуемыми показаниями. Не дайте себя обмануть!

Рассмотрим виды погрешностей и факторы, влияющие на погрешность.

От измерительного преобразователя ( датчика ) давления в идеале необходимо получить линейную функцию преобразования давления в ток (наклонная пунктирная линия на рисунке).

Но сенсоры давления даже лучших производителей имеют весьма далёкий от идеала выходной сигнал (сплошные линии на рисунке). Существуют три основные составляющие погрешности:

1. Нелинейность – максимальное по модулю отклонение сигнала реального сенсора от идеальной линейной.

2. Повторяемость (воспроизводимость, вариация) – разный выходной сигнал сенсора при повторяющемся одинаковом входном воздействии. Повторяемость максимальна в точке ВПИ (верхнего предела измерения).

3. Гистерезис — разный выходной сигнал при прямом и обратном направлении изменения входного воздействия (давления среды на мембрану датчика).

Обычно повторяемость и гистерезис трудно компенсировать — это свойства качества сенсора, а нелинейность практически полностью убирается нормированием-калибровкой.

Теперь сложим эти три источника – три составные части погрешности – получится суммарная абсолютная погрешность . Но такая величина неудобна в использовании, поскольку для сравнения погрешностей разных датчиков придётся сравнивать различающиеся в сотни раз диапазоны и пересчитывать физические величины давлений МПа –кгс/см2 – атм – psi — м.в.с — …, в которых эта погрешность будет выражаться.

Поэтому принято эту суммарную абсолютную погрешность делить на величину верхнего предела измерения (ВПИ, диапазона) и умножать на 100% — получается суммарная относительная погрешность . Которой производители и «меряются», у кого преобразователи давления лучше: чем точнее преобразование (меньше погрешность преобразования), тем датчик считается лучше и продается дороже. Объединение ОВЕН прямо указывает суммарную основную погрешность в кодировке датчиков.

В данный момент на рынке в основном присутствуют датчики с основной погрешностью от 1,0% до 0,1% ВПИ.

Основная погрешность всеми производителями гарантируется только при так называемых нормальных условиях работы преобразователя давления: температура +23 (+/-5) °C, влажность 60%, атмосферное давление 760 мм.рт.ст, отсутствие вибраций и электромагнитных полей кроме гравитационного.

При любых изменениях условий всегда возникают дополнительные погрешности (самая заметная из которых — температурная), увеличивающие погрешность показаний преобразователя давления иногда в несколько раз. Отсутствие в заявляемых характеристиках дополнительных погрешностей должно настораживать покупателя.

ПО «ОВЕН» гарантирует, что дополнительная температурная погрешность у преобразователей давления ПД100 и ПД150 не превышает 0,2% на 10 °C , а у ПД200 не более 0,1% на 10 °C . Это обеспечивается дополнительным циклом калибровки преобразователей при +80 °C при их производстве, в процессе которого обеспечивается микропроцессорная термокомпенсация дополнительных погрешностей.

Чем преобразование в датчике «независимее» от внешних причин (температуры, времени работы, электромагнитных помех и т.п.) – тем датчик стабильнее и дороже. Сейчас на рынке присутствуют датчики с межповерочным интервалом и/или гарантией от 1 до 5 лет, что означает: в течение этого времени датчик останется в заявленных в документах границах погрешности.

Источник

Класс точности манометра: что это такое, как рассчитать, как проверить

Манометры – измерительные приборы для определения давления газа, пара, жидкости в закрытых пространствах. Общее название распространяется на несколько типов устройств – барометры, вакуумметры, манометры избыточного или абсолютного давления. Кроме того, даже в одной линейке приборы отличаются по разным параметрам, в том числе, по классу точности измерений.

Отраженная в процентном соотношении наиболее допустимая относительная погрешность в диапазоне измерений называется классом точности манометра. Информация о шести применяемых классах прописана в ГОСТ 2405-88: 0,4, 0,6, 1, 1,5, 2,5, 4.

Показатель напрямую зависит от диаметра шкалы прибора: чем он больше, тем меньше погрешность. То есть, манометр диаметром 250 мм показывает более точные данные, чем 40-миллиметровый.

Меньшую погрешность устройства обозначают меньшие числовые обозначения класса точности.

Выбор прибора по классу точности зависит от проектного решения относительно применяемых средств измерения, которое, в свою очередь, определяется технологическим процессом и стоимостью устройства. С возрастанием точности датчика растёт и его цена, становятся выше требования к обслуживанию, затраты на поверку и ремонт.

Класс точности манометра должен быть не ниже 2,5, если рабочее давление достигает 2,5 Мпа, 1,5 при давлении, превышающем 2,5 Мпа. Кроме того, следует учитывать размеры корпуса, исполнение прибора и способ крепления соответствующие месту установки.

Определение класса точности манометра

Обычно класс точности манометра указывается на шкале прибора. Перед цифрами размещаются буквы KL или CL. Увидев их, можно точно определить параметры.

Определение размера погрешности

На значение погрешности влияют два параметра:

Это нагляднее можно понять из примера: класс точности прибора составляет 2,5 при диапазоне измерений в пределах 6 МПа. Погрешность прибора вычисляем по формуле пропорций: 6*2,5/100=0,15 МПа.

Обозначение на приборе 2,5 означает, что данный прибор при измерении давления может дать погрешность в пределах 2,5% от истинного диапазона. Вычисляются эти данные опытным путём. Замеры давления делаются двумя приборами – образцом и испытуемым манометром.

Далее фиксируется разница между показателями. Такая процедура проводится несколько раз для нахождения максимального значения отклонения. Например, диапазон испытуемого барометра 300 бар, а максимальное выявленное отклонение от образца – 3 бар.

Процент отклонения высчитывается следующим образом: 3*100/300=1. В итоге определился класс точности прибора – единица.

Как определяют качество штукатурки

На некоторых зарубежных приборах встречается класс 1.6.

Как исходя из класса точности самому рассчитать погрешность манометра, который будет установлен на объекте? Допустим у Вас манометр на 10 кгс/см2 классом точности 1.5. Это значит, что допустимая погрешность манометра 1.5% от шкалы измерения, т. е. 0.15 кгс/см2.

Если погрешность прибора при проверке больше — то прибор необходимо менять. Понять без специального оборудования исправный прибор или нет по нашему опыту нереально.

Принять решение о несоответствии класса точности может только организация, у которой есть поверочная установка с эталонным манометром с классом точности в четыре раза меньше, чем класс точности проблемного манометра.

Два прибора устанавливаются на линию с давлением и сравниваются два показания.

А бывает так, что куплен новый прибор, проверяется в лаборатории и признается абсолютно нормальным, а на объекте по Вашему мнениею показывает ерунду? Да, такое бывает и мы расскажем наиболее распространенный случай. Куплен прибор на 10 кгс/см2 и ставится на газопровод, где обычное давление 1.5 кгс/см2.

Прибор показывает какую-то ерунду или стрелка дергается около нуля. Это прибор срочно несется на проверку, а в Центре стандартизации и метрологии вердикт очень простой – прибор исправен и соответствует заявленному классу точности. А в чем подвох? Все очень просто.

При покупке прибора необходимо учитывать, что рабочее давление должно быть от 1/3 до 2/3 шкалы измерения и если давление в трубе меньше 1/3, то манометр начинает врать, причем чем больше давление отходит от этой трети, тем загадочней и абсурдней показания.

При проверке манометра погрешность давления сравнивается с манометром с такой же шкалой и более высоким классом точности. Будьте внимательны при выборе шкалы давления манометра и это позволит Вам избежать ненужной никому нервотрепки.

Интерьер комнаты своими руками недорого

Манометр — измерительный прибор, который позволяет установить значение избыточного давления, действующего в трубопроводе или в рабочих частях различных видов оборудования.

Такие приборы широко применяются в системах отопления, водоснабжения, газоснабжения, других инженерных сетях коммунального и промышленного назначения.

В зависимости от условий эксплуатации измерителя существуют определенные ограничения по допустимому пределу его погрешности. Поэтому важно знать, как определить класс точности манометра.

Что такое класс точности манометра, и как его определить

Класс точности манометра является одной из основных величин, характеризующих прибор. Это процентное выражение максимально допустимая погрешность измерителя, приведенная к его диапазону измерений.

Абсолютная погрешность представляет собой величину, которая характеризует отклонение показаний измерительного прибора от действительного значения давления. Также выделяют основную допустимую погрешность, которая представляет собой процентное выражение абсолютного допустимого значения отклонения от номинального значения.

Именно с этой величиной связан класс точности.

Существует два типа измерителей давления — рабочие и образцовые. Рабочие применяются для практического измерения давления в трубопроводах и оборудовании. Образцовые — специальные измерители, которые служат для поверки показаний рабочих приборов и позволяют оценить степень их отклонения. Соответственно, образцовые манометры имеют минимальный класс точности.

Классы точности современных манометров регламентируются в соответствии с ГОСТ 2405-88 Они могут принимать следующие значения:

Таким образом, этот показатель имеет прямую зависимость с погрешностью. Чем он ниже, тем ниже максимальное отклонение, которое может давать измеритель давления, и наоборот.

Соответственно, от этого параметра зависит, насколько точными являются показания измерителя. Высокое значение указывает на меньшую точность измерений, а низкое соответствует повышенной точности.

Чем ниже значение класса точности, тем более высокой является цена устройства.

Узнать этот параметр достаточно просто. Он указан на шкале в виде числового значения, перед которым размещаются литеры KL или CL. Значение указывается ниже последнего деления шкалы.

Знак начинающий водитель фото

Указанная на приборе величина является номинальной. Чтобы определить фактический класс точности, нужно выполнить поверку и рассчитать его.

Для этого проводят несколько измерений давления образцовым и рабочим манометром. После этого необходимо сравнить показания обоих измерителей, выявить максимальное фактическое отклонение.

Затем остается только посчитать процент отклонения от диапазона измерений прибора.

Определение погрешности

Необходимо отметить, что таким способом можно посчитать только основную погрешность. Ее величина определяется идеальными условиями эксплуатации. На нее оказывают влияние только конструктивные характеристики, а также особенности сборки прибора, например, точность градуировки делений на шкале, сила трения в измерительном механизме. Однако эта величина может отличаться от фактической, поскольку существует также дополнительная погрешность, определяемая условиями, в которых эксплуатируется манометр. На нее может влиять вибрация трубопровода или оборудования, температура, уровень влажности и другие параметры.

Также точность измерения давления зависит от еще одной характеристики манометра — величины его вариации, которую определяют в ходе поверки. Это максимальная разница показаний измерителя, выявленная по результатам нескольких измерений.

Величина вариации в значительной мере зависит от конструкции манометра, а именно от способа уравновешивания, которое может быть жидкостным (давлением столба жидкости) или механическим (пружиной).

Механические манометры имеют более выраженную вариацию, что часто обусловлено дополнительным трением при плохой смазке или износе деталей, потере упругости пружины и другими факторами.

Разбираемся в классах точности манометров

Класс точности манометра – это отраженная в процентах, наибольшая допускаемая относительная погрешность, приведенная к его диапазону измерений.

Существует всего шесть применяемых классов, эта информация расписана в ГОСТ 2405-88:

Этот параметр тесно связан с диаметром шкалы прибора. Соответственно, чем больше диаметр, тем меньше погрешность, и меньше класс точности манометра.

Как видно из таблицы манометр с диаметром 250 имеет самую высокую точность, а прибор с диаметром 40 самую низкую.

Чем меньше погрешность устройства, тем меньше класс точности в числовом выражении. Диапазон класса точности манометра 0,4 — 4.

Как узнать?

Класс точности манометра обычно пишется на шкале прибора, перед числовым значением располагаются буквенные обозначения KL или CL.

Как определить размер погрешности?

Само значение погрешности находится в прямой зависимости от 2 параметров:

- Диапазон измерения

- Класс точности

Допустим класс точности равен 2,5, диапазон измерения равен 6 МПа. Из этих значений получаем что погрешность прибора равна 6*2,5/100=0,15 МПа. Значение в 2.5 означает что погрешность измерений данного прибора составляет 2,5 процента от его диапазона измерений.

Как вычисляется?

Расчет производится следующим образом:

- Берется два прибора: образцовый и испытуемый манометр.

- Производятся замеры давления образцовым, а затем и испытуемым манометром.

- Далее смотрят на отклонение испытуемого прибора от образцового.

- Проводят эту процедуру несколько раз и находят максимальное значение отклонения.

- В зависимости от отклонения присваивают ему определенный класс точности.

Допустим 300 бар у нас диапазон испытуемого барометра и выявилось максимальное отклонение в 3 бар от образцового барометра. Вычисляем процент отклонения: 3*100/300=1. Итог класс точности в данном примере равен 1.

Разбираемся в классах точности манометров Ссылка на основную публикацию

Как определить погрешность манометра

Манометры выпускаются следующих классов точности: 0,6; 1; 1,5; 2,5; 4 (цифры расположены в порядке уменьшения значения класса точности приборов).

Класс точности – это максимально допустимая относительная погрешность прибора, приведенная к диапазону его шкалы, выраженная в процентах. Чем ниже значение класса точности тем меньше погрешность манометра.

Согласно ГОСТ 2405-88 класс точности приборов должен выбираться из ряда: 0,4; 0,6; 1,0; 1,5; 2,5; 4,0. В случае с дифференцированным значением основной погрешности устанавливают следующие условные обозначения классов точности: 0,6-0,4-0,6; 1-0,6-1; 1,5-1-1,5; 2,5-1,5-2,5; 4-2,5-4.

Обозначение класса точности

Предел допускаемой основной погрешности, % диапазона показаний, в диапазоне шкалы

Среди приборов, применяемых для измерения давления, наиболее широкое распространение получили пружинные приборы – манометры, вакуумметры, мановакуумметры.

Основным элементом таких приборов является трубчатая пружина, которая деформируется под действием подведенного давления, причем деформация пропорциональна величине давления.

Упругие свойства пружин не остаются постоянными с течением времени, поэтому такие приборы в обязательном порядке следует подвергать периодически поверке.

Большинство приборов, используемых для измерения давления и разрежения, подлежат обязательной государственной поверке.

Если в результате поверки прибор признан годным, он снабжается клеймом установленного образца или соответствующими свидетельствами, в которых указываются константы приборов или поправки к их показаниям.

Однако, несмотря на государственный контроль за состоянием приборов, на предприятиях должен осуществляться ведомственный контроль, причем сроки поверки зависят от условий эксплуатации приборов.

- В эксплуатационных и лабораторных условиях поверка приборов для измерения давления сводится к следующему:

- 1. Поверка нулевой точки;

- 2. Поверка прибора в рабочей точке;

Первые два способа не являются собственно поверкой; они относятся к контролю за состоянием прибора только по одному признаку.

Поверка нулевой точки заключается в наблюдении за положением стрелки прибора, отключенного от установки. Если в отключенном приборе при сообщении его с атмосферой стрелка устанавливается на нулевом штрихе, считается, что прибор не имеет повреждений.

Чтобы произвести поверку прибора в рабочей точке, к работающей установке подключают контрольный прибор, точность показаний которого известна. Оба прибора сообщаются с одним и тем же давлением, определяется разность их показаний.

Полная поверка прибора проводится в лабораторных условиях со снятием прибора с рабочей установки. Такая поверка дает полную информацию о состоянии прибора, и сомнений в исправности прибора, прошедшего такую поверку, быть не может.

Поверка технического манометра производится с целью определения его пригодности для дальнейшей эксплуатации.

Читать также: Перфоратор для домашнего использования рейтинг

Описание установки и приборов

Поверка рабочего манометра производится на установке, изображенной на рис. 5.1. Избыточное давление создается специальным прессом, с помощью которого можно произвольно создавать давление в весьма широких пределах.

Пресс представляет собой цилиндр 7, внутри которого перемещается поршень 9, приводимый в движение маховиком 11. Полость давления сообщается с резьбовыми отверстиями, предназначенными для установки поверяемого 4 и образцового 1 манометров.

Отверстия для установки манометром могут быть перекрыты вентилями 5 и 6, что необходимо для установки и смены манометров.

Для заполнения пресса обычно используют трансформаторное или вазелиновое масло, которое поступает в цилиндр пресса и в манометры из емкости 3 при открытом вентиле 2.

Заполнение внутренних полостей маслом производится при открытом вентиле 2 и крайнем правом положении поршня.

Затем вентиль 2 закрывается, а поршень вращением маховичка перемещается влево, масло в цилиндре сжимается, за счет чего и создается избыточное давление.

Рис. 5.1. Установка для поверки пружинных манометров по образцовому пружинному манометру

Для целей поверки и градуировки различных пружинных манометров, вакуумметров и мановакуумметров широко применяют образцовые пружинные приборы. Иногда образцовые приборы используют и для выполнения непосредственных измерений давления и разрежения. Образцовые приборы изготавливаются только в виде манометров и вакуумметров, образцовых мановакуумметров не выпускают.

Образцовые манометры изготавливаются с трубчатой пружиной, секторным передаточным механизмом и конструктивно они мало отличаются от обыкновенных технических рабочих манометров.

Отличие заключается в том, что в образцовых манометрах за счёт более качественной отделки, тщательной подготовки передаточного механизма высокого качества трубчатых пружин, достигается большая точность измерений.

Кроме того, в образцовых приборах применяются особые шкалы и иного вида стрелки.

По устройству шкал образцовые приборы делятся на две группы: приборы с именованными шкалами и приборы с условными делениями.

Именованные шкалы непосредственно указывают величину давления или разрежения в принятых единицах, например в кгс/см 2 , в мм.рт.ст. и т.д. В другом случае шкала прибора градуируется в условных единицах.

Именованные шкалы размечаются индивидуально с помощью поршневых и ртутных манометров. Именованные шкалы делаются или в виде обыкновенных штриховых, или же точечных.

Стрелки манометров с штриховыми шкалами имеют указательный конец, поставленный на ребро в виде лезвия, что сильно облегчает производство точных отсчетов.

В случае поверки рабочих манометров стрелка образцового всегда устанавливается на точке шкалы, а при измерении неизвестного давления она может стать в любое положение, и тогда давление приходится определять отсчетом «на глаз». Вследствие значительных расстояний между двумя соседними точками (обычно 8-10 мм) отсчет будет сделан грубо, и высокая точность измерения снижена.

Читать также: Как подключить две видеокамеры к ноутбуку

Что касается штриховых именованных шкал, то у них нет этих неудобств, т.к. расстояние между штрихами делается небольшими, а имея в виду специальный указатель стрелки, точный отсчет легко осуществим.

Манометры со шкалой в условных единицах регулируются таким образом, что при отсутствии давления стрелка манометра устанавливается на нулевом штрихе, а при максимальном для данного прибора на последнем делении шкалы. Предельное давление, на которое манометр рассчитан, указывается на циферблате манометра.

Однако из этого соотношения не следует делать вывод о полной пропорциональности между давлением и показанием шкалы, т.к. такая запись является чисто условной, устанавливающей лишь предельное значение давления. Для пользования такими приборами необходимо их градуировать по поршневым или ртутным приборам.

В результате такой градуировки, производимой в 10-15 точках, получают необходимое соотношение между давлением и показанием шкалы в виде таблицы. Один ряд чисел указывает действительное давление, а второй – число делений, соответствующее этим давлением. Для удобства пользования часто эту таблицу представляют в виде графика, что позволяет избегать пересчетов.

Полную поверку прибора следует рассматривать состоящей из следующих отдельных элементов: внешнего осмотра, определения погрешности, установления величины вариации показаний.

Правильность показаний прибора определяется путем сравнения их с действительным значением давления, которое устанавливается с помощью образцовых приборов. Давление создается с помощью пресса.

Сравнение должно производиться обязательно в пределах всей шкалы поверочного прибора и в числе точек, достаточном для того, чтобы вывести заключение о правильности прибора во всём пределе измерения.

Образцовые и лабораторные приборы, снабжаемые свидетельством, обычно поверяются в 10-15 точках, а технические в 5 и даже 3. Чтобы погрешность образцового прибора не могла существенно повлиять на результаты тарировки, его погрешность должна быть в 3-5 раз меньше допустимой погрешности испытуемого прибора.

Процесс поверки протекает следующим образом. Прибор устанавливают в соответствии с нормальным для него положением и проверяют совпадение стрелки с нулевой отметкой шкалы при отсутствии в приборе избыточного давления.

Если прибор снабжен регулятором, то производят регулировку до полного совпадения указателя с нулевым штрихом. Естественно, что это требование не относится к приборам с безнулевой шкалой.

Затем образцовый и поверяемый приборы соединяют с прессом, в котором создается избыточное давление.

Величину давления устанавливают по образцовому прибору и производят отсчёт по поверяемому или же доводят показание поверяемого прибора до полного совпадения указателя стрелки с поверяемым давлением шкалы, а отсчёт производят по образцовому прибору.

После поверки первой точки давление вновь повышают и последовательно поверяют вое намеченные точки шкалы до верхнего предела (нагрузка). Затем поверяют те же точки при пониженном давлении (разгрузка), причем перед тем как снизить давление прибор выдерживается некоторое время (не менее 5 минут) при максимальном давлении.

Читать также: Зажало диск в болгарке как открутить видео

Чтобы оценить упругое последействие пружинных приборов, от которого в значительной степени зависит качество прибора и его точность, прибегают к многократной поверке. По результатам нескольких поверок делают выводы о свойствах прибора и его точности. В ответственных случаях величина упругого последствия (вариации показаний) особо нормируется.

- Требования по технике безопасности

- Манометры с верхним пределом измерения свыше 6 МПа (60 кгс/см 2 ) следует монтировать так, чтобы они были обращены тыльной стороной к глухой стене; подходить к манометру с тыльной стороны во время работы запрещается.

- При монтаже манометров необходимо следить, чтобы давление в системе было равно атмосферному.

Чем ниже значение класса точности, тем меньше погрешность измерительного прибора.

Какие существуют классы точности

Согласно ГОСТ 2405-88 класс точности манометра должен выбираться из ряда чисел:

Как связаны диаметр и класс точности манометра?

Диаметр и класс точности манометра параметры взаимосвязанные, чем выше точность прибора для измерения давления, тем больше диаметр его шкалы.

Какая погрешность у манометра с классом точности 1,5

Погрешность измерения манометра, зависит не только от его класса точности, но и от диапазона измерений.

Рассмотрим пример, диапазон измерения манометра составляет 10 МПа, класс точности прибора 1,5. Это означает, что максимальная погрешность манометра не должна превышать 10*1,5/100=0,15 МПа.

Манометр класса точности 2,5

Обозначение 2,5 означает, что максимально допустимая погрешность измерений манометра составляет 2,5% от его диапазона измерений.

Как узнать класс точности манометра

Класс точности указывается на шкале прибора, перед числовым значением могут располагаться буквы KL или CL.

Вычисление класса точности прибора

Предположим, что на шкале указан класс точности 1,0, а диапазон измерения прибора 250 Bar. При сравнении результатов измерения давления с показаниями образцового манометра выяснилось, что погрешность составляет 2 Bar. Соответствует ли манометр указанному классу точности?

- Для того, чтобы ответить на этот вопрос произведем вычисление класса точности, для этого соотнесем погрешность измерений с диапазоном измерения прибора и выразим результат в процентах.

- Полученный результат не превышает 1, это означает, что манометр соответствует указанному классу точности 1,0.

- Заказать манометр и узнать более подробно о его классе точности Вы можете у специалистов компании Гидро-Максимум.

Как определить класс точности манометра

Манометр — измерительный прибор, который позволяет установить значение избыточного давления, действующего в трубопроводе или в рабочих частях различных видов оборудования.

Такие приборы широко применяются в системах отопления, водоснабжения, газоснабжения, других инженерных сетях коммунального и промышленного назначения.

В зависимости от условий эксплуатации измерителя существуют определенные ограничения по допустимому пределу его погрешности. Поэтому важно знать, как определить класс точности манометра.

Что такое класс точности манометра, и как его определить

Класс точности манометра является одной из основных величин, характеризующих прибор. Это процентное выражение максимально допустимая погрешность измерителя, приведенная к его диапазону измерений.

Абсолютная погрешность представляет собой величину, которая характеризует отклонение показаний измерительного прибора от действительного значения давления. Также выделяют основную допустимую погрешность, которая представляет собой процентное выражение абсолютного допустимого значения отклонения от номинального значения.

Именно с этой величиной связан класс точности.

Существует два типа измерителей давления — рабочие и образцовые. Рабочие применяются для практического измерения давления в трубопроводах и оборудовании. Образцовые — специальные измерители, которые служат для поверки показаний рабочих приборов и позволяют оценить степень их отклонения. Соответственно, образцовые манометры имеют минимальный класс точности.

Классы точности современных манометров регламентируются в соответствии с ГОСТ 2405-88 Они могут принимать следующие значения:

Таким образом, этот показатель имеет прямую зависимость с погрешностью. Чем он ниже, тем ниже максимальное отклонение, которое может давать измеритель давления, и наоборот.

Соответственно, от этого параметра зависит, насколько точными являются показания измерителя. Высокое значение указывает на меньшую точность измерений, а низкое соответствует повышенной точности.

Чем ниже значение класса точности, тем более высокой является цена устройства.

Узнать этот параметр достаточно просто. Он указан на шкале в виде числового значения, перед которым размещаются литеры KL или CL. Значение указывается ниже последнего деления шкалы.

Указанная на приборе величина является номинальной. Чтобы определить фактический класс точности, нужно выполнить поверку и рассчитать его.

Для этого проводят несколько измерений давления образцовым и рабочим манометром. После этого необходимо сравнить показания обоих измерителей, выявить максимальное фактическое отклонение.

Затем остается только посчитать процент отклонения от диапазона измерений прибора.

Определение погрешности

Необходимо отметить, что таким способом можно посчитать только основную погрешность. Ее величина определяется идеальными условиями эксплуатации. На нее оказывают влияние только конструктивные характеристики, а также особенности сборки прибора, например, точность градуировки делений на шкале, сила трения в измерительном механизме. Однако эта величина может отличаться от фактической, поскольку существует также дополнительная погрешность, определяемая условиями, в которых эксплуатируется манометр. На нее может влиять вибрация трубопровода или оборудования, температура, уровень влажности и другие параметры.

Также точность измерения давления зависит от еще одной характеристики манометра — величины его вариации, которую определяют в ходе поверки. Это максимальная разница показаний измерителя, выявленная по результатам нескольких измерений.

Величина вариации в значительной мере зависит от конструкции манометра, а именно от способа уравновешивания, которое может быть жидкостным (давлением столба жидкости) или механическим (пружиной).

Механические манометры имеют более выраженную вариацию, что часто обусловлено дополнительным трением при плохой смазке или износе деталей, потере упругости пружины и другими факторами.

Автомастерская Adrenaline Garage Солонцы

Манометры выпускаются следующих классов точности: 0,6; 1; 1,5; 2,5; 4 (цифры расположены в порядке уменьшения значения класса точности приборов).

Класс точности – это максимально допустимая относительная погрешность прибора, приведенная к диапазону его шкалы, выраженная в процентах. Чем ниже значение класса точности тем меньше погрешность манометра.

Согласно ГОСТ 2405-88 класс точности приборов должен выбираться из ряда: 0,4; 0,6; 1,0; 1,5; 2,5; 4,0. В случае с дифференцированным значением основной погрешности устанавливают следующие условные обозначения классов точности: 0,6-0,4-0,6; 1-0,6-1; 1,5-1-1,5; 2,5-1,5-2,5; 4-2,5-4.

| Обозначение класса точности | Предел допускаемой основной погрешности, % диапазона показаний, в диапазоне шкалы | ||

| от 0 до 25% | от 25 до 75% | св. 75 до 100% | |

| 0,4 | ±0,4 | ±0,4* | ±0,4 |

| 0,6-0,4-0,6 | ±0,6 | ±0,4 | ±0,6 |

| 0,6 | ±0,6 | ±0,6 | ±0,6 |

| 1-0,6-1 | ±1,0 | ±0,6 | ±1,0 |

| 1 | ±1,0 | ±1,0 | ±1,0 |

| 1,5-1-1,5 | ±1,5 | ±1,0 | ±1,5 |

| 1,5 | ±1,5 | ±1,5 | ±1,5 |

| 2,5-1,5-2,5 | ±2,5 | ±1,5 | ±2,5 |

| 2,5 | ±2,5 | ±2,5 | ±2,5 |

| 4-2,5-4 | ±4,0 | ±2,5 | ±4,0 |

| 4 | ±4,0 | ±4,0 | ±4,0 |

Классом точности называют выраженную в процентах максимально допустимую погрешность манометра, приведенную к его диапазону измерений.

Чем ниже значение класса точности, тем меньше погрешность измерительного прибора.

Какие существуют классы точности

Согласно ГОСТ 2405-88 класс точности манометра должен выбираться из ряда чисел:

Как связаны диаметр и класс точности

Диаметр и класс точности манометра параметры взаимосвязанные, чем выше точность прибора для измерения давления, тем больше диаметр его шкалы.

Какая погрешность у манометра с классом точности 1,5

Погрешность измерения манометра, зависит не только от его класса точности, но и от диапазона измерений.

Рассмотрим пример, диапазон измерения манометра составляет 10 МПа, класс точности прибора 1,5. Это означает, что максимальная погрешность манометра не должна превышать 10*1,5/100=0,15 МПа.

Манометр класса точности 2,5

Обозначение 2,5 означает, что максимально допустимая погрешность измерений манометра составляет 2,5% от его диапазона измерений.

Как узнать класс точности манометра

Класс точности указывается на шкале прибора, перед числовым значением могут располагаться буквы KL или CL.

Вычисление класса точности прибора

Предположим, что на шкале указан класс точности 1,0, а диапазон измерения прибора 250 Bar. При сравнении результатов измерения давления с показаниями образцового манометра выяснилось, что погрешность составляет 2 Bar. Соответствует ли манометр указанному классу точности?

Для того, чтобы ответить на этот вопрос произведем вычисление класса точности, для этого соотнесем погрешность измерений с диапазоном измерения прибора и выразим результат в процентах.

Полученный результат не превышает 1, это означает, что манометр соответствует указанному классу точности 1,0.

Как проверить манометр на точность в домашних условиях

Манометр представлен прибором, который осуществляет измерение давления в аппарате или емкости, на определенном участке трубопровода. Периодическая проверка позволяет избежать основных проблем. Стоит учитывать, что поверка манометров должна проводится исключительно с учетом разновидности устройства:

Для того чтобы калибровка манометров была проведена с высокой эффективностью, следует уделить внимание их конструктивным особенностям. Спиральные характеризуются следующим особенностями:

- Внутри корпуса расположена спираль, которая связана с передающим элементам. Она изготавливается при применении специального металла с высокой упругостью.

- Циферблат соединен со спиралью, за счет проводится смена положения стрелки. Циферблат работает по механическому принципу, представлен шкалой со стрелкой. Как правило, на поверхности отображаются единицы измерения и другая более важная информация.

- При повышении давления проводится раскручивание спирали, за счет чего стрелка отклоняется в большей степени. От размеров этого элемента зависит диапазон, в котором могут проводится измерения.

Мембранные варианты исполнения функционируют за счет плоской пластины, которая связана с передающим элементом. При повышении давления мембрана прогибается в большей степени, за счет чего стрелка смещается.

Периодичность проведения поверки зависит от самых различных моментов, в том числе области применения устройства.

В некоторых случаях нужно проводить процедуру один раз в год, в других на протяжении 5 лет.

Входной контроль проводят многие организации с выездом на объект, так как в некоторых случаях процедуру должен проводить сертифицированный специалист и с учетом предъявляемого требования к обработке.

Тарировка манометра и другие процедуры раньше проводились раз в год, но из-за применения современных технологий при производстве позволило увеличить срок в два раза.

За счет этого точность показаний манометра находятся на высоком уровне.

Сегодня госповерку проводят при контроле состояния измерительных приборов ответственных систем. Расшифровываются полученные данные самым различным образом, поэтому процедура проводится исключительно специалистом.

Как проверить тонометр в домашних условиях?

Такая проверка, в отличие от поверки в госучреждении, может оказаться неточной, но в большинстве случаев она позволяет выявить возможные неполадки в работе прибора.

При покупке тонометра проверить прибор можно прямо в магазине. Для этого консультант проверит целостность и плотность стыковки трубок, груши, манжеты и убедиться, что стрелка манометра совпадает с о.

Проведет контрольное измерение проверенным по всем правилам прибором и измерение АД покупаемым приспособлением. Если они совпадают, то приобретаемый вами прибор работает точно и может применяться.

Как проверить точность электронного тонометра

? Для этого консультант проверяет целостность всех составляющих и, так же как при покупке механического прибора, сверяет показания АД на поверенном по всем правилам и покупаемом тонометре.

Такой же алгоритм проверки тонометра можно проводить и дома, но для этого вам понадобиться еще один тонометр, который прошел поверку в прошедших аккредитацию на право поверки средств измерений организациях или в центрах стандартизации, метрологии и испытаний (ЦСМ). Это так же не всегда возможно и будет лучше обратиться к специалистам.

Как проверить домашний тонометр

, если у вас нет возможности сверить показания с поверенным специалистами прибором? Для этого можно воспользоваться следующими правилами:

- убедитесь, что вы измеряете давление верно: правильно ли наложена манжета, целы ли все трубки, нет ли на них заломов и полностью ли заряжено устройство, если прибор электронный;

- если прибор механический, то убедитесь, что стрелка манометра находится строго на о;

- проведите несколько (3-5) измерений с интервалом в 5 минут в спокойном состоянии (то есть не после эмоциональной или физической нагрузки, курения или употребления алкоголя и кофеинсодержащих напитков);

- высчитайте среднее арифметическое значения для верхнего и нижнего давления – оно должно соответствовать вашему рабочему давлению или показателям возрастной нормы.

Как проверить точность тонометра в домашних условиях мы уже выяснили, теперь рассмотрим как настроить тонометр.

Методика поверки манометров

Существует довольно большое количество различных технологий, которые позволяют определить состояние измерительного устройства. Поверка технических манометров должна проводится исключительно профессионалами, так как допущенные ошибки могут стать причиной снижения точности снимаемых показателей. Оказывать услуги должны исключительно специалисты, получившие соответствующее разрешение.

Выделяют несколько наиболее распространенных технологий поверки:

- При применении гидравлического пресса. В этом случае измерительное устройство устанавливается между двумя элементами прибора. Стоит учитывать, что подобная технология проводимых измерений характеризуется низкой погрешностью. Существует довольно большое количество различных видов гидравлических прессов, все они характеризуются своими определенными особенностями. Подобная конструкция встречается исключительно в специализированных магазинах, для применения следует обладать определенными навыками и знаниями.

- При применении метрологического стенда. В этом случае основные показатели снимаются с минимальной погрешностью в установленных контрольных точках. Подобный прибор создает требующееся давление в системе. Среди особенностей использования метрологического стенда отметим то, что погрешности в измерении довольно высокие. Однако конструктивные особенности позволяют существенно расширить область применения устройства, к примеру, в случае высокого давления в системе.

- При использовании специального калибратора. Этот прибор можно сегодня приобрести в специализированном магазине для самостоятельной поверки устройства. При выборе калибратора уделяется внимание тому, в каком диапазоне показателей он может применяться. Большая часть моделей работает по одинаковой схеме.

§ 1. МАТЕРИАЛЫ ДЛЯ ЧЕКАННЫХ РАБОТ

Последний метод позволяет провести проверку устройств, которые не требуют опломбировки после проведенной процедуры.

Устройство характеризуется высокой мобильностью и может применяться без особой подготовки.

Поверка манометров: правила

Проводится проверка манометров должна исключительно с учетом основных правил и рекомендаций, так как допущенные ошибки могут привести к снижению точности изделия. Основные правила следующие:

- Для начала проводится осмотр манометра для определения состояния механизма. Повреждение устройства может указывать на то, что проводить поверку и вовсе не стоит. Некоторые из дефектов можно устранить, к примеру, провести замену защитного стекла, все зависит от особенностей конкретной модели манометра.

- Создаются наиболее приближенные условия к эксплуатационным. Примером можно назвать показатель влажности воздуха, атмосферного давления и температуры в помещении.

- Вначале проводимого испытания стрелка должна находится на нуле. За счет этого исключается вероятность допущения погрешности на момент проведения измерений.

Если нет возможности провести установку стрелки на ноль, то проводится регулировка устройства при помощи специального болта.

Как проверить газовый манометр

В общем случае проверка заключается лишь в том, чтобы сверить данные проверяемого манометра с показаниями контрольного прибора или рассчитать действующее давление газа, после чего измерить его с помощью манометра и сравнить данные. Для этого потребуется лишь контрольный манометр и термометр. Если описать данную процедуру более подробно, то она выглядит следующим образом:

- установите датчик манометра в емкость через специальный штуцер;

- в момент фиксации значения давления извлеките манометр, и установите на это место контрольный прибор;

- сравнив показания двух приборов, проверьте правильность показаний прибора;

- в случае, если показания прибора не совпадают с эталонным манометром, необходимо произвести его регулировку, чтобы при одинаковых рабочих условиях приборы показывали одни и те же значения давления;

- на корпусе манометра имеются регулировочные болты, с помощью которых и нужно произвести корректировку;

- с электронным аналогом действия те же, только нужно учитывать, что этот прибор имеет инерционность, поэтому показания нужно удерживать от 8 до 10 с.

При отсутствии эталонного прибора, нужно предварительно рассчитать рабочее давление по формуле P2=T2•P1/T1:

- для этого потребуется сосуд объема, который известен или можно его измерить, в нем находится воздух при нормальном атмосферном давлении и комнатной температуры;

- сосуд герметично закрывается и постепенно нагревается;

- далее просто рассчитывается давление внутри сосуда с помощью формулы, где Т1 и Т2 – это начальная и конечная температура воздуха в сосуде, а Р1 атмосферное давление.

- в случае, если показания прибора не совпадают с расчетом, тогда необходимо произвести его регулировку до тех данных, которые получились при расчете.

Требования к поверке манометров

Для сверки основных параметров измерительного прибора следует уделять внимание основным требованиям, которые предъявляются к проведению рассматриваемой процедуры. К ним можно отнести следующие моменты:

- Перед непосредственной проверкой следует предоставить документы, которые подтверждают прохождение этой процедуры ранее. Результаты, которые были получены ранее, также могут потребоваться при очередной поверке. Некоторые компании не проводят рассматриваемую процедуру в случае отсутствия соответствующего документа.

- Если устройство является частью ответственного механизма, то оно должно иметь пломбу. В противном случае механизм не может применяться по предназначению.

- В зависимости от давления в системе подбирается наиболее подходящее оборудование. Наиболее важными параметрами можно назвать диапазон измерений, а также область применения устройства.

- Данные с применяемого устройства должны хорошо считываться. Для этого выбираются наиболее оптимальные условия работы.

- Установка манометра должна проводится исключительно с соблюдением всех мер безопасности. Довольно распространенной ошибкой можно назвать снижение прочности соединения. При подаче сильного давления может появиться утечка, которая снизит давление в системе.

Все установленные нормы учитываются специалистом, который проводит поверку устройства. Если не учитывать требование, то состояние конструкции нельзя будет проверить с высокой точностью.

Сроки поверки манометров

Больше всего внимания уделяется установленным срокам. Назначение калибровки заключается в повышении точности снимаемых показателей. Среди особенностей отметим следующие моменты:

- При сдаче манометра на поверку нужно быть готовым к тому, что он будет находится в компании на протяжении 14 рабочих дней. Некоторые компании справляются с поставленной задачей намного быстрее. Не стоит забывать о том, что для поверки требуется довольно много времени, за счет чего исключается вероятность допущения ошибки.

- Для эталонных приборов срок уменьшен до 7 рабочих дней. При обращении в компанию, которая предоставляет рассматриваемые услуги, можно узнать то, в какие сроки будут проведены работы.

- Снизить сроки можно за счет предварительной подачи документов. Многие компании позволяют позвонить и заказать поверку, а также отправить документы в электронном виде для их предварительной проверки.

- Снять измерительный прибор с устройства можно только при вызове специалиста, который предоставляет соответствующие услуги. Не стоит забывать о том, что допущение ошибок на момент монтажа можно нарушить целостность магистрали.

- Проводимые испытания должны длиться определенный срок. Инструкцию по применению приборов калибровки зачастую производители добавляют в комплект поставки.

Самостоятельно провести рассматриваемую процедуру можно только в том случае, если прибор устанавливается в качестве элемента неответственных механизмов.

Описание

Принцип действия приборов основан на уравновешивании измеряемого давления силами упругой деформации манометрической пружины.

Отсчет показаний давления в магистралях производится по шкале циферблата приборов; отсчет разности давлений производится по шкале вращающегося диска.

Приборы имеют следующие модификации МП, МП-2, МП-2 с диском, МВП.

Манометры и мановакуумметры МП и МВП (хладоновые) предназначены для измерения избыточного и вакуумметрического плавно изменяющегося давления хладонов марок 12, 13, 22, 134а, 142, 404а и 502 (в том числе хладонов с наличием масел) в холодильных машинах, устанавливаемых в железнодорожных вагонах-рефрижераторах.

- Манометры МП (однострелочные) и манометры МП-2 (двухстрелочные) предназначены для измерения давления неагрессивных по отношению к медным сплавам жидких и газообразных сред (вода, топливо, масло, воздух) в силовых и тормозных системах и установках подвижного состава железных дорог, метрополитена и вагонов трамваев.

- Манометры МП-2 с вращающимся диском предназначены для измерения давления неагрессивных сред в установках общепромышленного назначения, а также для отсчёта разности давлений.

- Для измерения давления в местах, где имеет место пульсация измеряемой среды (с верхним значением диапазона показаний 1 МПа), приборы должны применяться только в комплекте с демпфирующим устройством ДВ.

- Для улучшения эксплуатационных характеристик приборы снабжены электрической подсветкой циферблата.

- Приборы могут быть изготовлены как с электрической подсветкой циферблата так и без

- неё.

- Приборы изготавливаются в корпусе 100 мм, с задним расположением фланца для крепления, радиальным или осевым расположением штуцера для отбора давления.

Источник

Версия для печати

В соответствии с уравнением (1) погрешность результата измерения объёма газа, приведенного к стандартным условиям, обусловлена следующими составляющими:

- погрешностью измерения объёма газа счётчиком в рабочих условиях;

- погрешностью измерения и регистрации абсолютной температуры газа;

- погрешностью измерения и регистрации абсолютного давления газа;

- методической погрешностью реализации алгоритма измерительной задачи вычислителем (далее — методическая погрешность вычислителя);

- методической погрешностью определения коэффициента сжимаемости;

- погрешностью определения объёма газа при стандартных условиях, которая связана с введением условно-постоянных значений величин (МИ 3235-2009).

Рассмотрим каждую из вышеперечисленных составляющих погрешности измерения объёма газа.

Погрешность измерения объёма газа в рабочих условиях определяется относительной погрешностью δp применяемого счётчика (турбинного, ротационного, вихревого) в соответствии с его паспортными метрологическими характеристиками.

Способы вычислений относительных погрешностей измерений и регистраций по каналам вычислителя (с учётом дополнительных погрешностей) абсолютной температуры δT и абсолютного давления δp подробно рассмотрены в ПР 50.2.019-2006 и МИ 3235-2009. Кроме того, в рекомендации МИ 3235-2009 анализируется случай измерения абсолютного давления газа посредством датчика избыточного давления и барометра. Кратко приведём основные шаги вычислений относительных погрешностей измерений и регистрации (по каналам вычислителя) абсолютного давления и абсолютной температуры. Для получения числовых данных примем, что узел учёта газа оснащён первичными измерительными преобразователями (датчиками):