Евклидово

пространство является

линейным

пространством. Поэтому

правомерно говорить о его размерности

и

его базисах.

Как

и произвольные линейные пространства,

евклидовы пространства можно разделить

на бесконечномерные

и

конечномерные.

Если

базис евклидова пространства представляет

собой ортогональную

систему векторов, то

этот базис называют ортогональным.

В

силу теоремы

3.4

любая ортогональная система

ненулевых

векторов

линейно независима, и

если она в п-мерном

евклидовом пространстве состоит из п

векторов,

то является базисом.

В

линейном пространстве все базисы

равноправны. В евклидовом же пространстве

наличие скалярного

умножения позволяет

выделить среди всех базисов ортогональные

и ортонормированные, которые более

удобны и играют в линейной алгебре роль,

аналогичную роли прямоугольной

системы координат в

аналитической геометрии.

Определение

3.7. Ортогональный

базис называют ортонормированным,

если

каждый вектор этого базиса имеет норму

(длину), равную

единице.

Дополнительное

требование к нормам векторов в

ортонормированном базисе в принципе

не является существенным, так как любой

ортогональный базис легко преобразовать

в ортонормированный, умножая векторы

на соответствующие нормирующие

коэффициенты (разделив каждый вектор

базиса на его длину). Однако дополнительная

нормировка векторов упрощает изложение

теории.

Пример

3.11. Система

из трех векторов

в

евклидовом

арифметическом пространстве

образует ортогональный базис, потому

что

Этот

базис не является ортонормированным,

так как, например,

Чтобы этот базис сделать ортонормированным,

нужно векторыа

и

b

разделить

на их нормы, т.е. на число

Пример

3.12. Векторы

i,

j

образуют

ортонормированный базис в пространстве

так же векторыi,

j,

k

образуют

ортонормированный базис в пространстве

3.7. Вычисления в ортонормированном базисе

Использование

ортонормированных

базисов облегчает

вычисление скалярного

произведения по

координатам

векторов. Пусть

в евклидовом

пространстве

некоторый базис

Рассмотрим

два произвольных вектора х

и

у

в

этом пространстве. Эти векторы

представляются в базисе е

своими

координатами:

Запишем

эти разложения

векторов по базису в

матричной форме:

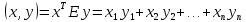

Скалярное

произведение векторов х

и

у

может

быть выражено через скалярные произведения

векторов базиса:

Составив

из скалярных произведений базисных

векторов квадратную матрицу

порядка

n,

мы можем записать скалярное произведение

заданных векторов в матричной форме:

Матрица

Г

является симметрической в силу

коммутативности операции скалярного

умножения. Ее называют матрицей

Грама системы

векторов

Пусть

базис е

является

ортонормированным. Тогда скалярное

произведение

при

несовпадающих i

и j

равно нулю, а скалярные квадраты базисных

векторов равны

Это значит, что для ортонормированного

базиса матрицаГ

является единичной. Поэтому

В

частности, в ортонормированном базисе

норма

вектора

x,

которая

выражается через скалярный квадрат

этого вектора, может быть вычислена по

формуле

а

для косинуса угла

векторами

x

и у

получаем

выражение

В

ортонормированном базисе

также

упрощается вычисление координат вектора:

они выражаются через скалярные

произведения. Если

то,

умножив равенство скалярно

на

вектор

находим, что

Пример

3.13.

В евклидовом арифметическом пространстве

Согласно формуле (3.8),

Соседние файлы в папке re

- #

- #

- #

- #

- #

- #

- #

- #

- #

From Wikipedia, the free encyclopedia

In mathematics, particularly linear algebra, an orthonormal basis for an inner product space V with finite dimension is a basis for

For a general inner product space

In functional analysis, the concept of an orthonormal basis can be generalized to arbitrary (infinite-dimensional) inner product spaces.[4] Given a pre-Hilbert space

If we go on to Hilbert spaces, a non-orthonormal set of vectors having the same linear span as an orthonormal basis may not be a basis at all. For instance, any square-integrable function on the interval ![[-1,1]](https://wikimedia.org/api/rest_v1/media/math/render/svg/51e3b7f14a6f70e614728c583409a0b9a8b9de01)

A different generalisation is to pseudo-inner product spaces, finite-dimensional vector spaces

Examples[edit]

- For

, the set of vectors

is called the standard basis and forms an orthonormal basis of

with respect to the standard dot product. Note that both the standard basis and standard dot product rely on viewing

as the Cartesian product

- Proof: A straightforward computation shows that the inner products of these vectors equals zero,

and that each of their magnitudes equals one,

This means that

is an orthonormal set. All vectors

can be expressed as a sum of the basis vectors scaled

so

spans

and hence must be a basis. It may also be shown that the standard basis rotated about an axis through the origin or reflected in a plane through the origin also forms an orthonormal basis of

.

- Proof: A straightforward computation shows that the inner products of these vectors equals zero,

- For

, the standard basis and inner product are similarly defined. Any other orthonormal basis is related to the standard basis by an orthogonal transformation in the group O(n).

- For pseudo-Euclidean space

, an orthogonal basis

with metric

instead satisfies

if

,

if

, and

if

. Any two orthonormal bases are related by a pseudo-orthogonal transformation. In the case

, these are Lorentz transformations.

- The set

with

where

denotes the exponential function, forms an orthonormal basis of the space of functions with finite Lebesgue integrals,

with respect to the 2-norm. This is fundamental to the study of Fourier series.

- The set

with

if

and

otherwise forms an orthonormal basis of

- Eigenfunctions of a Sturm–Liouville eigenproblem.

- The column vectors of an orthogonal matrix form an orthonormal set.

Basic formula[edit]

If

When

and the square of the norm of

Even if

If

Incomplete orthogonal sets[edit]

Given a Hilbert space

Existence[edit]

Using Zorn’s lemma and the Gram–Schmidt process (or more simply well-ordering and transfinite recursion), one can show that every Hilbert space admits an orthonormal basis;[6] furthermore, any two orthonormal bases of the same space have the same cardinality (this can be proven in a manner akin to that of the proof of the usual dimension theorem for vector spaces, with separate cases depending on whether the larger basis candidate is countable or not). A Hilbert space is separable if and only if it admits a countable orthonormal basis. (One can prove this last statement without using the axiom of choice.)

Choice of basis as a choice of isomorphism[edit]

For concreteness we discuss orthonormal bases for a real,

One way to view an orthonormal basis with respect to

We can now view the basis as a map

Explicitly we can write

The inverse is a component map

These definitions make it manifest that there is a bijection

The space of isomorphisms admits actions of orthogonal groups at either the

This space admits a left action by the group of isometries of

This space also admits a right action by the group of isometries of

As a principal homogeneous space[edit]

The set of orthonormal bases for

In other words, the space of orthonormal bases is like the orthogonal group, but without a choice of base point: given the space of orthonormal bases, there is no natural choice of orthonormal basis, but once one is given one, there is a one-to-one correspondence between bases and the orthogonal group.

Concretely, a linear map is determined by where it sends a given basis: just as an invertible map can take any basis to any other basis, an orthogonal map can take any orthogonal basis to any other orthogonal basis.

The other Stiefel manifolds

See also[edit]

- Orthogonal basis

- Basis (linear algebra) – Set of vectors used to define coordinates

- Orthonormal frame – Euclidean space without distance and angles

- Schauder basis

- Total set

References[edit]

- ^ Lay, David C. (2006). Linear Algebra and Its Applications (3rd ed.). Addison–Wesley. ISBN 0-321-28713-4.

- ^ Strang, Gilbert (2006). Linear Algebra and Its Applications (4th ed.). Brooks Cole. ISBN 0-03-010567-6.

- ^ Axler, Sheldon (2002). Linear Algebra Done Right (2nd ed.). Springer. ISBN 0-387-98258-2.

- ^ Rudin, Walter (1987). Real & Complex Analysis. McGraw-Hill. ISBN 0-07-054234-1.

- ^ Roman 2008, p. 218, ch. 9.

- ^ Linear Functional Analysis Authors: Rynne, Bryan, Youngson, M.A. page 79

- ^ «CU Faculty». engfac.cooper.edu. Retrieved 2021-04-15.

- Roman, Stephen (2008). Advanced Linear Algebra. Graduate Texts in Mathematics (Third ed.). Springer. ISBN 978-0-387-72828-5. (page 218, ch.9)

- Rudin, Walter (1991). Functional Analysis. International Series in Pure and Applied Mathematics. Vol. 8 (Second ed.). New York, NY: McGraw-Hill Science/Engineering/Math. ISBN 978-0-07-054236-5. OCLC 21163277.

External links[edit]

- This Stack Exchange Post discusses why the set of Dirac Delta functions is not a basis of L2([0,1]).

Оглавление — Линейная алгебра

Ортогональный и ортонормированный базисы евклидова пространства

Так как евклидово пространство является линейным, на него переносятся все понятия и свойства, относящиеся к линейному пространству, в частности, понятия базиса и размерности.

Базис [math]mathbf{e}_1,mathbf{e}_2,ldots,mathbf{e}_n[/math] евклидова пространства называется ортогональным, если все образующие его векторы попарно ортогональны, т.е.

[math]langle mathbf{e}_i,mathbf{e}_jrangle=0[/math] при [math]ine j,~~ i=1,2,ldots,n,~~ j=1,2,ldots,n.[/math]

Базис [math]mathbf{e}_1,mathbf{e}_2,ldots,mathbf{e}_n[/math] евклидова пространства называется ортонормированным, если его векторы попарно ортогональны и длина каждого из них равна единице:

[math]langle mathbf{e}_i,mathbf{e}_jrangle= begin{cases}1,&i=j,\ 0,&ine j end{cases}i=1,2,ldots,n,~~ j=1,2,ldots,n.[/math]

(8.31)

Теорема 8.5. В конечномерном евклидовом пространстве любую систему ортогональных (ортонормированных) векторов можно дополнить до ортогонального (ортонормированного) базиса.

В самом деле, по теореме 8.2 любую систему линейно независимых векторов, в частности, ортогональную (ортонормированную), можно дополнить до базиса. Применяя к этому базису процесс ортогонализации, получаем ортогональный базис. Нормируя векторы этого базиса (см. пункт 4 замечаний 8.11), получаем ортонормированный базис.

Выражение скалярного произведения через координаты сомножителей

Пусть [math]mathbf{e}_1,mathbf{e}_2,ldots,mathbf{e}_n[/math] — базис евклидова пространства, в котором векторы [math]mathbf{x}[/math] и [math]mathbf{y}[/math] имеют координаты [math]x_1,x_2,ldots,x_n[/math] и [math]y_1,y_2,ldots,y_n[/math] соответственно, т.е.

[math]mathbf{x}= x_1 mathbf{e}_1+x_2 mathbf{e}_2+ldots+ x_n mathbf{e}_n,qquad mathbf{y}= y_1 mathbf{e}_1+y_2 mathbf{e}_2+ldots+ y_n mathbf{e}_n.[/math]

Выразим скалярное произведение, используя следствие 3 из аксиом скалярного произведения:

[math]langle mathbf{x},mathbf{y}rangle= langle x_1 mathbf{e}_1+x_2 mathbf{e}_2+ldots+ x_n mathbf{e}_n,, y_1 mathbf{e}_1+y_2 mathbf{e}_2+ldots+ y_n mathbf{e}_n rangle= sum_{i=1}^{n}sum_{i=1}^{n}x_iy_jlangle mathbf{e}_i,mathbf{e}_jrangle.[/math]

Преобразуем это выражение, используя операции с матрицами:

[math]langle mathbf{x},mathbf{y}rangle= x^Tcdot G(mathbf{e}_1,mathbf{e}_2,ldots, mathbf{e}_n)cdot y,[/math]

(8.32)

где [math]x=begin{pmatrix}x_1&cdots x_nend{pmatrix}^T,~ y=begin{pmatrix} y_1&cdots& y_n end{pmatrix}^T[/math] — координатные столбцы векторов [math]mathbf{x}[/math] и [math]mathbf{y}[/math], a [math]G(mathbf{e}_1,mathbf{e}_2,ldots, mathbf{e}_n)[/math] — квадратная симметрическая матрица, составленная из скалярных произведений

[math]G(mathbf{e}_1,mathbf{e}_2,ldots, mathbf{e}_n)= begin{pmatrix} langle mathbf{e}_1,mathbf{e}_1rangle& langle mathbf{e}_1,mathbf{e}_2rangle &cdots&langle mathbf{e}_1, mathbf{e}_nrangle\ langle mathbf{e}_2,mathbf{e}_1rangle& langle mathbf{e}_2, mathbf{e}_2rangle &cdots&langle mathbf{e}_2,mathbf{e}_nrangle\ vdots&vdots&ddots&vdots\ langle mathbf{e}_n,mathbf{e}_1rangle& langle mathbf{e}_n,mathbf{e}_2rangle &cdots&langle mathbf{e}_n,mathbf{e}_nrangle end{pmatrix}!.[/math]

(8.33)

которая называется матрицей Грама системы векторов [math]mathbf{e}_1,mathbf{e}_2,ldots,mathbf{e}_n[/math].

Преимущества ортонормированного базиса

Для ортонормированного базиса [math]mathbf{e}_1,mathbf{e}_2,ldots,mathbf{e}_n[/math] формула (8.32) упрощается, так как из условия (8.31) следует, что матрица Грама [math]G(mathbf{e}_1, mathbf{e}_2,ldots,mathbf{e}_n)[/math] ортонормированной системы [math]mathbf{e}_1, mathbf{e}_2,ldots, mathbf{e}_n[/math] равна единичной матрице: [math]G(mathbf{e}_1, mathbf{e}_2,ldots,mathbf{e}_n)=E[/math].

1. В ортонормированном базисе [math]mathbf{e}_1,mathbf{e}_2,ldots, mathbf{e}_n[/math] скалярное произведение векторов [math]mathbf{x}[/math] и [math]mathbf{y}[/math] находится по формуле: [math]langle mathbf{x},mathbf{y}rangle= x_1y_1+x_2y_2+ldots+x_ny_n[/math], где [math]x_1,ldots,x_n[/math] — координаты вектора [math]mathbf{x}[/math], а [math]y_1,ldots,y_n[/math] — координаты вектора [math]mathbf{y}[/math].

2. В ортонормированном базисе [math]mathbf{e}_1,mathbf{e}_2,ldots, mathbf{e}_n[/math] длина вектора [math]mathbf{x}[/math] вычисляется по формуле [math]|mathbf{x}|= sqrt{x_1^2+x_2^2+ldots+x_n^2}[/math], где [math]x_1,ldots,x_n[/math] — координаты вектора [math]mathbf{x}[/math].

3. Координаты [math]x_1,ldots,x_n[/math] вектора [math]mathbf{x}[/math] относительно ортонормированного базиса [math]mathbf{e}_1,mathbf{e}_2,ldots,mathbf{e}_n[/math] находятся при помощи скалярного произведения по формулам: [math]x_1=langle mathbf{x},mathbf{e}_1rangle,ldots, x_n=langle mathbf{x},mathbf{e}_nrangle[/math].

В самом деле, умножая обе части равенства [math]mathbf{x}= x_1 mathbf{e}_1+ldots+x_n mathbf{e}_n[/math] на [math]mathbf{e}_1[/math], получаем

[math]langle mathbf{x},mathbf{e}_1rangle= x_1underbrace{langlemathbf{e}_1, mathbf{e}_1 rangle}_{1}+ x_2underbrace{langle mathbf{e}_1,mathbf{e}_2 rangle}_{0}+ldots+ x_nunderbrace{langle mathbf{e}_n, mathbf{e}_n rangle}_{0}quad Leftrightarrowquad x_1=langle mathbf{x},mathbf{e}_1rangle.[/math]

Аналогично доказываются остальные формулы.

Изменение матрицы Грама при переходе от одного базиса к другому

Пусть [math](mathbf{e})=(mathbf{e}_1,ldots,mathbf{e}_n)[/math] и [math](mathbf{f})= (mathbf{f}_1,ldots,mathbf{f}_n)[/math] — два базиса евклидова пространства [math]mathbb{E}[/math], a [math]S[/math] — матрица перехода от базиса [math](mathbf{e})[/math] к базису [math](mathbf{f})colon, (mathbf{f})=(mathbf{e})S[/math]. Требуется найти связь матриц Грама систем векторов [math](mathbf{e})[/math] и [math](mathbf{f})[/math]

По формуле (8.32) вычислим скалярное произведение векторов [math]mathbf{x}[/math] и [math]mathbf{y}[/math] в разных базисах:

[math]langle mathbf{x},mathbf{y}rangle= {mathop{x}limits_{(mathbf{e})}}^Tcdot, G(mathbf{e}_1,ldots,mathbf{e}_n)cdot mathop{mathbf{y}}limits_{(mathbf{e})}= {mathop{x}limits_{(mathbf{f})}}^Tcdot, G(mathbf{f}_1,ldots,mathbf{f}_n)cdot mathop{mathbf{y}}limits_{(mathbf{f})},[/math]

где [math]mathop{x}limits_{(mathbf{e})},, mathop{x}limits_{(mathbf{f})}[/math] и [math]mathop{y}limits_{(mathbf{e})},, mathop{y}limits_{(mathbf{f})}[/math] — координатные столбцы векторов [math]mathbf{x}[/math] и [math]mathbf{y}[/math] в соответствующих базисах. Подставляя в последнее равенство связи [math]mathop{x}limits_{(mathbf{e})}= S mathop{x}limits_{(mathbf{f})},[/math] [math]mathop{y}limits_{(mathbf{e})}= S mathop{y}limits_{(mathbf{f})}[/math], получаем тождество

[math]{mathop{x}limits_{(mathbf{f})}}^Tcdot S^Tcdot, G(mathbf{e}_1,ldots,mathbf{e}_n)cdot Scdot mathop{mathbf{y}}limits_{(mathbf{f})}= {mathop{x}limits_{(mathbf{f})}}^Tcdot, G(mathbf{f}_1,ldots,mathbf{f}_n)cdot mathop{mathbf{y}}limits_{(mathbf{f})}.[/math]

Отсюда следует формула изменения матрицы Грама при переходе от одного базиса к другому:

[math]G(mathbf{f}_1,ldots,mathbf{f}_n)= S^Tcdot G(mathbf{e}_1,ldots,mathbf{e}_n)cdot S.[/math]

Записав это равенство для ортонормированных базисов [math](mathbf{e})[/math] и [math](mathbf{f})[/math], получаем [math]E=S^TES[/math], так как матрицы Грама ортонормированных базисов единичные: [math]G(mathbf{e}_1,ldots,mathbf{e}_n)= G(mathbf{f}_1,ldots,mathbf{f}_n)=E[/math]. Поэтому матрица [math]S[/math] перехода от одного ортонормированного базиса к другому является ортогональной: [math]S^{-1}=S^T[/math].

Свойства определителя Грама

Определитель матрицы (8.33) называется определителем Грама. Рассмотрим свойства этого определителя.

1. Критерий Грама линейной зависимости векторов: система векторов [math]mathbf{v}_1,mathbf{v}_2, ldots, mathbf{v}_k[/math] линейно зависима тогда и только тогда, когда определитель Грама этой системы равен нулю.

Действительно, если система [math]mathbf{v}_1, mathbf{v}_2, ldots,mathbf{v}_k[/math] линейно зависима, то существуют такие числа [math]x_1,x_2,ldots,x_k[/math], не равные нулю одновременно, что

[math]x_1cdot mathbf{v}_1+x_2cdot mathbf{v}_2+ldots+ x_kcdot mathbf{v}_k= mathbf{o}.[/math]

Умножая это равенство скалярно на [math]mathbf{v}_1[/math], затем на [math]mathbf{v}_2[/math] и т.д. на [math]mathbf{v}_k[/math], получаем однородную систему уравнений [math]G(mathbf{v}_1,mathbf{v}_2,ldots,mathbf{v}_k)x=o[/math], которая имеет нетривиальное решение [math]x=begin{pmatrix}x_1&cdots&x_k end{pmatrix}^T[/math]. Следовательно, ее определитель равен нулю. Необходимость доказана. Достаточность доказывается, проводя рассуждения в обратном порядке.

Следствие. Если какой-либо главный минор матрицы Грама равен нулю, то и определитель Грама равен нулю.

Главный минор матрицы Грама системы [math]mathbf{v}_1, mathbf{v}_2,ldots,mathbf{v}_k[/math] представляет собой определитель Грама подсистемы векторов. Если подсистема линейно зависима, то и вся система линейно зависима.

2. Определитель Грама [math]det{G (mathbf{v}_1,mathbf{v}_2, ldots, mathbf{v}_k)}[/math] не изменяется в процессе ортогонализации системы векторов [math]mathbf{v}_1,mathbf{v}_2,ldots,mathbf{v}_k[/math]. Другими словами, если в процессе ортогонализации векторов [math]mathbf{v}_1,mathbf{v}_2,ldots,mathbf{v}_k[/math] получены векторы [math]mathbf{w}_1,mathbf{w}_2,ldots,mathbf{w}_k[/math], то

[math]det G(mathbf{v}_1,mathbf{v}_2,ldots,mathbf{v}_k)= det G(mathbf{w}_1, mathbf{w}_2, ldots,mathbf{w}_k)= langle mathbf{w}_1,mathbf{w}_1ranglecdot langle mathbf{w}_2,mathbf{w}_2ranglecdot ldotscdot langle mathbf{w}_k,mathbf{w}_krangle.[/math]

Действительно, в процессе ортогонализации по векторам [math]mathbf{v}_1,mathbf{v}_2, ldots,mathbf{v}_k[/math] последовательно строятся векторы

[math]mathbf{w}_1=mathbf{v}_1,quad mathbf{w}_2= mathbf{v}_2- alpha_{21} mathbf{w}_1,quad ldots,quad mathbf{w}_k= mathbf{v}_k- sum_{j=1}^{k-1}alpha_{kj} mathbf{w}_j.[/math]

После первого шага определитель Грама не изменяется

[math]det G(mathbf{v}_1,mathbf{v}_2,ldots,mathbf{v}_k)= det G(mathbf{w}_1, mathbf{v}_2, ldots,mathbf{v}_k).[/math]

Выполним с определителем [math]det G(mathbf{w}_1, mathbf{v}_2, ldots,mathbf{v}_k)[/math] следующие преобразования. Прибавим ко второй строке первую, умноженную на число [math](-alpha_{21})[/math], а затем ко второму столбцу прибавим первый, умноженный на [math](-alpha_{21})[/math]. Получим определитель

[math]det G(mathbf{w}_1,mathbf{v}_2-alpha_{21}mathbf{w}_1,ldots,mathbf{v}_k)= det G(mathbf{w}_1,mathbf{w}_2, mathbf{v}_3, ldots,mathbf{v}_k).[/math]

Так как при этих преобразованиях определитель не изменяется, то

[math]det G(mathbf{v}_1,mathbf{v}_2,ldots,mathbf{v}_k)= det G(mathbf{w}_1, mathbf{v}_2,ldots,mathbf{v}_k)= det G(mathbf{w}_1, mathbf{w}_2,mathbf{v}_3, ldots,mathbf{v}_k).[/math]

Значит, после второго шага в процессе ортогонализации определитель не изменяется. Продолжая аналогично, получаем после [math]k[/math] шагов:

[math]det G(mathbf{v}_1,mathbf{v}_2,ldots,mathbf{v}_k)= det G(mathbf{w}_1, mathbf{w}_2, ldots,mathbf{w}_k).[/math]

Вычислим правую часть этого равенства. Матрица [math]G(mathbf{w}_1,mathbf{w}_2,ldots, mathbf{w}_k)[/math] Грама ортогональной системы [math]mathbf{v}_1,mathbf{v}_2, ldots,mathbf{v}_k[/math] векторов является диагональной, так как [math]langle mathbf{w}_i,mathbf{w}_jrangle=0[/math] при [math]ine j[/math]. Поэтому ее определитель равен произведению элементов, стоящих на главной диагонали:

[math]det G(mathbf{w}_1,mathbf{w}_2,ldots,mathbf{w}_k)= langle mathbf{w}_1, mathbf{w}_1ranglecdot langle mathbf{w}_2,mathbf{w}_2ranglecdot ldots langle mathbf{w}_k, mathbf{w}_krangle.[/math]

3. Определитель Грама любой системы [math]mathbf{v}_1,mathbf{v}_2,ldots, mathbf{v}_k[/math] векторов удовлетворяет двойному неравенству

[math]0leqslant det G(mathbf{v}_1,mathbf{v}_2,ldots,mathbf{v}_k) leqslant langle mathbf{v}_1, mathbf{v}_1ranglecdot langle mathbf{v}_2,mathbf{v}_2ranglecdot ldots langle mathbf{v}_k, mathbf{v}_krangle.[/math]

Докажем неотрицательность определителя Грама. Если система [math]mathbf{v}_1,mathbf{v}_2, ldots, mathbf{v}_k[/math] линейно зависима, то определитель равен нулю (по свойству 1). Если же система [math]mathbf{v}_1,mathbf{v}_2,ldots, mathbf{v}_k[/math] линейно независима, то, выполнив процесс ортогонализации, получим ненулевые векторы [math]mathbf{w}_1,mathbf{w}_2, ldots, mathbf{w}_k[/math], для которых по свойству 2:

[math]det G(mathbf{v}_1,mathbf{v}_2,ldots, mathbf{v}_k)= det G(mathbf{w}_1, mathbf{w}_2, ldots, mathbf{w}_k)= |mathbf{w}_1|^2cdot |mathbf{w}_2|^2cdot ldotscdot |mathbf{w}_k|^2>0.[/math]

Оценим теперь скалярный квадрат [math]langle mathbf{v}_j,mathbf{w}_jrangle[/math]. Выполняя процесс ортого-1нализации, имеем [math]mathbf{v}_j= mathbf{w}_j+ alpha_{j,1}mathbf{w}_1+ ldots+ alpha_{j,j-1}mathbf{w}_{j-1}[/math]. Отсюда

[math]langle mathbf{v}_j,mathbf{w}_jrangle= langle mathbf{w}_j,mathbf{w}_jrangle+ sum_{i=1}^{j-1}alpha_{i,i}^2 langle mathbf{w}_j,mathbf{w}_jrangle geqslant langle mathbf{w}_j, mathbf{w}_jrangle.[/math]

Следовательно, по свойству 2 имеем

[math]langle mathbf{v}_1,mathbf{v}_1ranglecdot langle mathbf{v}_2,mathbf{v}_2 ranglecdot ldotscdot langle mathbf{v}_k,mathbf{v}_kranglegeqslant langle mathbf{w}_1, mathbf{w}_1ranglecdot langle mathbf{w}_2,mathbf{w}_2ranglecdot ldotscdot langle mathbf{w}_k, mathbf{w}_krangle= det G(mathbf{w}_1,mathbf{w}_2,ldots,mathbf{w}_k).[/math]

Замечания 8.12

1. Матрица Грама любой системы векторов является неотрицательно определенной, так как все ее главные миноры также являются определителями Грама соответствующих подсистем векторов и неотрицательны в силу свойства 3.

2. Матрица Грама любой линейно независимой системы векторов является положительно определенной, так как все ее угловые миноры положительны (в силу свойств 1,3), поскольку являются определителями Грама линейно независимых подсистем векторов.

3. Определитель квадратной матрицы [math]A[/math] (n-го порядка) удовлетворяет неравенству Адамара:

[math](det{A})^2leqslant prod_{i=1}^{n}Bigl(a_{i,1}^2+ a_{i,2}^2+ldots+ a_{i,n}^2Bigr).[/math]

Действительно, обозначив [math]a_1,a_2,ldots,a_n[/math] столбцы матрицы [math]A[/math], элементы матрицы [math]A^TA[/math] можно представить как скалярные произведения (8.27): [math]langle a_i,a_jrangle= (a_i)^Ta_j[/math]. Тогда [math]A^TA=G(a_1,a_2,ldots,a_n)[/math] — матрица Грама системы [math]a_1,a_2,ldots,a_n[/math] векторов пространства [math]mathbb{R}^n[/math]. По свойству 3, теореме 2.2 и свойству 1 определителя получаем доказываемое неравенство:

[math]begin{aligned} (det{A})^2&= det{A}cdotdet{A}= det{A^T}cdotdet{A}= det(A^TA)= det G(a_1,a_2,ldots,a_n)leqslant\[2pt] &leqslant |a_1|^2cdot |a_2|^2cdot ldotscdot |a_n|^2= prod_{i=1}^{n}Bigl(a_{i,1}^2+ a_{i,2}^2+ldots+ a_{i,n}^2Bigr). end{aligned}[/math]

4. Если [math]A[/math] — невырожденная квадратная матрица, то любой главный минор матрицы [math]A^TA[/math] положителен. Это следует из пункта 2, учитывая представление произведения [math]A^TA=G(a_1,ldots,a_n)[/math] как матрицы Грама системы линейно независимых векторов [math]a_1,ldots,a_n[/math] — столбцов матрицы [math]A[/math] (см. пункт 3).

Изоморфизм евклидовых пространств

Два евклидовых пространства [math]mathbb{E}[/math] и [math]mathbb{E}'[/math] называются изоморфными [math](mathbb{E}leftrightarrow mathbb{E}’)[/math], если они изоморфны как линейные пространства и скалярные произведения соответствующих векторов равны:

[math]left.{begin{matrix}mathbf{u}leftrightarrow mathbf{u}’\ mathbf{v}leftrightarrow mathbf{v}’end{matrix}}right}quad Rightarrowquad langle mathbf{u},mathbf{v}rangle= langle mathbf{u}’,mathbf{v}’rangle’.[/math]

‘

где [math](cdot,cdot)[/math] и [math](cdot,cdot)'[/math] — скалярные произведения в пространствах [math]mathbb{E}[/math] и [math]mathbb{E}'[/math] соответственно.

Напомним, что для изоморфизма конечномерных линейных пространств необходимо и достаточно, чтобы их размерности совпадали (см. теорему 8.3). Покажем, что это условие достаточно для изоморфизма евклидовых пространств (необходимость следует из определения). Как и при доказательстве теоремы 8.3, установим изоморфизм n-мерного евклидова пространства [math]mathbb{E}[/math] с вещественным арифметическим пространством [math]mathbb{R}^n[/math] со скалярным произведением (8.27). В самом деле, взяв в пространстве [math]mathbb{E}[/math] какой-нибудь ортонормированный базис [math](mathbf{e})=(mathbf{e}_1,ldots,mathbf{e}_n)[/math], поставим в соответствие каждому вектору [math]mathbf{x}in mathbb{E}[/math] его координатный столбец [math]xin mathbb{R}^n~ (mathbf{x}leftrightarrow x)[/math]. Это взаимно однозначное соответствие устанавливает изоморфизм линейных пространств: [math]mathbb{E}leftrightarrow mathbb{R}^n[/math]. В ортонормированном базисе скалярное произведение векторов [math]mathbf{x}[/math] и [math]mathbf{y}[/math] пространства [math]mathbb{E}[/math] находится по формуле

[math]langle mathbf{x},mathbf{y}rangle= x_1cdot y_1+x_2cdot y_2+ldots+x_ncdot y_n[/math]

(см. пункт 1 преимуществ ортонормированного базиса). Такое же выражение дает скалярное произведение (8.27) координатных столбцов [math]x[/math] и [math]y[/math], т.е. скалярные произведения соответствующих элементов равны

[math]langle mathbf{x},mathbf{y}rangle= x_1cdot y_1+x_2cdot y_2+ldots+x_ncdot y_n=x^Tcdot y.[/math]

Следовательно, евклидовы пространства [math]mathbb{E}[/math] и [math]mathbb{R}^n[/math] изоморфны.

Таким образом, изучение конечномерных евклидовых пространств может быть сведено к исследованию вещественного арифметического пространства [math]mathbb{R}^n[/math] со стандартным скалярным произведением (8.27).

Математический форум (помощь с решением задач, обсуждение вопросов по математике).

Если заметили ошибку, опечатку или есть предложения, напишите в комментариях.

Все курсы > Линейная алгебра > Занятие 2

Продолжим работать в том же ноутбуке⧉

Определение

С понятием вектора тесно связано понятие векторного или линейного пространства (vector space, linear space).

По большому счету, векторное пространство — это множество векторов, которые мы можем складывать (vector addition) и умножать на число или скаляр (scalar multiplication).

В частности, сложение и умножение на число двумерных (состоящих из двух компонентов) векторов дает нам двумерный вектор, трехмерных — трехмерный и так далее.

$$ begin{bmatrix} 3 \ 4 end{bmatrix} + 2 cdot begin{bmatrix} 1 \ 2 end{bmatrix} = begin{bmatrix} 5 \ 8 end{bmatrix} $$

При этом сложить, например, двумерный и трехмерный вектор нельзя

$$ begin{bmatrix} 3 \ 4 end{bmatrix} + begin{bmatrix} 4 \ 3 \ 3 end{bmatrix} = ? $$

Также нельзя сформировать векторное пространство из двумерных векторов, лежащих только в первой четверти координатной плоскости. Хотя для таких векторов будет задана операция сложения, при умножении на отрицательный скаляр мы можем выйти за пределы первой четверти.

Поэтому говорят, что векторное пространство должно быть замкнуто относительно операций сложения и умножения на скаляр (closed under vector addition and scalar multiplication).

Двумерное пространтсво вещественных чисел принято обозначать $R^2$, трехмерное $R^3$, n-мерное — $R^n$.

Отметим, что вектор $begin{bmatrix} 1 \ 2 \ 0 end{bmatrix}$ — это вектор в $R^3$ с нулевым третьим компонентом.

Линейная комбинация векторов

Любой вектор внутри одного пространства (например, $R^2$) можно представить как линейную комбинацию конечного числа векторов (linear combination of a finite set of vectors).

$$ 2 cdot begin{bmatrix} 1 \ 2 end{bmatrix} + 3 cdot begin{bmatrix} 2 \ 1 end{bmatrix} = begin{bmatrix} 8 \ 7 end{bmatrix} $$

Под линейной комбинацией, как вы видите, понимается опять же сложение векторов и их умножение на число.

Аксиомы векторных пространств

Операции в векторных пространствах должны отвечать следующим правилам:

- $ mathbf u + (mathbf v + mathbf w) = (mathbf u + mathbf v) + mathbf w $

- $ mathbf v + mathbf w = mathbf w + mathbf v $

- Существует нулевой вектор $ mathbf 0 Rightarrow mathbf 0 + mathbf v = mathbf v, forall mathbf v $

- Для каждого $ mathbf v $ существует $ -mathbf v Rightarrow mathbf v + (-mathbf v) $

- $ a(b mathbf v) = (ab) mathbf v $

- $ 1 mathbf v = mathbf v $

- $ a(mathbf v + mathbf w) = a mathbf v + a mathbf w $

- $ (a + b) mathbf v = a mathbf v + b mathbf v $

Этим правилам могут отвечать не только векторы действительных чисел в пространстве $R^n$ (Евклидово пространство), но и, в частности, векторы функций. В этом случае речь идет о функциональных пространствах (function spaces).

Видео про абстрактные векторные пространства⧉.

Примечание. Некоторые понятия, упомянутые в видео выше, в частности, линейные преобразования (linear transformations), ядро матрицы (null space) и собственные векторы и значения (eigenvectors and eigenvalues) будут рассмотрены на более поздних занятиях.

Серия видео про алгебраические структуры⧉.

Внутреннее произведение

Скалярное произведение (dot product) является частным случаем внутреннего произведения (inner product) для евклидового пространства.

Приведем простой пример того, почему скалярное произведение может не подойти для векторов, состоящих, например, из комплексных чисел $mathbb C$. Ранее мы сказали, что скалярное произведение вектора самого на себя есть квадрат длины этого вектора, т.е. $mathbf x^T mathbf x = || mathbf x ||^2 $, и нам бы хотелось, чтобы квадрат длины был положителен.

Для действительных векторов это условие выполняется всегда, так как мы возводим в квадрат каждый компонент (вещественное число) такого вектора. Теперь рассмотрим комплексный вектор

$$ mathbf z = begin{bmatrix} 1 \ i end{bmatrix} in mathbb C^2 $$

По правилам скалярного произведения квадрат его длины был бы равен

$$ mathbf z^T mathbf z = begin{bmatrix} 1 & i end{bmatrix} begin{bmatrix} 1 \ i end{bmatrix} = 1 cdot 1 + i cdot i = 1-1 = 0 $$

Для того чтобы квадрат ненулевого вектора не был равен нулю в векторных пространствах комплексных чисел скалярное (а точнее внутреннее) произведение задано как $overline{mathbf z}^T mathbf z$, где $overline{mathbf z}$ является комплексно сопряженным (complex conjugate) к $mathbf z$ вектором. Тогда,

$$ overline{mathbf z}^T mathbf z = begin{bmatrix} 1 & -i end{bmatrix} begin{bmatrix} 1 \ i end{bmatrix} = 1 cdot 1 + (-i) cdot i = 1+1 = 2 $$

Векторное подпространство

Определение

Подпространством (subspace) векторного пространства $K$ называется множество $S$ его элементов, само являющееся векторным пространством относительно введенных в $K$ операций сложения и умножения на число.

Другими словами, чтобы $S$ было подпространством $K$ для каждого $mathbf v, mathbf w in S, K$ и $a in mathbb{R}$ должно выполняться ${ mathbf v + mathbf w, a mathbf v } in S, K$.

Например, выше мы сказали, что векторы $R^2$ первой четверти координатной плоскости не могут образовывать векторное пространство, потому что мы не можем задать для них операцию умножения на число, результатом которой был бы вектор только в этой четверти.

При этом, если мы возьмем на пространстве $R^2$ подпространство всех векторов, лежащих на прямой линии и проходящих через начало координат, то такое подпространство будет отвечать аксиомам векторных пространств.

Примечание. $R^1$ нельзя назвать подпространством $R^2$, потому что у векторов $R^1$ только один компонент, а у векторов $R^2$, даже тех, которые лежат на одной линии, их два.

Пересечение подпространств

Если $S$ и $T$ — подпространства, то $S cap T$ тоже подпространство. Возьмем $mathbf v, mathbf w in S, T$. Тогда $mathbf v + mathbf w in S, T$ и $a mathbf v in S,T$, так как $S$ и $T$ отвечают свойствам подпространств.

Ортогональные подпространства

Подпространство $S$ будет ортогонально подпространству $T$, если каждый вектор в $S$ ортогонален каждому вектору в $T$.

$$ forall mathbf v in S perp forall mathbf w in T $$

Ортогональное дополнение

Если внутри некоторого пространства $K$ существует подпространство $S$, и внутри этого же пространства $K$ можно найти другое ортогональное ему подпространство $S^{perp}$, то такое подпространство называется ортогональным дополнением (orthogonal complement) подпространства $S$.

Более формально, пусть $S$ — подпространство $K$. Тогда ортогональным дополнением $S^{perp}$ будет множество всех векторов $mathbf w in K$, для которых скалярное произведение $mathbf w cdot mathbf v = 0$ для любого $mathbf v in S$.

$$ S^{perp} = { mathbf w in K hspace{5pt} | hspace{5pt} mathbf w cdot mathbf v = 0, hspace{5pt} forall mathbf v in S hspace{2pt} } $$

Покажем, что $S^{perp}$ также является подпространством. Возьмем два вектора $mathbf a, mathbf b in S^{perp} $. Для того чтобы $S^{perp}$ было подпространством, нам нужно продемонстрировать замкнутость относительно сложения и умножения на скаляр.

$$ mathbf a + mathbf b underset{mathord{?}}{in} S^{perp} $$

$$ c cdot mathbf a underset{mathord{?}}{in} S^{perp} $$

Начнем со сложения. По определению ортогонального дополнения

$$ mathbf a cdot mathbf v = 0, hspace{5pt} forall mathbf v in S $$

$$ mathbf b cdot mathbf v = 0, hspace{5pt} forall mathbf v in S $$

Тогда,

$$ (mathbf a + mathbf b) cdot mathbf v = mathbf a cdot mathbf v + mathbf b cdot mathbf v = mathbf 0 + mathbf 0 = mathbf 0 $$

Другими словами, мы показали, что сумма векторов принадлежащих $ S^{perp} $ также ортогонально вектору $mathbf v in S$, а значит принадлежит $ S^{perp} $, $ mathbf a + mathbf b in S^{perp} $. Перейдем к умножению на скаляр.

$$ c cdot mathbf a cdot mathbf v = c cdot ( mathbf a cdot mathbf v) = c cdot mathbf 0 = mathbf 0 $$

Это доказывает, что $ c cdot mathbf a in S^{perp} $.

Таким образом, ортогональное дополнение подпространства само является векторным подпространством.

Отметим, что нулевой вектор всегда принадлежит ортогональному дополнению, поскольку при $c = 0$

$$ c cdot mathbf a = 0 cdot mathbf a = mathbf 0 rightarrow mathbf 0 in S^{perp} $$

Обратите внимание, что нулевой вектор также присутствует в подпространстве $S$, $mathbf 0 in S$.

Более того, $S cap S^{perp} = { mathbf 0 } $. Это легко доказать. Возьмем некоторый вектор $mathbf x$, который одновременно принадлежит $ S $ и $ S^{perp} $, $mathbf x in S, S^{perp}$.

Тогда по определению ортогонального дополнения должно выполняться $mathbf x cdot mathbf x = 0 $. Такому условию отвечает только нулевой вектор.

Линейная независимость векторов

Когда один вектор можно выразить через умножение другого вектора на число говорят, что эти векторы линейно зависимы (linearly dependent). С двумя линейно независимыми (linearly independent) векторами $ mathbf v_1, mathbf v_2 $ такого сделать не получится.

$$ mathbf v_2 neq k mathbf v_1 $$

где k — некоторое число.

Рассмотрим пример трех векторов. Чтобы эти три вектора были линейно независимы, не должно быть возможности выразить третий вектор через линейные комбинации (сложение и умножение на скаляр) первых двух.

$$ mathbf v_3 neq k_1 mathbf v_1 + k_2 mathbf v_2 $$

Если так сделать нельзя, мы попадаем в трехмерное пространство, если можно — останемся на плоскости.

Линейная оболочка

Линейная оболочка (linear span) — это множество всех возможных линейных комбинаций с помощью данного набора векторов.

Если у нас два линейно независимых (двумерных) вектора, то оболочка — $R^2$ (плоскость), если три (трехмерных) вектора, но один из них линейно зависим, то по-прежнему $R^2$.

Оболочка — это ответ на вопрос, какие векторы можно построить с помощью сложения и умножения на скаляр $n$ n-мерных векторов. Линейно зависимый вектор находится внутри оболочки, создаваемой комбинациями других линейно независимых векторов.

Базис пространства

Имея два двумерных линейно независимых вектора (например, $begin{bmatrix} 1 \ 2 end{bmatrix}$ и $begin{bmatrix} 3 \ 1 end{bmatrix}$), мы можем представить любой другой вектор в пространстве $ R^2 $, сложив эти два вектора и умножив их на скаляр. Такие векторы называются базисом пространства (basis of a vector space) $ R^2 $, по сути его координатами.

В целом, базисом называется такое множество линейно независимых векторов внутри векторного пространства, с помощью которых можно выразить любой другой вектор этого пространства.

Базис можно представить как некоторую систему координат, которой пользуются все векторы данного пространства.

Повторим пример с единичными векторами $mathbf i$ и $mathbf j$.

|

i = np.array([1, 0]) j = np.array([0, 1]) ax = plt.axes() plt.xlim([—0.07, 3]) plt.ylim([—0.07, 3]) plt.grid() ax.arrow(0, 0, i[0], i[1], width = 0.02, head_width = 0.1, head_length = 0.2, length_includes_head = True, fc = ‘g’, ec = ‘g’) ax.arrow(0, 0, j[0], j[1], width = 0.02, head_width = 0.1, head_length = 0.2, length_includes_head = True, fc = ‘g’, ec = ‘g’) plt.show() |

Приведенный выше базис называется стандартным (standard, natural basis). Это самый «экономный» или удобный способ представить все остальные векторы этого пространства.

При этом выбор такого базиса конечно условен, ничто не мешает мне перейти к другой системе координат, то есть другому базису.

Можно сказать, что координаты вектора имеют смысл только если мы знаем в какой системе координат (каком базисе) они выражены. При этом верно и то, что вектор существует в пространстве вне зависимости от системы координат или базиса.

Смена базиса

Предположим, что у нас есть два вектора исходного стандартного базиса $ mathbf g_1 $ и $ mathbf g_2 $ (на рисунке ниже изображены зеленым цветом). Кроме этого, у нас есть вектор $mathbf r$ (красный). Эти векторы имеют следующие координаты

$$ mathbf g_1 = begin{bmatrix} 1 \ 0 end{bmatrix}, mathbf g_2 = begin{bmatrix} 0 \ 1 end{bmatrix}, mathbf r_g = begin{bmatrix} 3 \ 4 end{bmatrix} $$

Если векторы нового базиса ортогональны (это важно), то мы можем выразить координаты вектора $mathbf r$ в новом базисе. Новым базисом будут следующие векторы $ mathbf b_1 $ и $ mathbf b_2 $ (черные):

$$ mathbf b_1 = begin{bmatrix} 2 \ 1 end{bmatrix}, mathbf b_2 = begin{bmatrix} -2 \ 4 end{bmatrix} $$

Посмотрим на эти векторы на графике.

|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 |

g1 = np.array([1, 0]) g2 = np.array([0, 1]) r = np.array([3, 4]) b1 = np.array([2, 1]) b2 = np.array([—2, 4]) ax = plt.axes() plt.xlim([—2.5, 4.5]) plt.ylim([—0.07, 4.5]) plt.grid() ax.arrow(0, 0, g1[0], g1[1], width = 0.02, head_width = 0.1, head_length = 0.2, length_includes_head = True, fc = ‘g’, ec = ‘g’) ax.arrow(0, 0, g2[0], g2[1], width = 0.02, head_width = 0.1, head_length = 0.2, length_includes_head = True, fc = ‘g’, ec = ‘g’) ax.arrow(0, 0, r[0], r[1], width = 0.02, head_width = 0.1, head_length = 0.2, length_includes_head = True, fc = ‘r’, ec = ‘r’) ax.arrow(0, 0, b1[0], b1[1], width = 0.02, head_width = 0.1, head_length = 0.2, length_includes_head = True, fc = ‘k’, ec = ‘k’) ax.arrow(0, 0, b2[0], b2[1], width = 0.02, head_width = 0.1, head_length = 0.2, length_includes_head = True, fc = ‘k’, ec = ‘k’) plt.show() |

Убедимся, что векторы нового базиса $ mathbf b_1 $ и $ mathbf b_2 $ перпендикулярны (ортогональны).

Найдем скалярные и векторные проекции красного вектора $ mathbf r $ на векторы $ mathbf b_1 $ и $ mathbf b_2 $.

|

scalar_proj_r_on_b1 = np.dot(r, b1) / np.linalg.norm(b1) vector_proj_r_on_b1 = scalar_proj_r_on_b1 * (b1 / np.linalg.norm(b1)) scalar_proj_r_on_b1.round(1), vector_proj_r_on_b1 |

|

scalar_proj_r_on_b2 = np.dot(r, b2) / np.linalg.norm(b2) ** 2 vector_proj_r_on_b2 = scalar_proj_r_on_b2 * b2 scalar_proj_r_on_b2.round(1), vector_proj_r_on_b2 |

Посмотрим на векторные проекции.

|

plt.figure(figsize = (6, 6)) ax = plt.axes() plt.xlim([—2, 4.5]) plt.ylim([—0.07, 4.5]) plt.grid() ax.arrow(0, 0, r[0], r[1], width = 0.02, head_width = 0.1, head_length = 0.2, length_includes_head = True, fc = ‘r’, ec = ‘r’) ax.arrow(0, 0, vector_proj_r_on_b1[0], vector_proj_r_on_b1[1], width = 0.02, head_width = 0.1, head_length = 0.2, length_includes_head = True, fc = ‘k’, ec = ‘k’) ax.arrow(0, 0, vector_proj_r_on_b2[0], vector_proj_r_on_b2[1], width = 0.02, head_width = 0.1, head_length = 0.2, length_includes_head = True, fc = ‘k’, ec = ‘k’) plt.show() |

В сумме векторные проекции должны дать вектор $ mathbf r_g $ в исходном базисе.

|

vector_proj_r_on_b1 + vector_proj_r_on_b2 |

В новом же базисе вектор $ mathbf r_b $ можно выразить, как скалярные проекции вектора $ mathbf r $ на векторы нового базиса $ mathbf b_1 $ и $ mathbf b_2 $.

|

np.array([scalar_proj_r_on_b1, scalar_proj_r_on_b2]).round(1) |

Другими словами,

$$ mathbf r_b approx begin{bmatrix} 4,5 \ 2,2 end{bmatrix} $$

Ортонормированный базис

Если угол между векторами базиса равен 90 градусов, то такой базис называют ортогональным (orthogonal). Если одновременно это единичные (нормализованные) векторы, то такой базис называется ортонормированным (orthonormal).

Ортонормированный базис называют стандартным базисом пространства $R^n$.

$$ forall { mathbf q_1, …, mathbf q_k } in R^n $$

$$ mathbf q_i^T cdot mathbf q_j = begin{cases} 0, i not= j \ 1, i=j end{cases} $$

Хотя векторы базиса не обязательно должны быть ортогональными и иметь единичную норму, во многих случаях это удобно.

Видео про линейную оболочку⧉.

Подведем итог

Мы ввели понятие векторного пространства, подпространства, линейной комбинации векторов, понятия базиса, линейной независимости векторов и линейной оболочки.

Перейдем к изучению матриц и начнем этот путь с рассмотрения линейных преобразований.

![{displaystyle L^{2}([0,1]),}](https://wikimedia.org/api/rest_v1/media/math/render/svg/6da2a14151b01996b4df887f1ca1f3e8a044ab5c)