Содержание:

Точечные оценки:

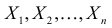

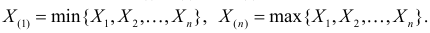

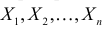

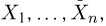

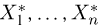

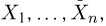

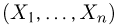

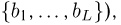

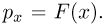

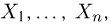

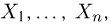

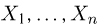

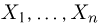

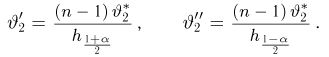

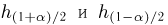

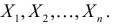

Пусть случайная величина имеет неизвестную характеристику а. Такой характеристикой может быть, например, закон распределения, математическое ожидание, дисперсия, параметр закона распределения, вероятность определенного значения случайной величины и т.д. Пронаблюдаем случайную величину n раз и получим выборку из ее возможных значений

Существует два подхода к решению этой задачи. Можно по результатам наблюдений вычислить приближенное значение характеристики, а можно указать целый интервал ее значений, согласующихся с опытными данными. В первом случае говорят о точечной оценке, во втором – об интервальной.

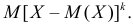

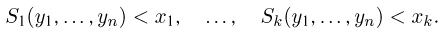

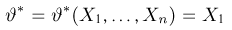

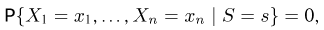

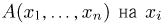

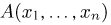

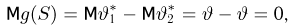

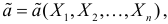

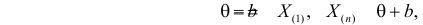

Определение. Функция результатов наблюдений

Для одной и той же характеристики можно предложить разные точечные оценки. Необходимо иметь критерии сравнения оценок, для суждения об их качестве. Оценка

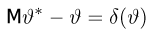

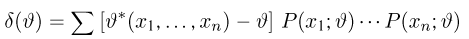

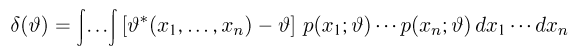

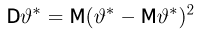

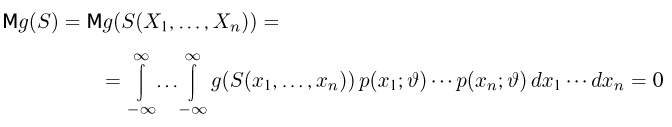

Определение. Оценка называется несмещенной, если ее математическое ожидание равно оцениваемой величине:

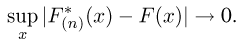

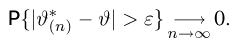

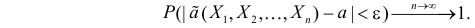

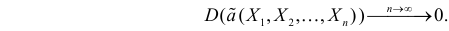

Определение. Оценка называется состоятельной, если при увеличении числа наблюдений она сходится по вероятности к оцениваемой величине, т.е. для любого сколь угодно малого

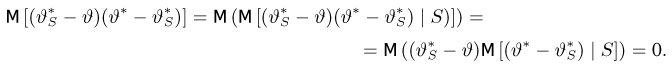

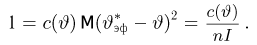

Если известно, что оценка

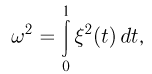

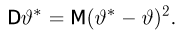

Последнее условие удобно для проверки. В качестве меры разброса значений оценки

Следует отметить, что несмещенность и состоятельность являются желательными свойствами оценок, но не всегда разумно требовать наличия этих свойств у оценки. Например, может оказаться предпочтительней оценка хотя и обладающая небольшим смещением, но имеющая значительно меньший разброс значений, нежели несмещенная оценка. Более того, есть характеристики, для которых нет одновременно несмещенных и состоятельных оценок.

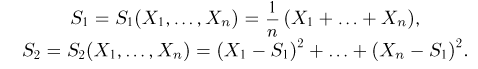

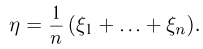

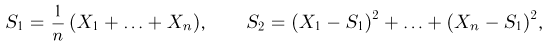

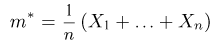

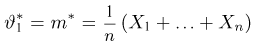

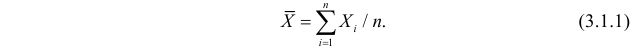

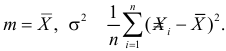

Оценки для математического ожидания и дисперсии

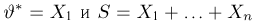

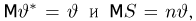

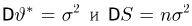

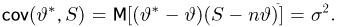

Пусть случайная величина имеет неизвестные математическое ожидание и дисперсию, причем

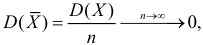

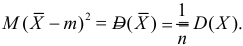

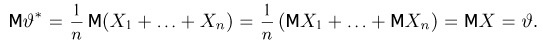

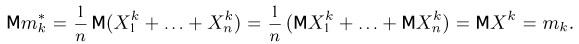

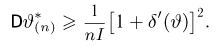

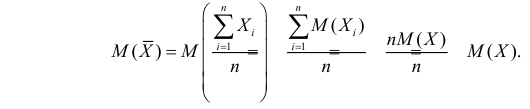

Несмещенность такой оценки следует из равенств

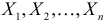

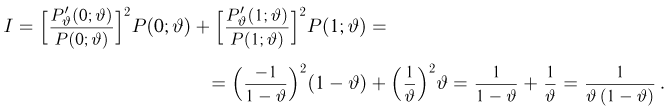

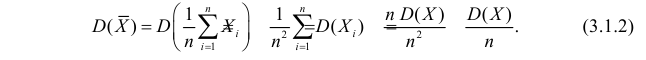

В силу независимости наблюдений

При условии

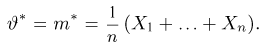

Доказано, что для математического ожидания нормально распределенной случайной величины оценка

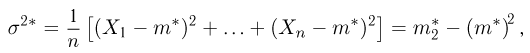

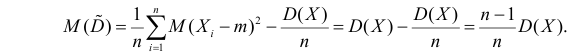

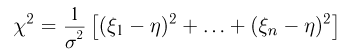

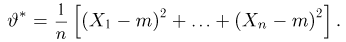

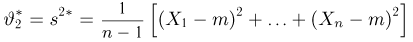

Оценка математического ожидания посредством среднего арифметического наблюдаемых значений наводит на мысль предложить в качестве оценки для дисперсии величину

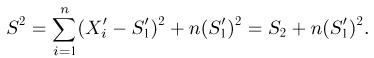

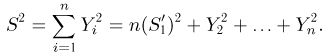

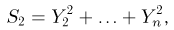

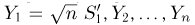

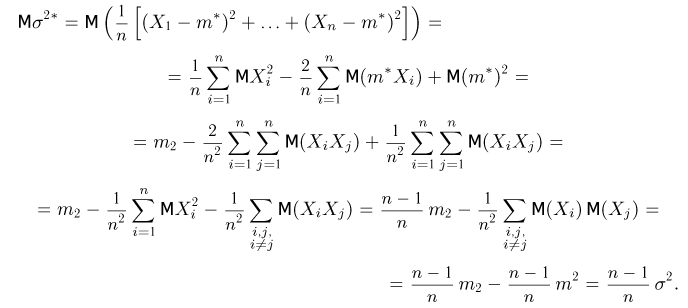

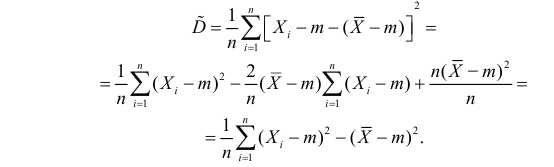

Преобразуем величину

В силу (3.1.2) имеем

Последняя запись означает, что оценка

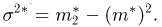

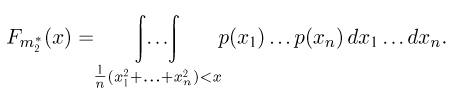

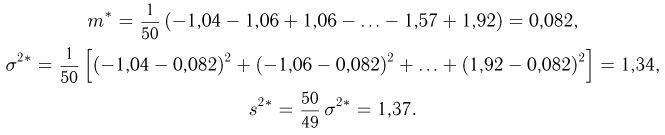

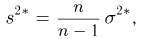

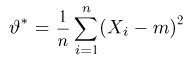

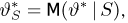

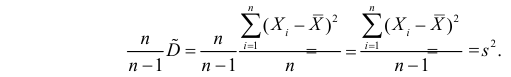

Величина

является несмещенной и состоятельной оценкой дисперсии.

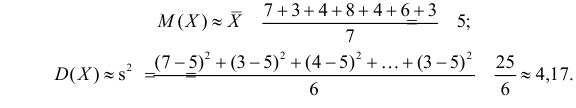

Пример:

Оценить математическое ожидание и дисперсию случайной величины Х по результатам ее независимых наблюдений: 7, 3, 4, 8, 4, 6, 3.

Решение. По формулам (3.1.1) и (3.1.3) имеем

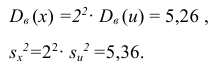

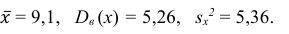

Ответ.

Пример:

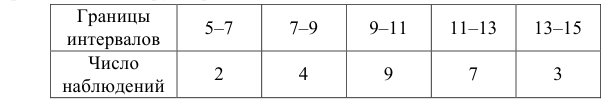

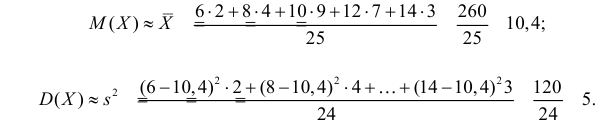

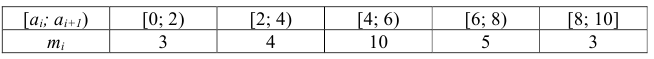

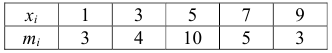

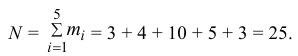

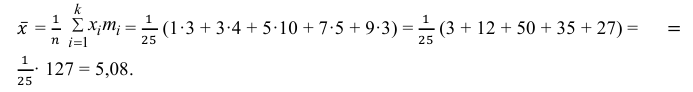

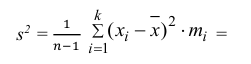

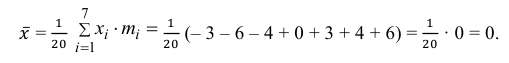

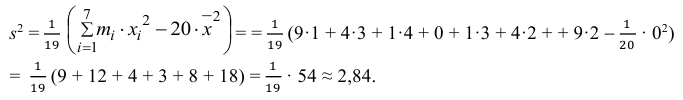

Данные 25 независимых наблюдений случайной величины представлены в сгруппированном виде:

Требуется оценить математическое ожидание и дисперсию этой случайной величины.

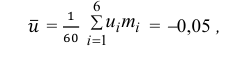

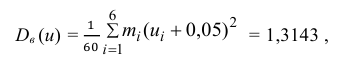

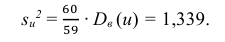

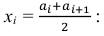

Решение. Представителем каждого интервала можно считать его середину. С учетом этого формулы (3.1.1) и (3.1.3) дают следующие оценки:

Ответ.

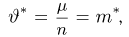

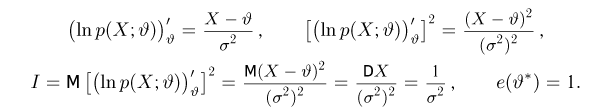

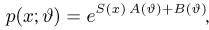

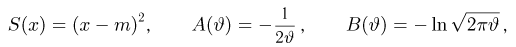

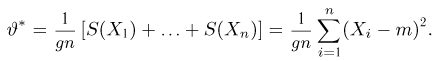

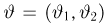

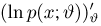

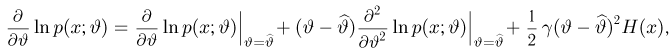

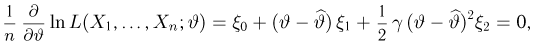

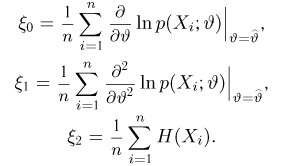

Метод наибольшего правдоподобия для оценки параметров распределений

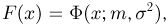

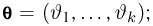

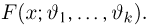

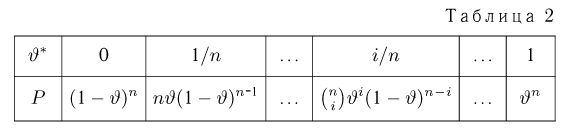

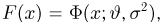

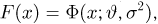

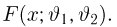

В теории вероятностей и ее приложениях часто приходится иметь дело с законами распределения, которые определяются некоторыми параметрами. В качестве примера можно назвать нормальный закон распределения

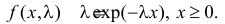

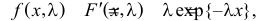

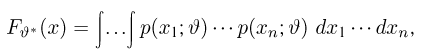

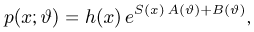

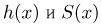

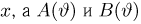

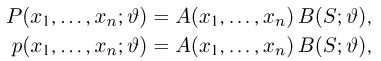

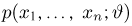

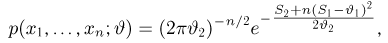

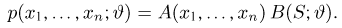

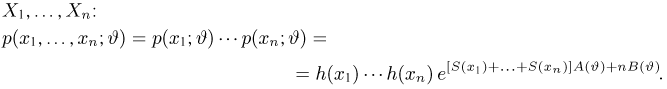

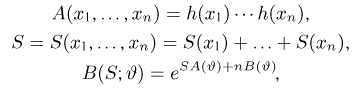

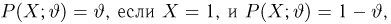

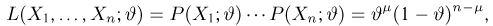

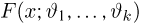

Пусть случайная величина Х имеет функцию распределения

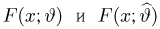

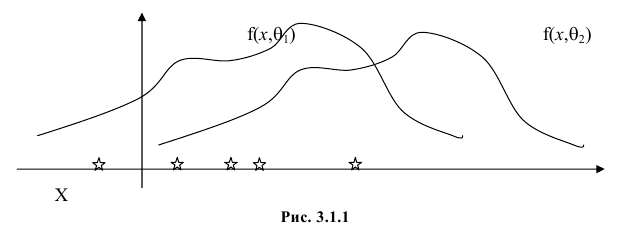

Продемонстрируем идею метода наибольшего правдоподобия на упрощенном примере. Пусть по результатам наблюдений, отмеченных на рис. 3.1.1 звездочками, нужно отдать предпочтение одной из двух функций плотности вероятности

Из рисунка видно, что при значении параметра

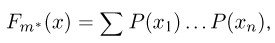

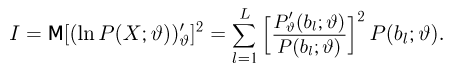

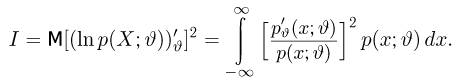

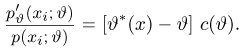

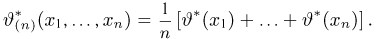

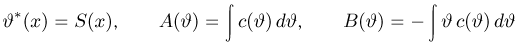

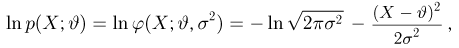

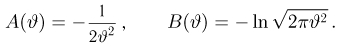

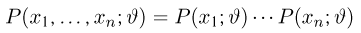

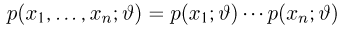

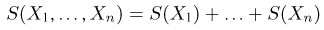

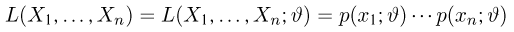

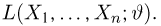

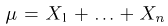

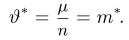

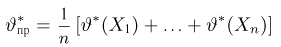

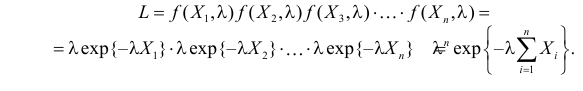

Этот принцип приводит к следующему способу действий. Пусть закон распределения случайной величины Х зависит от неизвестного значения параметра

называют функцией правдоподобия. Величина

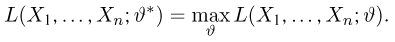

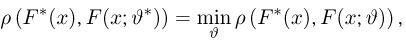

Сформулированный принцип предлагает в качестве оценки значения параметра выбрать такое

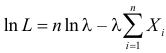

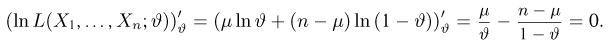

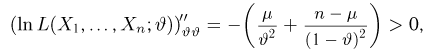

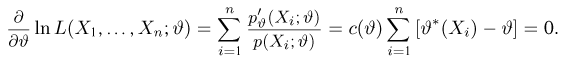

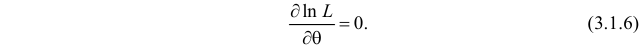

Во многих случаях, когда

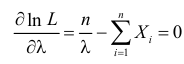

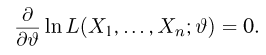

которое следует из необходимого условия экстремума. Поскольку

Это уравнение называют уравнением правдоподобия. Им пользоваться удобнее, чем уравнением (3.1.5), так как функция

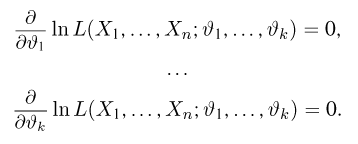

Если параметров несколько (многомерный параметр), то следует взять частные производные от функции правдоподобия по всем параметрам, приравнять частные производные нулю и решить полученную систему уравнений.

Оценку, получаемую в результате поиска максимума функции правдоподобия, называют еще оценкой максимального правдоподобия.

Известно, что оценки максимального правдоподобия состоятельны. Кроме того, если для q существует эффективная оценка, то уравнение правдоподобия имеет единственное решение, совпадающее с этой оценкой. Оценка максимального правдоподобия может оказаться смещенной.

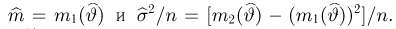

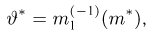

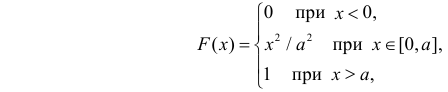

Метод моментов

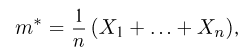

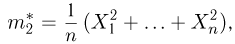

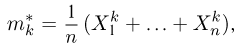

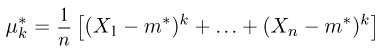

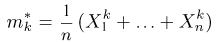

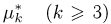

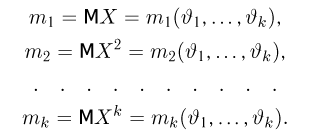

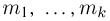

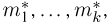

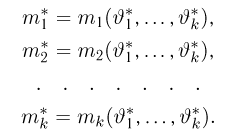

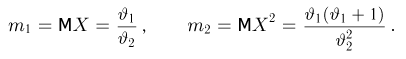

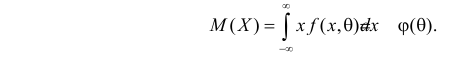

Начальным моментом

Центральным моментом

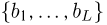

Для оценки параметров распределения по методу моментов находят на основе опытных данных оценки моментов в количестве, равном числу оцениваемых параметров. Эти оценки приравнивают к соответствующим теоретическим моментам, величины которых выражены через параметры. Из полученной системы уравнений можно определить искомые оценки.

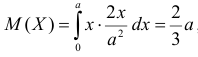

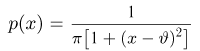

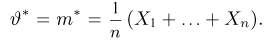

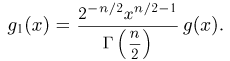

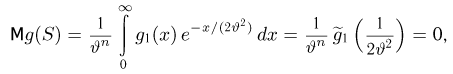

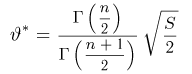

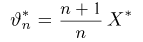

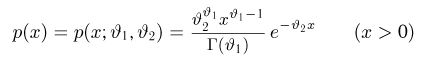

Например, если Х имеет плотность распределения

Если воспользоваться величиной

Пример:

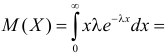

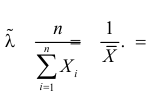

Найти оценку параметра показательного закона распределения по методу моментов.

Решение. Плотность вероятности показательного закона распределения имеет вид

Ответ.

Пример:

Пусть имеется простейший поток событий неизвестной интенсивности

Решение. В простейшем потоке интервалы времени между последовательными моментами наступления событий потока имеют показательный закон распределения

Тогда

При таком значении

Ответ.

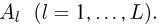

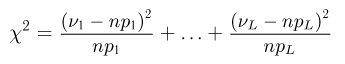

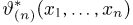

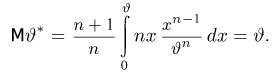

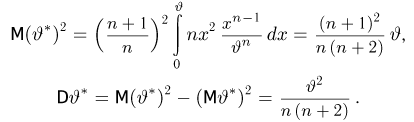

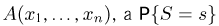

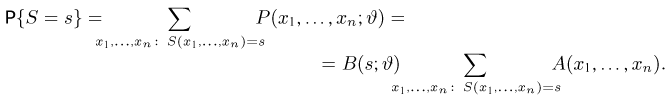

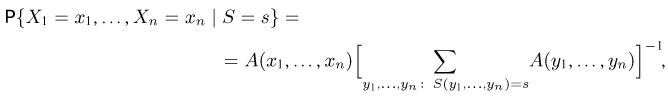

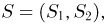

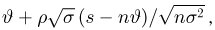

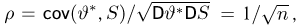

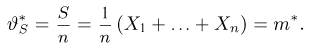

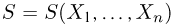

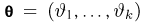

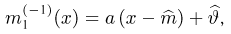

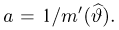

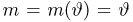

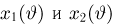

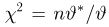

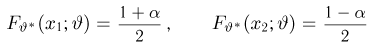

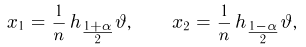

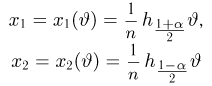

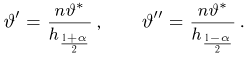

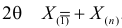

Определение. Пусть

В этой записи

Величины

Пример:

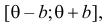

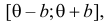

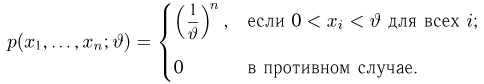

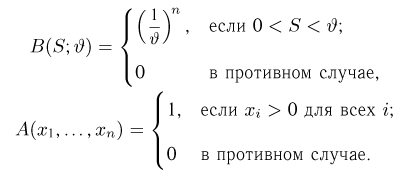

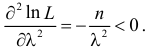

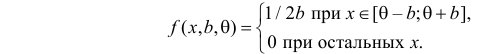

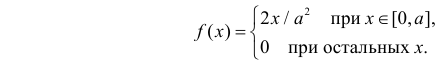

Случайная величина Х имеет равномерное распределение на отрезке

Решение. Функция плотности вероятности величины Х имеет вид

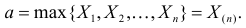

В этом случае функция правдоподобия

где

откуда

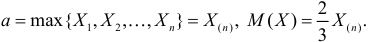

Оценкой наибольшего правдоподобия для параметра

Ответ.

Пример:

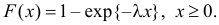

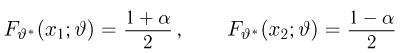

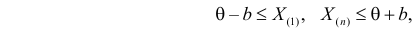

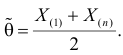

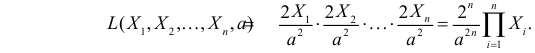

Случайная величина X имеет функцию распределения

где

Пусть

Решение. Для построения функции правдоподобия найдем сначала функцию плотности вероятности

Тогда функция правдоподобия:

Логарифмическая функция правдоподобия:

Уравнение правдоподобия

не имеет решений. Критических точек нет. Наибольшее и наименьшее значения

По виду функции

Так как

Ответ.

Пример:

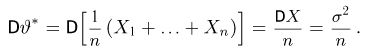

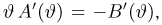

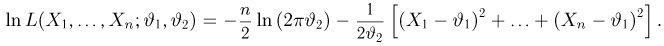

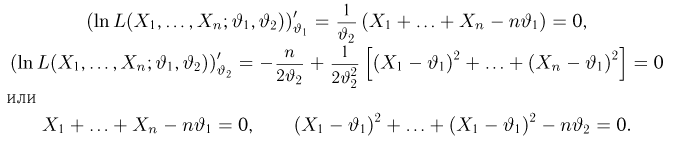

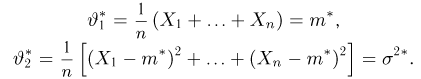

Случайная величина Х имеет нормальный закон распределения

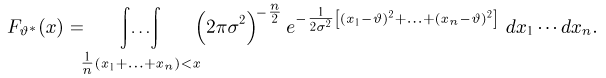

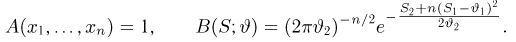

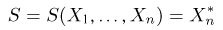

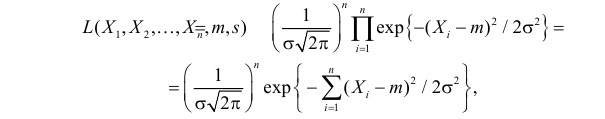

Решение. В соответствии с (3.1.4) функция правдоподобия имеет вид

а логарифмическая функция правдоподобия:

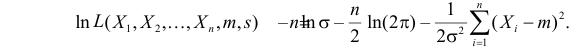

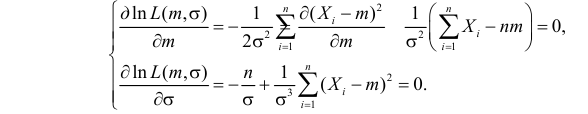

Необходимые условия экстремума дают систему двух уравнений:

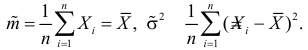

Решения этой системы имеют вид:

Отметим, что обе оценки являются состоятельными, причем оценка для

Ответ.

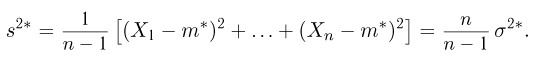

Пример:

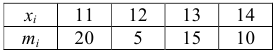

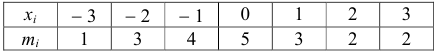

По данным эксперимента построен статистический ряд:

Найти оценки математического ожидания, дисперсии и среднего квадратического отклонения случайной величины X.

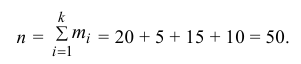

Решение. 1) Число экспериментальных данных вычисляется по формуле:

Значит, объем выборки n = 50.

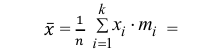

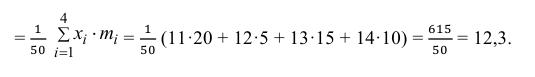

2) Вычислим среднее арифметическое значение эксперимента:

Значит, найдена оценка математического ожидания

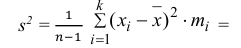

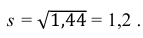

3) Вычислим исправленную выборочную дисперсию:

Значит, найдена оценка дисперсии:

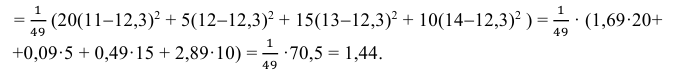

5) Вычислим оценку среднего квадратического отклонения:

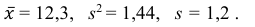

Ответ:

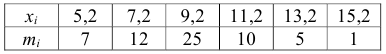

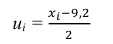

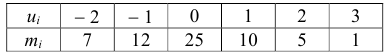

Пример:

По данным эксперимента построен статистический ряд:

Найти оценки математического ожидания, дисперсии и среднего квадратического отклонения случайной величины X.

Решение. По формуле

перейдем к условным вариантам:

Для них произведем расчет точечных оценок параметров:

Следовательно, вычисляем искомые точечные оценки:

Ответ:

Пример:

По данным эксперимента построен интервальный статистический ряд:

Найти оценки математического ожидания, дисперсии и среднего квадратического отклонения.

Решение. 1) От интервального ряда перейдем к статистическому ряду, заменив интервалы их серединами

2) Объем выборки вычислим по формуле:

3) Вычислим среднее арифметическое значений эксперимента:

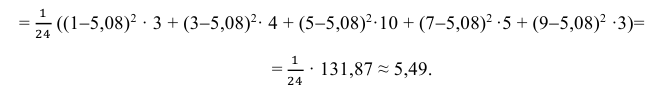

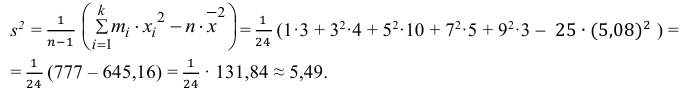

3) Вычислим исправленную выборочную дисперсию:

Можно было воспользоваться следующей формулой:

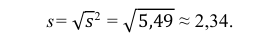

5) Вычислим оценку среднего квадратического отклонения:

Ответ:

Пример:

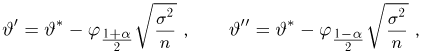

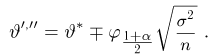

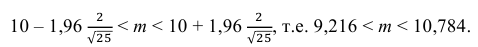

Найти доверительный интервал с надежностью 0,95 для оценки математического ожидания M(X) нормально распределенной случайной величины X, если известно среднее квадратическое отклонение σ = 2, оценка математического ожидания

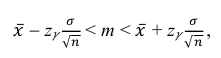

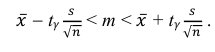

Решение. Доверительный интервал для истинного математического ожидания с доверительной вероятностью

где m = M(X) – истинное математическое ожидание; 𝑥̅ − оценка M(X) по выборке; n – объем выборки;

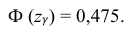

Из табл. П 2.2 приложения 2 находим:

Ответ: (9,216 ; 10,784).

Пример:

По данным эксперимента построен статистический ряд:

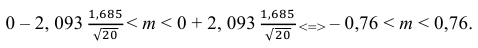

Найти доверительный интервал для математического ожидания M (X) с надежностью 0,95.

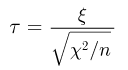

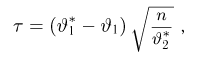

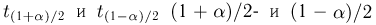

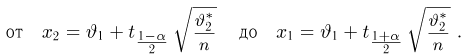

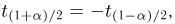

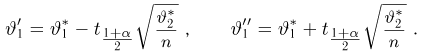

Решение. Воспользуемся формулой для доверительного интервала математического ожидания при неизвестной дисперсии:

где n – объем выборки; 𝑥̅ оценка M(X); s – оценка среднего квадратического отклонения;

По числам

Теперь вычисляем оценки для M(X) и D(X):

Следовательно, s ≈ 1,685. Поэтому искомый доверительный интервал математического ожидания задается формулой:

Ответ: (– 0,76; 0,76).

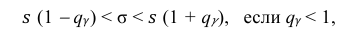

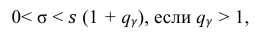

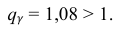

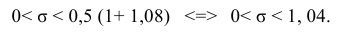

Пример:

По данным десяти независимых измерений найдена оценка квадратического отклонения

Решение. Задача сводится к нахождению доверительного интервала для истинного квадратического отклонения, так как точность прибора характеризуется средним квадратическим отклонением случайных ошибок измерений.

Доверительный интервал для среднего квадратического отклонения находим по формуле:

где

Находим:

Тогда можно записать:

Ответ: (0; 1,04).

- Доверительный интервал для вероятности события

- Проверка гипотезы о равенстве вероятностей

- Доверительный интервал для математического ожидания

- Доверительный интервал для дисперсии

- Системы случайных величин

- Вероятность и риск

- Определения вероятности событий

- Предельные теоремы теории вероятностей

Мы уже упоминали, что оценивать вероятности классов как $softmax(f_w(x_i))$ для какой-то произвольной функции $f_w$ – это дело подозрительное. В этом разделе мы поговорим о том, как это делать хорошо и правильно.

Что же такое вероятность класса, если объект либо принадлежит этому классу, либо нет?

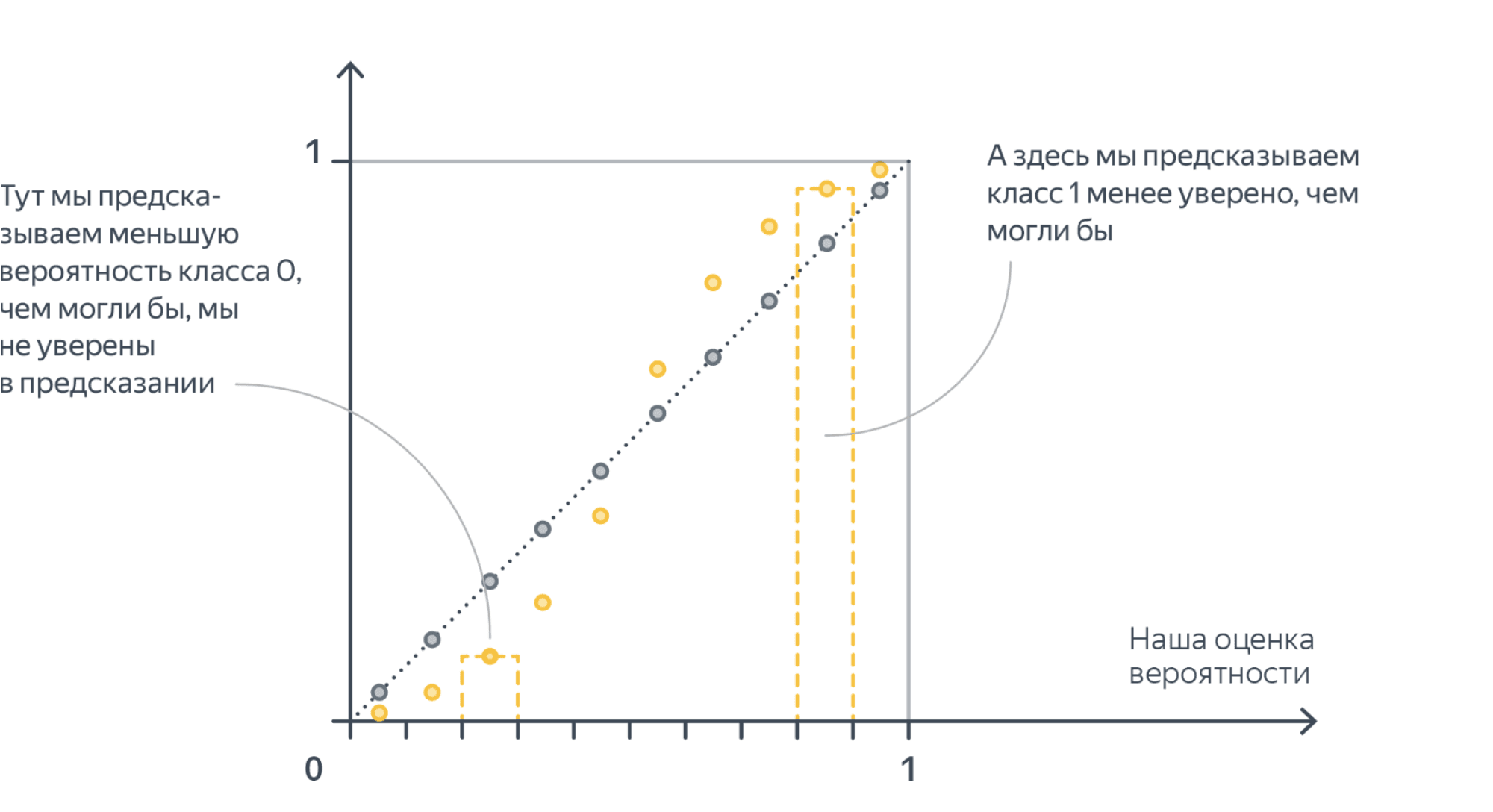

Ограничимся пока случаем двуклассовой классификации с классами 0 и 1. Пожалуй, если утверждается, что мы предсказываем корректную вероятность класса 1 (обозначим её $q(x_i)$), то прогноз «объект $x_i$ принадлежит классу 1 с вероятностью $frac23$» должен сбываться в $frac23$ случаев. То есть, условно говоря, если мы возьмём все объекты, которым мы предсказали вероятностью $frac23$, то среди них что-то около двух третей действительно имеет класс 1. На математическом языке это можно сформулировать так: Если $widehat{p}$ – предсказанная вероятность класса 1, то $P(y_i = 1 vert q(x_i) = widehat{p}) = widehat{p}$.

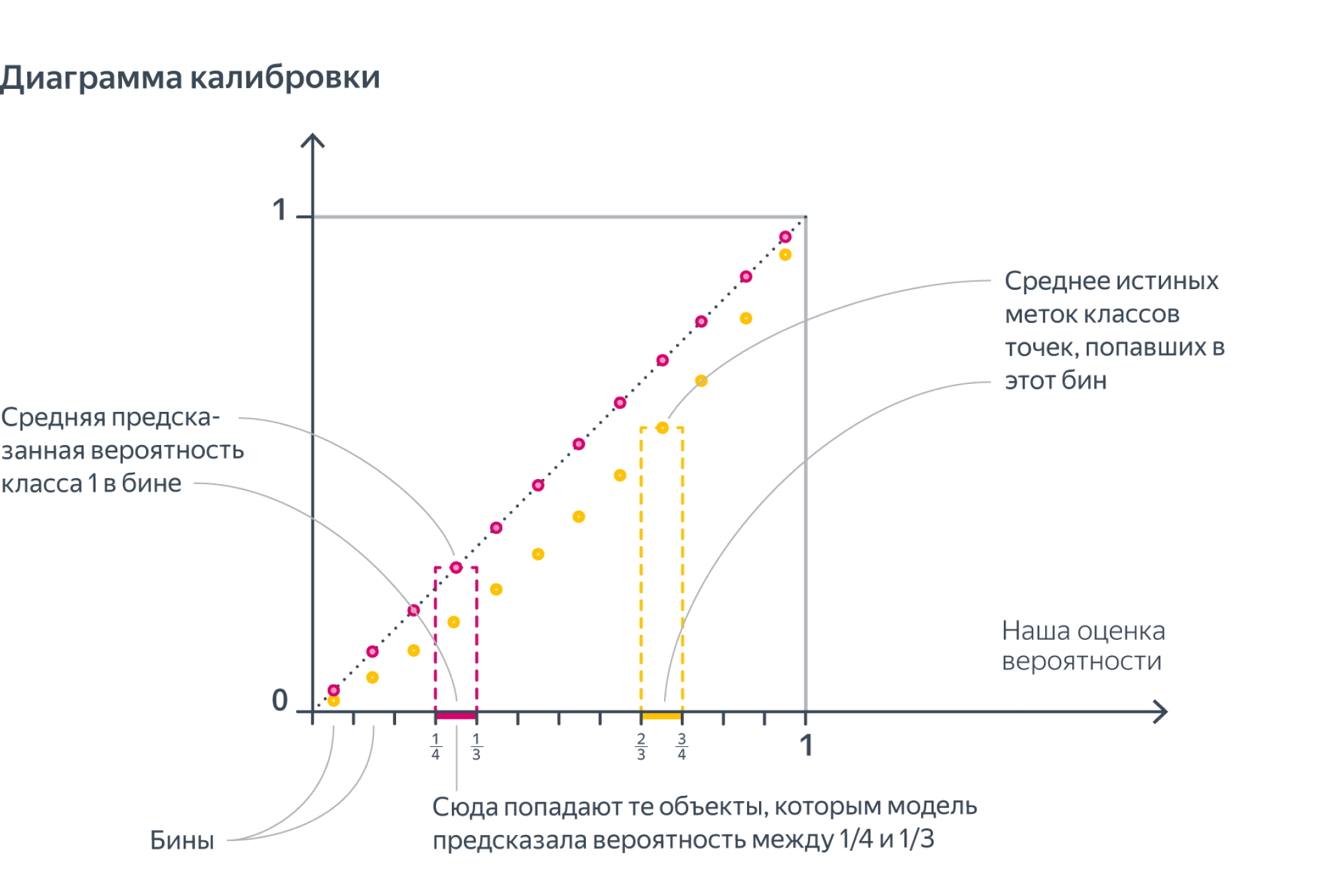

К сожалению, в реальной жизни $widehat{p}$ – это скорее всего вещественные числа, которые будут различными для различных $y_i$, и никаких вероятностей мы не посчитаем, но мы можем разбить отрезок $[0,1]$ на бины, внутри каждого из которых уже вычислить, каковая там доля объектов класса 1, и сравнить эту долю со средним значением вероятности в бине:

У модели, которая идеально предсказывает вероятности (как обычно говорят, у идеально калиброванной модели) жёлтые точки на диаграме калибровки должны совпадать с розовыми.

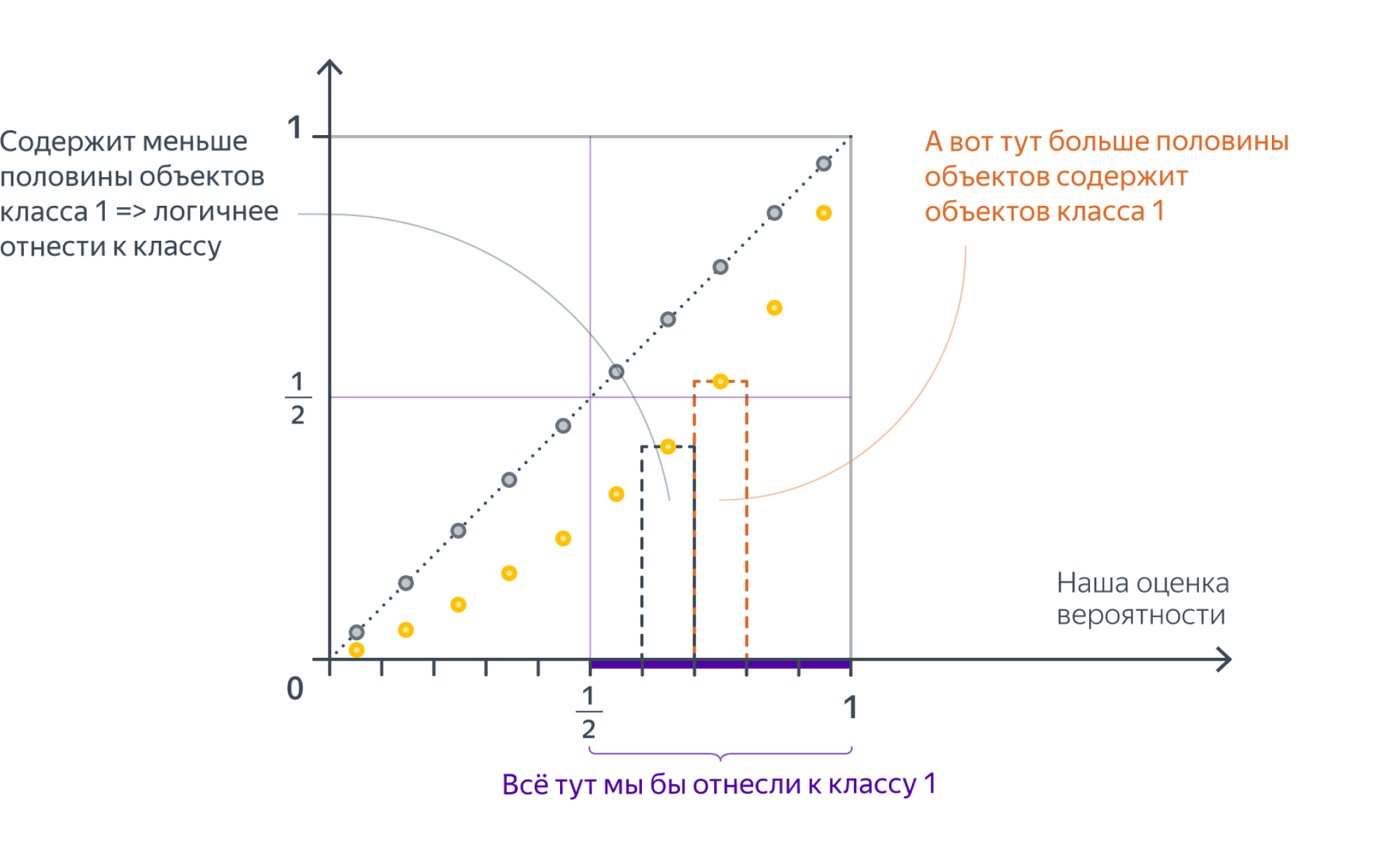

А вот на картинке выше это не так: жёлтые точки всегда ниже розовых. Давайте поймём, что это значит. Получается, что наша модель систематически завышает предсказанную вероятность (розовые точки), и порог отсечения нам, выходит, тоже надо было бы сдвинуть вправо:

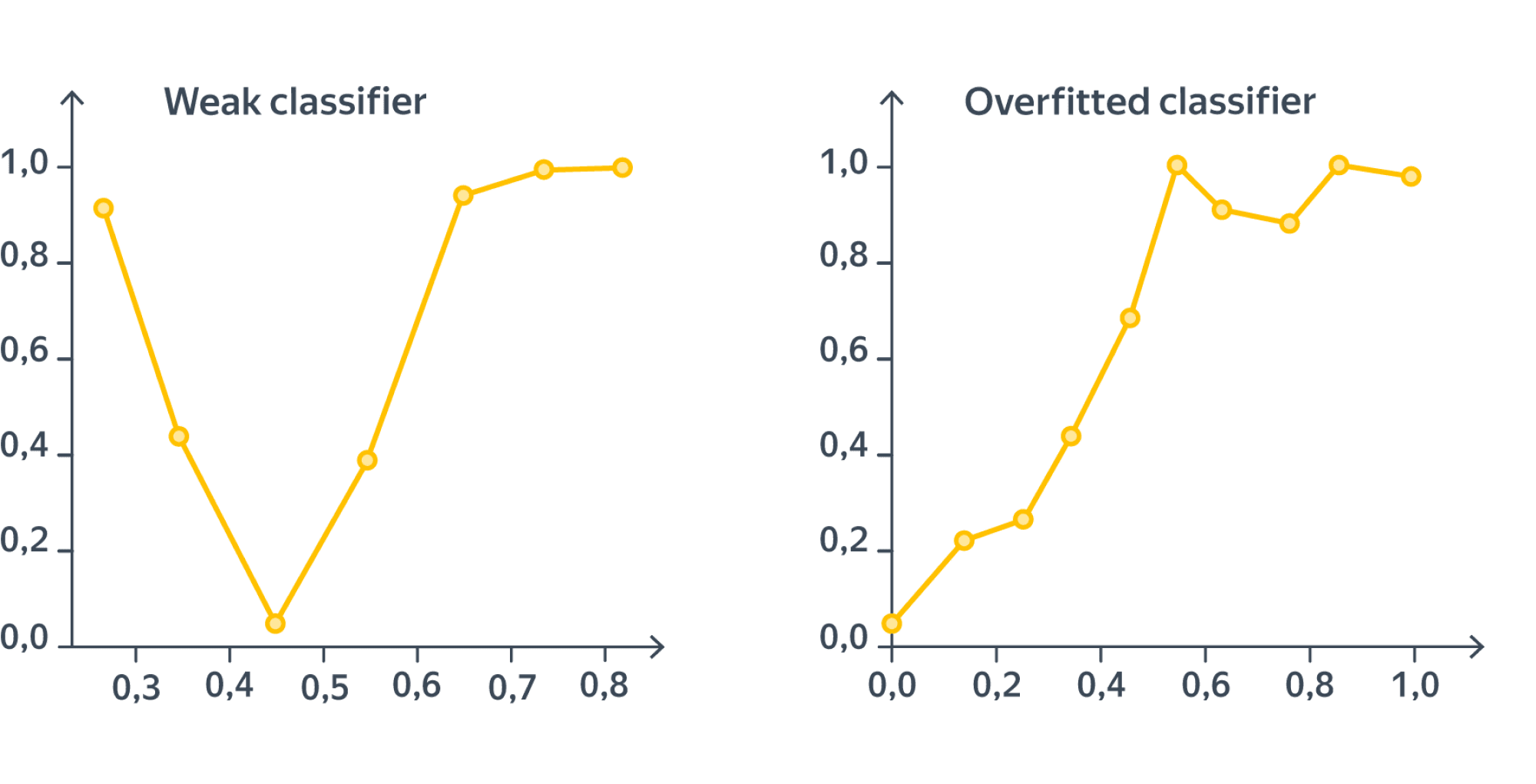

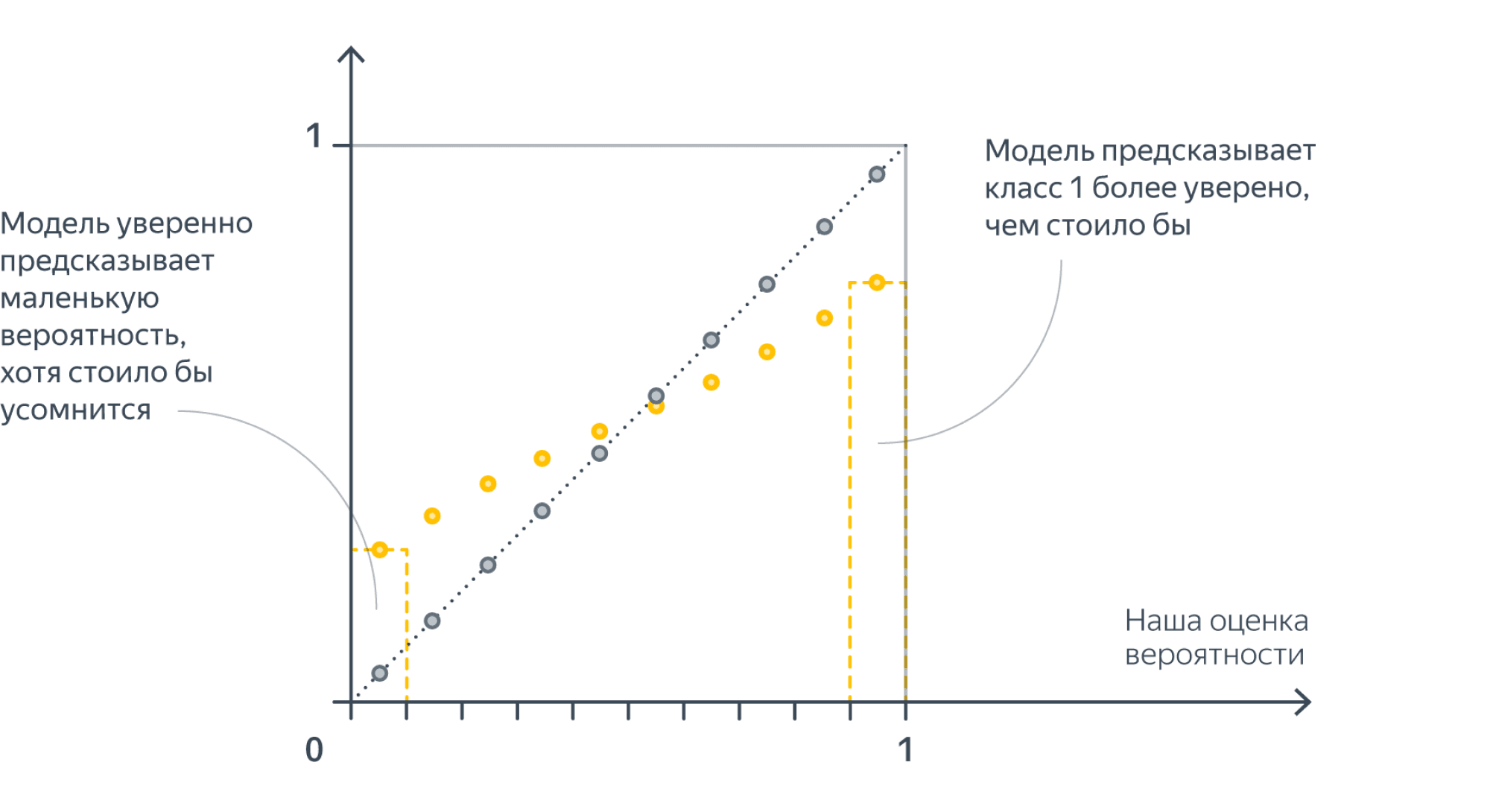

Но такая картинка, пожалуй, говорит о какой-то серьёзной патологии классификатора; гораздо чаще встречаются следующие две ситуации:

-

Слишком уверенный (overconfident) классификатор:

Такое случается с сильными классификаторыми (например, нейросетями), которые учились на метки классов, а не на вероятности: тем самым процесс обучения стимулировал их всегда давать как можно более близкий к 0 или 1 ответ.

-

Неуверенный (underconfident) классификатор:

Такое может случиться, например, если мы слишком много обращаем внимания на трудные для классификации объекты на границе классов (как, скажем, в SVM), в каком-то смысле в ущерб более однозначно определяемым точкам. Этим же могут и грешить модели на основе бэггинга (например, случайный лес). Грубо говоря, среднее нескольких моделей предскажет что-то близкое к единице только если все слагаемые предскажут что-то, близкое к единице – но из-за дисперсии моделей это будет случаться реже, чем могло бы. См. статью.

Вам скажут: логистическая регрессия корректно действительно предсказывает вероятности

Вам даже будут приводить какие-то обоснования. Важно понимать, что происходит на самом деле, и не дать ввести себя в заблуждение. В качестве противоядия от иллюзий предлагаем рассмотреть два примера.

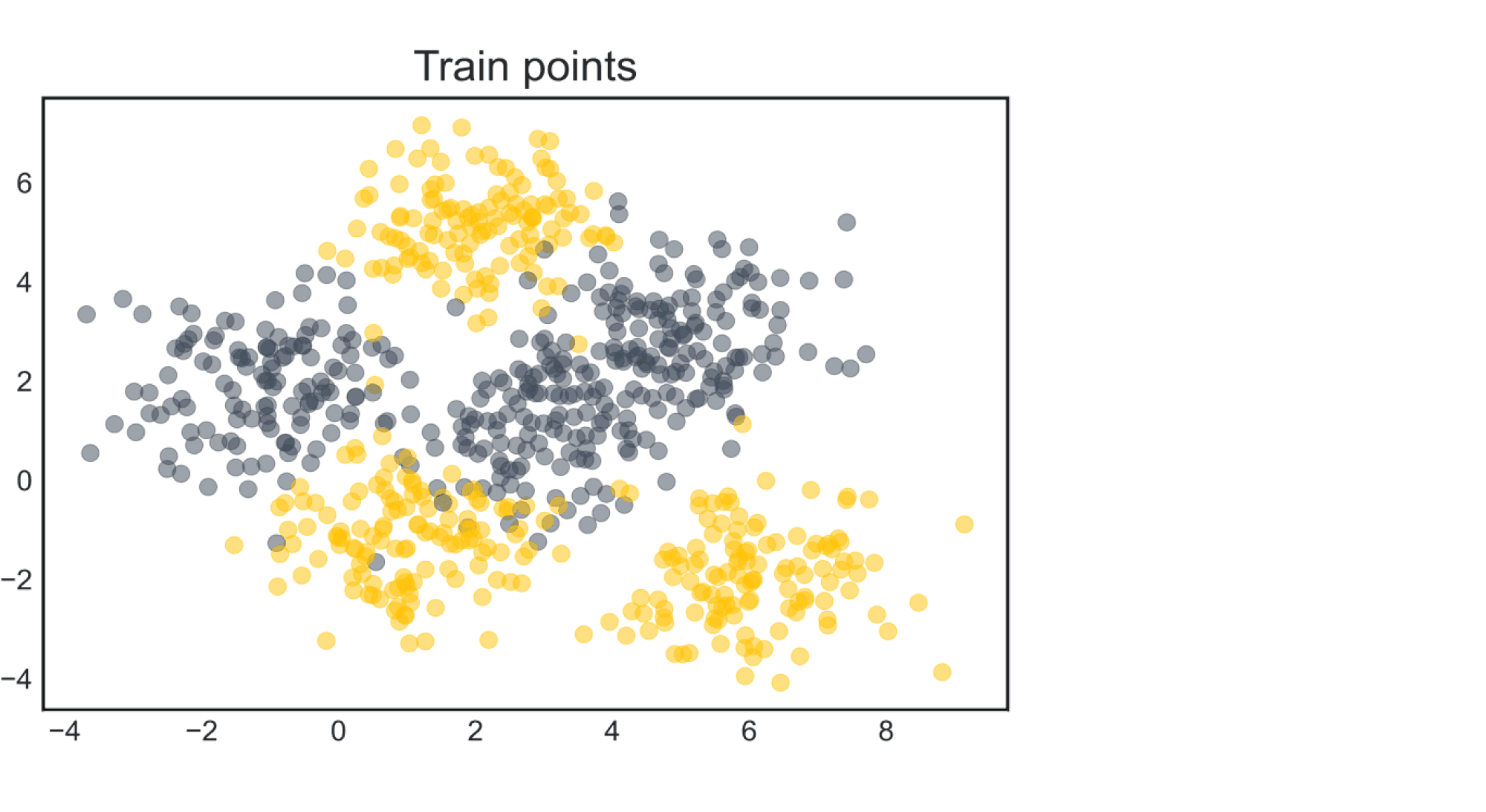

- Рассмотрим датасет c двумя классами (ниже на картинке обучающая выборка)

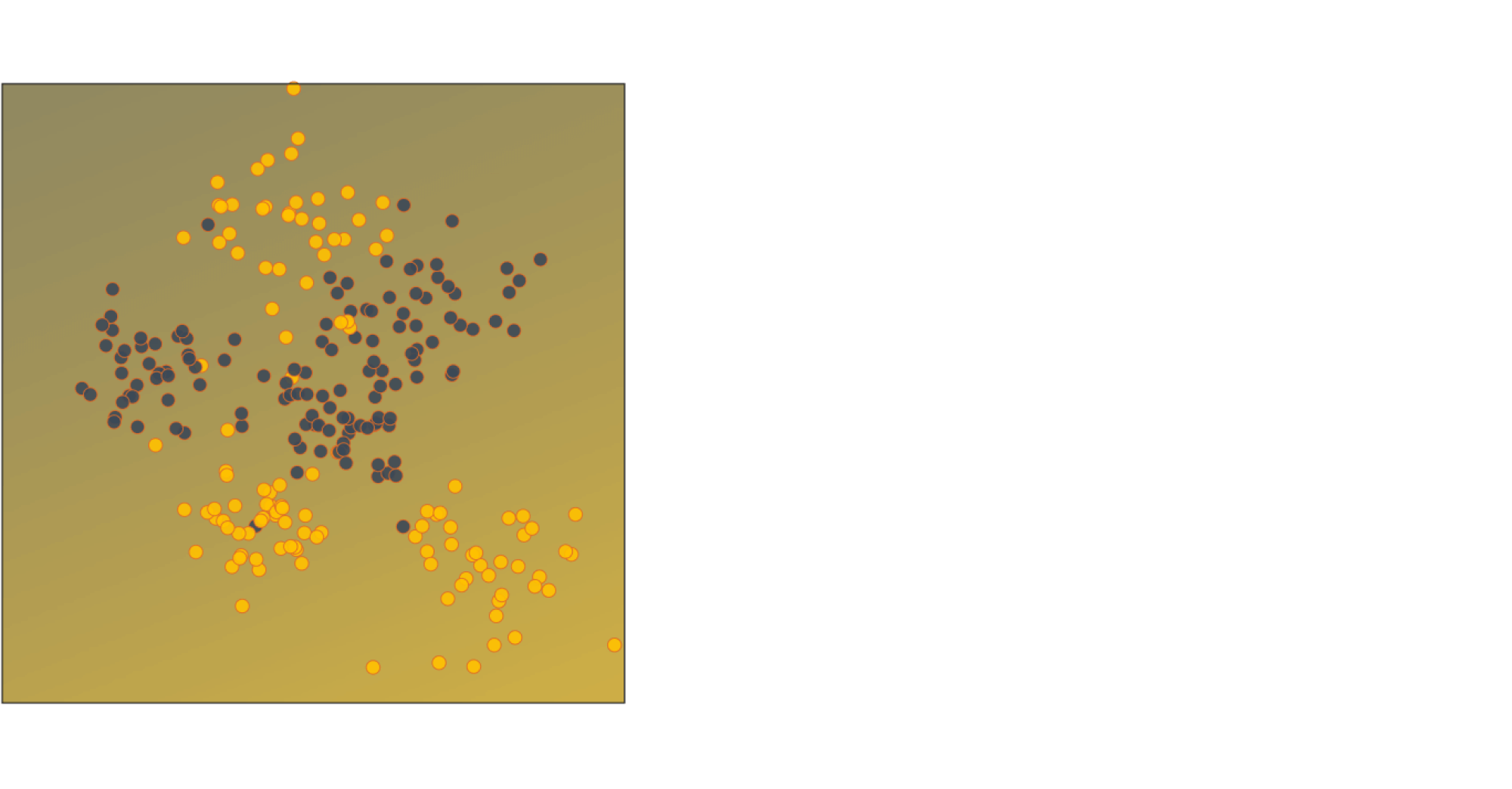

Обучим на нём логистическую регрессию из sklearn безо всяких параметров (то есть $L^2$-регуляризованную, но это не так важно). Классы не так-то просто разделить, вот и логистическая регрессия так себе справляется. Ниже изображена часть тестовой выборки вместе с предсказанными вероятностями классов для всех точек области

Видим, что модель не больно-то уверена в себе, и ясно почему: признаковое описание достаточно бедное и не позволяет нам хорошо разделить классы, хотя, казалось бы, это можно довольно неплохо сделать.

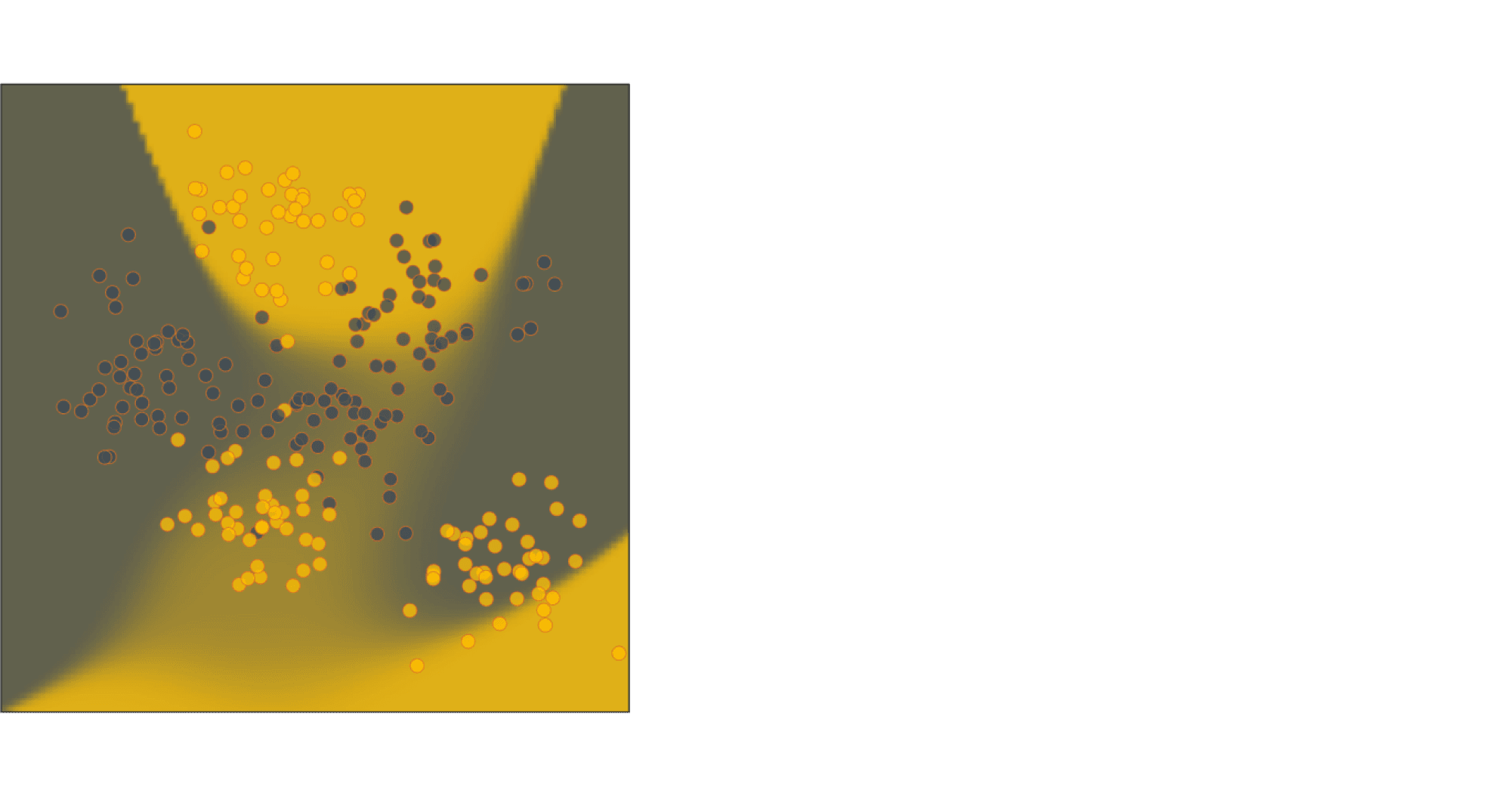

- Попробуем поправить дело, добавив полиномиальные фичи, то есть все $x^jy^k$ для $0leqslant j,kleqslant 5$ в качестве признаков, и обучив поверх этих данных логистическую регрессию. Снова нарисуем некоторые точки тестовой выборки и предсказания вероятностей для всех точек области:

Видим, что имеет место сочетание двух проблем: неуверенности посередине и очень уверенных ошибок по краям.

Нарисуем теперь калибровочные кривые для обеих моделей:

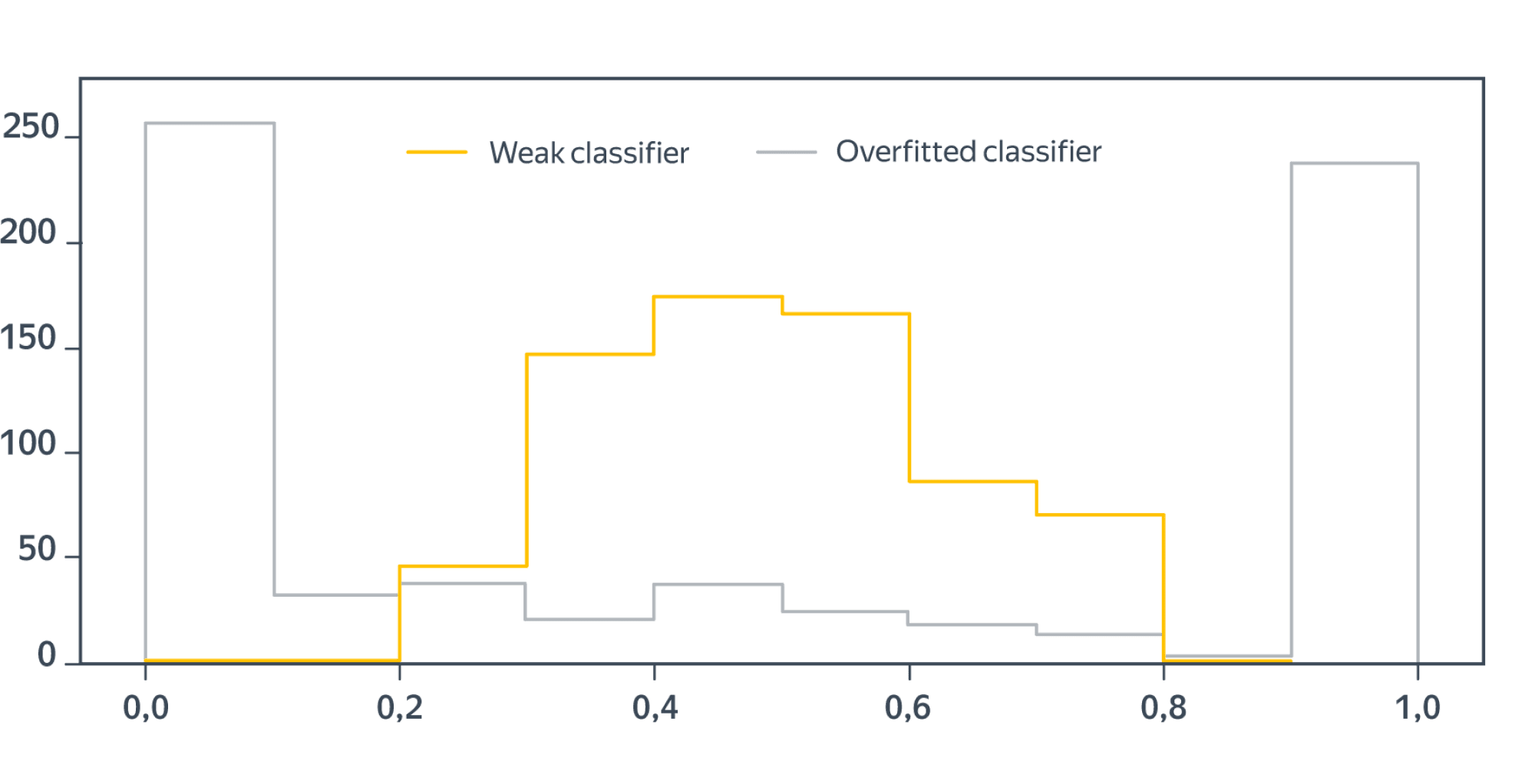

Калибровочные кривые весьма примечательны; в любом случае ясно, что с предсказанием вероятностей всё довольно плохо. Посмотрим ещё, какие вероятности наши классификаторы чаще приписывают объектам:

Как и следовало ожидать, предсказания слабого классификатора тяготеют к серединке (та самая неуверенность), а среди предсказаний переобученного очень много крайне уверенных (и совсем не всегда правильных).

Но почему же все твердят, что логистическая регрессия хорошо калибрована?!

Попробуем понять и простить её.

Как мы помним, логистическая регрессия учится путём минимизации функционала

$$l(X, y) = -sum_{i=1}^N(y_ilog(sigma(langle w, x_irangle)) + (1 — y_i)log(1 — sigma(langle w, x_irangle)))$$

Отметим между делом, что каждое слагаемое – это кроссэнтропия распределения $P$, заданного вероятностями $P(0) = 1 — sigma(langle w, x_irangle)$ и $P(1) = sigma(langle w, x_irangle)$, и тривиального распределения, которое равно $y_i$ с вероятностью $1$.

Допустим, что мы обучили по всему универсуму данных $mathbb{X}$ идеальную логистическую регрессию с идеальными весами $w^{ast}$. Пусть, далее, оказалось, что у нас есть $n$ объектов $x_1,ldots,x_n$ с одинаковым признаковым описанием (то есть по сути представленных одинаковыми векторами $x_i$), но, возможно, разными истинными метками классов $y_1,ldots,y_n$. Тогда соответствующий им кусок функции потерь имеет вид

$$-left(sum_{i=1}^ny_iright)log(sigma(langle w, x_1rangle)) -left(sum_{i=1}^n (1 — y_i)right)log(1 — sigma(langle w, x_1rangle)) =$$

$$=-nleft(vphantom{frac12}p_0log(sigma(langle w, x_1rangle)) + p_1log(1 — sigma(langle w, x_1rangle))right)$$

где $p_j$ – частота $j$-го класса среди истинных меток. В скобках также стоит кросс-энтропия распределения, задаваемого частотой меток истинных классов, и распределения, предсказываемого логистической регрессией. Минимальное значение кросс-энтропии (и минимум функции потерь) достигается, когда

$$sigma(langle w, x_1rangle) = p_0,quad 1 — sigma(langle w, x_1rangle) = p_1$$

Теперь, если признаковое описание данных достаточно хорошее (то есть классы не перемешаны как попало и всё-таки близки к разделимым) и в то же время модель не переобученная (то есть, в частности, предсказания вероятностей не скачут очень уж резко – вспомните второй пример), то результат, полученный для $n$ совпадающих точек будет приблизительно верным и для $n$ достаточно близких точек: на всех них модель будет выдавать примерно долю положительных, то есть тоже хорошую оценку вероятности.

Как же всё-таки предсказать вероятности: методы калибровки

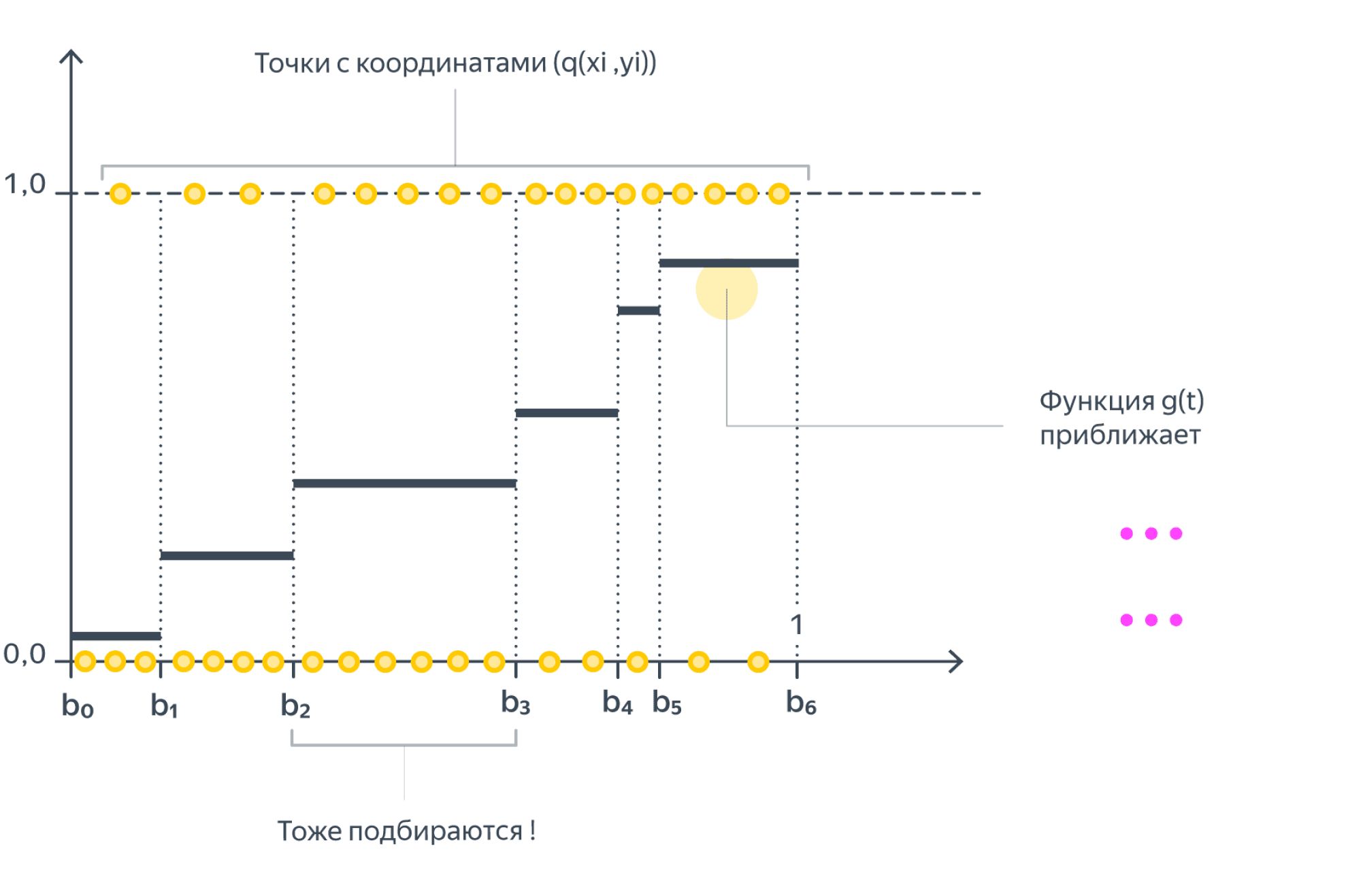

Пусть наша модель (бинарной классификации) для каждого объекта $x_i$ выдаёт некоторое число $q(x_i)in[0,1]$. Как же эти числа превратить в корректные вероятности?

- Гистограммная калибровка. Мы разбиваем отрезок $[0,1]$ на бины $mathbb{B}_1,ldots,mathbb{B}_k$ (одинаковой ширины или равномощные) и хотим на каждом из них предсказывать всегда одну и ту же вероятность: $theta_j$, если $q(x_i)in mathbb{B}_j$. Вероятности $theta_i$ подбираются так, чтобы они как можно лучше приближали средние метки классов на соответствующих бинах; иными словами, мы решаем задачу

$$sum_{j=1}^kleft|frac{sum_{i=1}^Nmathbb{I}{q(x_i)inmathbb{B}_j}y_i}{ vert mathbb{B}_j vert } — theta_jright|longrightarrowminlimits_{(theta_1,ldots,theta_k)}$$

Вместо разности модулей можно рассматривать и разность квадратов.

Метод довольно простой и понятный, но требует подбора числа бинов и предсказывает лишь дискретное множество вероятностей.

**Изотоническая регрессия**. Этот метод похож на предыдущий, только мы будем, во-первых, настраивать и границы $0=b_0,b_1,ldots,b_k = 1$ бинов $mathbb{B}_j = {t vert b_{j-1}leqslant b_j}$, а кроме того, накладываем условие $theta_1leqslantldotsleqslanttheta_k$. Искать $b_j$ и $theta_j$ мы будем, приближая $y_i$ кусочно постоянной функцией $g$ от $q(x_i)$:

$$sum_{i=1}^N(y_i — g(q(x_i)))^2longrightarrowmin_{g}$$

Минимизация осуществляется при помощи pool adjacent violators algorithm, и эти страницы слишком хрупки, чтобы выдержать его формулировку.

- Калибровка Платта представляет собой по сути применение сигмоиды поверх другой модели (то есть самый наивный способ получения »вероятностей»). Более точно, если $q(x_i)$ – предсказанная вероятность, то мы полагаем

$$P(y_i = 1mid x_i) = sigma(aq(x_i) + b) = frac1{1 + e^{-aq(x_i) — b}}$$

где $a$ и $b$ подбираются методом максимального правдоподобия на отложенной выборке:

$$-sum_{i=1}^N(vphantom{frac12}y_ilog(sigma(q(x_i))) + (1 — y_i)log(1 — sigma(q(x_i))))longrightarrowminlimits_{a,b}$$

Для избежания переобучения Платт предлагал также заменить метки $y_i$ и $(1 — y_i)$ на регуляризованные вероятности таргетов:

$$t_0 = frac1{#{i vert y_i = 0} + 2},quad t_1 = frac{#{i vert y_i = 1} + 1}{#{i vert y_i = 0} + 2}$$

Калибровка Платта неплохо справляется с выколачиванием вероятностей из SVM, но для более хитрых классификаторов может спасовать. В целом, можно показать, что этот метод хорошо работает, если для каждого из истинных классов предсказанные вероятности $q(x_i)$ распределы нормально с одинаковыми дисперсиями. Подробнее об этом вы можете почитать в этой статье. Там же описано обобщение данного подхода – бета-калибровка.

С большим количеством других методов калибровки вы можете познакомиться в этой статье

Как измерить качество калибровки

Калибровочные кривые хорошо показывают, что есть проблемы, но как оценить наши потуги по улучшению предсказания вероятностей? Хочется иметь какую-то численную метрику. Мы упомянем две разновидности, которые по сути являются прямым воплощением описанных выше идей.

- Expected/Maximum calibration error. Самый простой способ, впрочем, является наследником идеи с калибровочной кривой. А именно, разобьём отрезок $[0,1]$ на бины $mathbb{B}_1,ldots,mathbb{B}_k$ по предсказанным вероятностям и вычислим

$$sum_{j=1}^kfrac{#mathbb{B}_j}{N}left|overline{y}(mathbb{B}_j) — overline{q}(mathbb{B}_j)right|$$

или

$$maxlimits_{j=1,ldots,k}left|overline{y}(mathbb{B}_j) — overline{q}(mathbb{B}_j)right|$$

где $overline{y}(mathbb{B}_j)$ – среднее значение $y_i$, а $overline{q}(mathbb{B}_j)$ – среднее значение $q(x_i)$ для $x_i$, таких что $q(x_i)inmathbb{B}_j$. Проблема этого способа в том, что мы можем очень по-разному предсказывать в каждом из бинов вероятности (в том числе константой) без ущерба для метрики.

- Одна из популярных метрик – это Brier score, которая попросту измеряет разницу между предсказанными вероятностями и $ y_i $:

$$sum_{i=1}^N(y_i — q(x_i))^2$$

Казалось бы, в чём смысл? Немного подрастить мотивацию помогает следующий пример. Допустим, наши таргеты совершенно случайны, то есть $P(y_i = 1 vert x_i) = P(y_i)$. Тогда хорошо калиброванный классификатор должен для каждого $x_i$ предсказывать вероятность $frac12$; соответственно, его brier score равен $frac14$. Если же классификатор хоть в одной точке выдаёт вероятность $p>frac12$, то в маленькой окрестности он должен выдавать примерно такие же вероятности; поскольку же таргет случаен, локальный кусочек суммы из brier score будет иметь вид $frac{N’}{2}p^2 + frac{N’}{2}(1-p)^2 < frac{N’}2$, что хуже, чем получил бы всегда выдающий $frac12$ классификатор.

Не обязательно брать квадратичную ошибку; сгодится и наш любимый log-loss:

$$sum_{i=1}^Nleft(vphantom{frac12}y_ilog{q(x_i)} + (1 — y_i)log(1 — q(x_i))right)$$

Это же и помогает высветить ограничения подхода, если вспомнить рассуждения о калиброванности логистической регрессии. Для достаточно гладких классификатора и датасета briar score и log-loss будут адекватными средствами оценки, но если нет – возможно всякое.

Вопрос на засыпку: а как быть, если у нас классификация не бинарная, а многоклассовая? Что такое хорошо калиброванный классификатор? Как это определить численно? Как заставить произвольный классификатор предсказывать вероятности?

Мы не будем про это рассказывать, но призываем читателя подумать над этим самостоятельно или, например, посмотреть туториал с ECML KDD 2020.

Пусть

производятся независимые испытания с

неизвестной вероятностью p

появления события A

в каждом испытании. Требуется оценить

неизвестную вероятность p

по относительной частоте, т. е. надо

найти ее точечную и интервальную оценки.

Точечная

оценка.

В качестве точечной оценки неизвестной

вероятности p

принимают относительную частоту:

W

= т/п,

где

т—число

появлений события

A,

п—число

испытаний.

Эта

оценка несмещенная, т. е. ее математическое

ожидание

равно оцениваемой вероятности.

Действительно, учитывая, что

М (т)= пр,

получим:

M

(W)

=

M

[m/п]

= М (т)/п = пр/п = р.

Найдем

дисперсию

оценки,

приняв во внимание, что D(m)=

npq:

D

(W)

=

D

[т/п] = D

(т)/п2

= npq/n2

= pq/n,

тогда

среднее

квадратическое отклонение

находим по формуле:

σ=

Интервальная

оценка.

Найдем доверительный интервал для

оценки вероятности по относительной

частоте.

Формула,

позволяющая найти вероятность того,

что абсолютная величина отклонения

не превысит

положительного

числа б:

Р

(|Х —а | <

б) = 2Ф (б/а)

(*),

где

X

—нормальная

случайная

величина с математическим ожиданием

М (Х) = а.

Если

п

достаточно велико и вероятность р

не очень близка к нулю и к единице, то

можно считать M(W)

= p.

Таким

образом, заменив в соотношении (*)

случайную величину

X

и ее математическое ожидание

а

соответственно случайной величиной

W

и ее математическим ожиданием

р,

получим приближенное равенство

P

(| W—р

| <

б) = Ф(б/σ).

Построим

доверительный интервал с надежностью

γ:

P

(| W—р

| <

б) = Ф(б/σ) = γ

Заменим

σ

,

Тогда

P

(| W—р

| <

б) = Ф(б

/

)

= Ф(t)

= γ,

Где

t

= б

/

),

откуда б = t

/

Заменим

в неравенстве случайную величину W

на неслучайную наблюдаемую относительную

частоту ω и заменим q=1-p,

подставим

выражение для б, получим:

|ω

— p|

< t

/

,

раскрываем модуль, оценивая ω<

p

и ω>p

получим p1

и p2

— промежутки для доверительного

интервала.

Доверительный

интервал.

Θ

– Исследуемый параметр, Θ

* — статистическая характеристика

исследуемого параметра

|

Θ

— Θ

*|<б – точность оценки

P

(|Θ-Θ*|<б)

= γ

– точность( доверительная вероятность)

Доверительным

называют интервал (Θ*

— б; Θ*

+ б), который покрывает неизвестный

параметр с заданной надежностью.

60. Оценка параметров в статистике

Пусть

нам нужно изучить к-либо признак

генеральной совокупности и мы теоретически

знаем его тип распределения.

Обычно

имеем: данные выборки (например, значения

признака x1,x2,xn

в результате n

независимых испытаний).

61. Дисперсионный анализ. Однофакторный комплекс.

Основная

идея: сравнения «факторной» дисперсии

и «остаточной» (вызванная в результате

случайных причин).

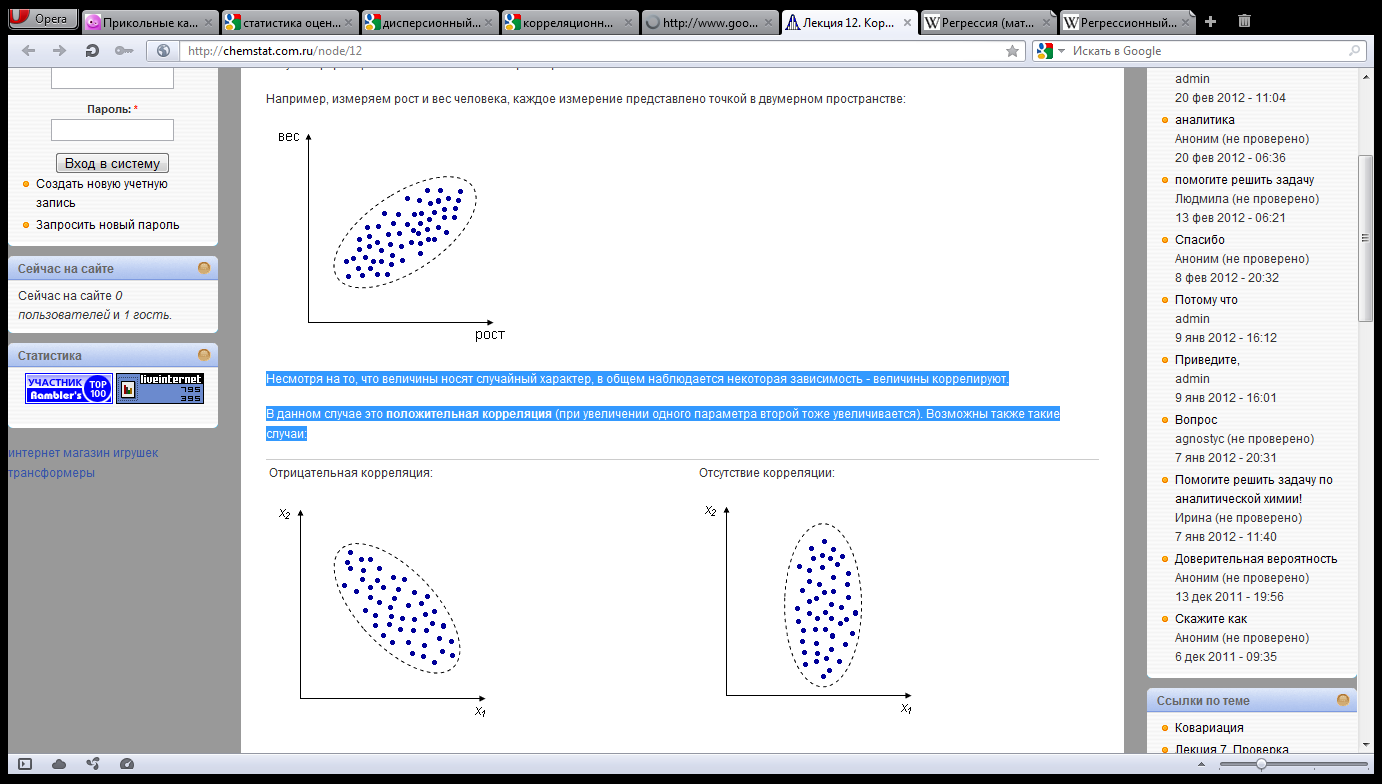

62. Корреляционный анализ. Регрессия.

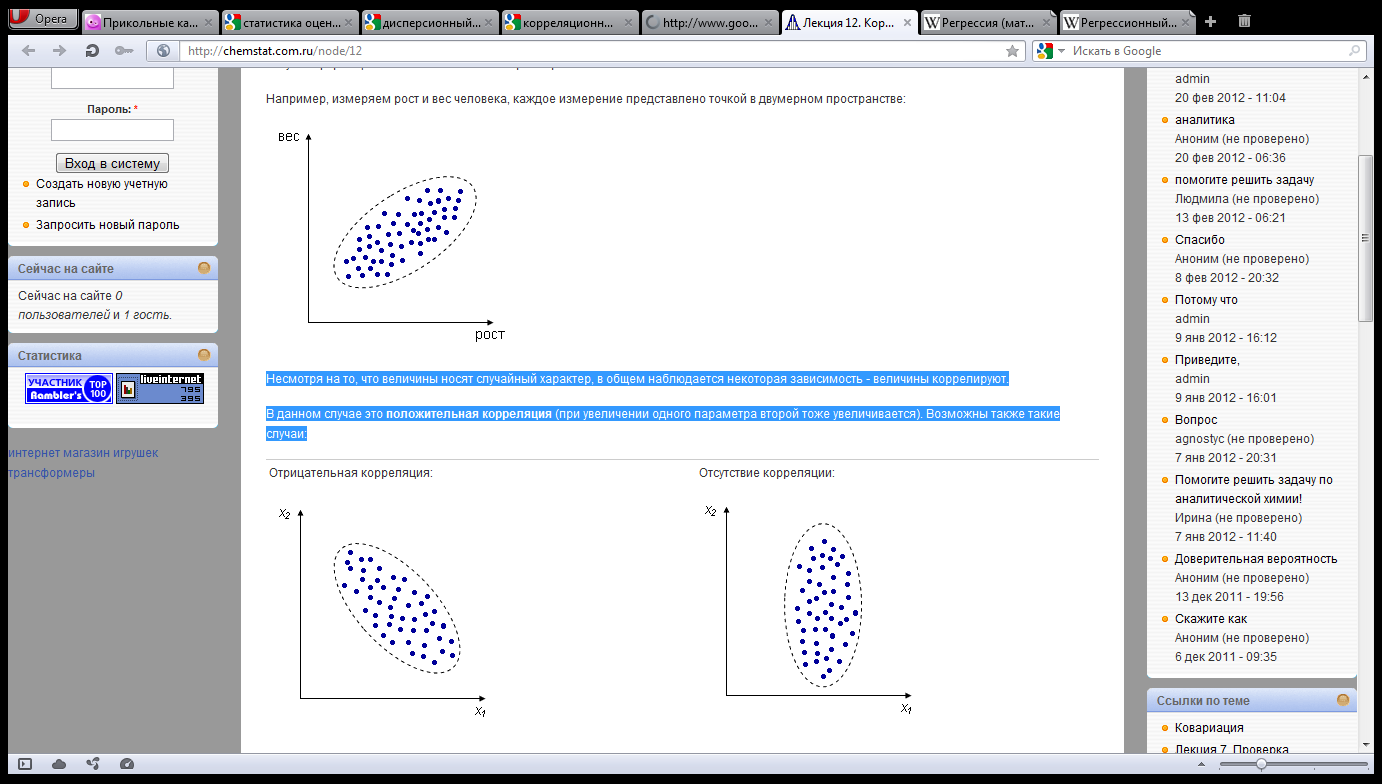

Корреляционный

анализ — метод, позволяющий обнаружить

зависимость между несколькими с.в.

Допустим,

проводится независимое измерение

различных параметров у одного типа

объектов. Из этих данных можно получить

качественно новую информацию — о

взаимосвязи этих параметров.

Н

апример,

измеряем рост и вес человека, каждое

измерение представлено точкой в двумерном

пространстве:

Н

есмотря

на то, что величины носят случайный

характер, в общем наблюдается некоторая

зависимость — величины коррелируют.

В

данном случае это положительная

корреляция (при увеличении одного

параметра второй тоже увеличивается).

Возможны

также такие случаи:

Регре́ссия

— зависимость среднего значения к-либо

величины от некоторой другой величины

или от нескольких величин. В отличие от

чисто функциональной зависимости

y=f(x), при регрессионной связи одному и

тому же значению x могут соответствовать

в зависимости от случая различные

значения величины y. Если при каждом

значении x=xi

наблюдается

ni

значений yi1…yin1

величины y, то зависимость средних

арифметических

и

является регрессией.

Соседние файлы в предмете [НЕСОРТИРОВАННОЕ]

- #

- #

- #

- #

- #

- #

- #

- #

- #

- #

- #

Так же как и теория вероятностей, математическая статистика имеет свои ключевые понятия, к которым относятся: генеральная совокупность, теоретическая функция распределения, выборка, эмпирическая функция распределения, статистика. Именно с определения этих понятий, а также с установления связи между ними и объектами, изучаемыми в теории вероятностей, мы начнем изложение математической статистики, предварительно дав краткое описание задач, которые собираемся решать. Кроме того, в последнем параграфе главы остановимся на некоторых распределениях, наиболее часто встречающихся в математической статистике.

Задачи математической статистики

Математическая статистика, являясь частью общей прикладной математической дисциплины «Теория вероятностей и математическая статистика», изучает, как и теория вероятностей, случайные явления, использует одинаковые с ней определения, понятия и методы и основана на той же самой аксиоматике А.Н. Колмогорова.

Однако задачи, решаемые математической статистикой, носят специфический характер. Теория вероятностей исследует явления, заданные полностью их моделью, и выявляет еще до опыта те статистические закономерности, которые будут иметь место после его проведения. В математической статистике вероятностная модель явления определена с точностью до неизвестных параметров. Отсутствие сведений о параметрах компенсируется тем, что нам позволено проводить «пробные» испытания и на их основе восстанавливать недостающую информацию.

Попытаемся показать различие этих двух взаимосвязанных дисциплин на простейшем примере — последовательности независимых одинаковых испытаний, или схеме Бернулли (часть 1, гл.4). Схему Бернулли можно трактовать как подбрасывание несимметричной монеты с вероятностью выпадения «герба» (успеха) р и «цифры» (неудачи)

часть 1, гл.4, параграфы 2-4) и т.д. В математической статистике значения р и q неизвестны заранее, но мы можем произвести серию подбрасываний монеты. Цель проведения испытаний как раз и заключается либо в определении р и q, либо в проверке некоторых априорных суждений относительно их значений. Таким образом, судя уже по этому простейшему примеру, задачи математической статистики являются в некотором смысле обратными задачам теории вероятностей.

В математической статистике обычно принято выделять два основных направления исследований.

Первое направление связано с оценкой неизвестных параметров. Возвращаясь к нашему примеру, предположим, что мы произвели п подбрасываний монеты и установили, что в

Второе направление в математической статистике связано с проверкой некоторых априорных предположений, или статистических гипотез. Так, до опыта мы можем предположить, что монета симметрична, т.е. высказать гипотезу о равенстве

на ошибки первого и второго рода. Ошибка первого рода состоит в том, что мы принимаем конкурирующую гипотезу

Далее мы увидим, что задача проверки статистических гипотез наиболее полно решается для случая двух простых гипотез. Можно поставить и задачу проверки нескольких гипотез (в примере с монетой можно взять, например, три гипотезы:

Условно математическую статистику можно подразделить на исследование байесовских и небайесовских моделей.

Байесовские модели возникают тогда, когда неизвестный параметр является случайной величиной и имеется априорная информация о его распределении. При байесовском подходе на основе опытных данных априорные вероятности пересчитываются в апостериорные. Применение байесовского подхода фактически сводится к использованию формулы Байеса (см. часть 1, гл. 3, параграф 5), откуда, собственно говоря, и пошло его название. Байесовский подход нами будет применяться только как вспомогательный аппарат при доказательстве некоторых теорем.

Небайесовские модели появляются тогда, когда неизвестный параметр нельзя считать случайной величиной и все статистические выводы приходится делать, опираясь только на результаты «пробных» испытаний. Именно такие модели мы будем рассматривать в дальнейшем изложении.

В заключение этого параграфа отметим, что в математической статистике употребляют также понятия параметрических и непараметрических моделей. Параметрические модели возникают тогда, когда нам известна с точностью до параметра (скалярного или векторного) функция распределения наблюдаемой характеристики и необходимо по результатам испытаний определить этот параметр (задача оценки неизвестного параметра) или проверить гипотезу о принадлежности его некоторому заранее выделенному множеству значений (задача проверки статистических гипотез). Все приведенные выше примеры с подбрасыванием монеты представляют собой параметрические модели. Примеры непараметрических моделей мы рассмотрим позже.

Основные понятия математической статистики

Основными понятиями математической статистики являются: генеральная совокупность, выборка, теоретическая функция распределения.

Генеральная совокупность. Будем предполагать, что у нас имеются N объектов, каждому из которых присуще определенное значение некоторой числовой характеристики X. Характеристика X, вообще говоря, может быть и векторной (например, линейные размеры объекта), однако для простоты изложения мы ограничимся только скалярным случаем, тем более что переход к векторному случаю никаких трудностей не вызывает. Совокупность этих N объектов назовем генеральной совокупностиью.

Поскольку все наши статистические выводы мы будем делать, основываясь только на значениях числовой характеристики X, естественно абстрагироваться от физической природы самих объектов и отождествить каждый объект с присущей ему характеристикой X. Таким образом, с точки зрения математической статистики генеральная совокупность представляет собой N чисел, среди которых, конечно, могут быть и одинаковые.

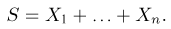

Выборка. Для того чтобы установить параметры генеральной совокупности, нам позволено произвести некоторое число п испытаний. Каждое испытание состоит в том, что мы случайным образом выбираем один объект генеральной совокупности и определяем его значение X. Полученный таким образом ряд чисел

Заметим, что сам процесс выбора можно осуществлять различными способами: выбрав объект и определив его значение, изымать этот объект и не допускать к последующим испытаниям (выборка без возвращения); после определения его значения объект возвращается в генеральную совокупность и может полноправно участвовать в дальнейших испытаниях (выборка с возвращением) и т.д.

Разумеется, если бы мы смогли провести сплошное обследование всех объектов генеральной совокупности, то не нужно было бы применять никакие статистические методы и саму математическую статистику можно было бы отнести к чисто теоретическим наукам. Однако такой полный контроль невозможен по следующим причинам. Во-первых, часто испытание сопровождается разрушением испытуемого объекта; в этом случае мы имеем выборку без возвращения. Во-вторых, обычно необходимо исследовать весьма большое количество объектов, что просто невозможно физически. Наконец, может возникнуть такое положение, когда многократно измеряется один и тот же объект, но каждый замер производится со случайной ошибкой, и цель последующей статистической обработки заключается именно в уточнении характеристик объекта на основе многократных наблюдений; при этом результат каждого наблюдения надо считать новым объектом генеральной совокупности (простейшим примером такой ситуации является многократное подбрасывание монеты с целью определения вероятности выпадения «герба»). Следует помнить также, что выборка обязательно должна удовлетворять условию репрезентативности или, говоря более простым языком, давать обоснованное представление о генеральной совокупности.

С ростом объема N генеральной совокупности исчезает различие между выборками с возвращением и без возвращения. Мы, как обычно это делается в математической статистике, будем рассматривать случай бесконечно большого объема генеральной совокупности и поэтому, употребляя слово «выборка», не будем указывать, какая она — с возвращением или без него.

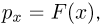

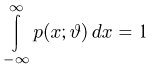

Теоретическая функция распределения. Пусть

В случае выборки

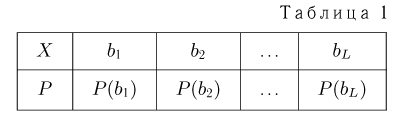

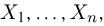

В дальнейшем, как правило, мы будем предполагать, что F(x) является функцией распределения либо дискретной, либо непрерывной наблюдаемой случайной величины X. В первом случае будем оперировать рядом распределения случайной величины X, записанным в виде табл. 1, а во втором — плотностью распределения

Простейшие статистические преобразования

Прежде чем переходить к детальному анализу наблюденных статистических данных, обычно проводят их предварительную обработку. Иногда результаты такой обработки уже сами по себе дают наглядную картину исследуемого явления, в большинстве же случаев они служат исходным материалом для получения более подробных статистических выводов.

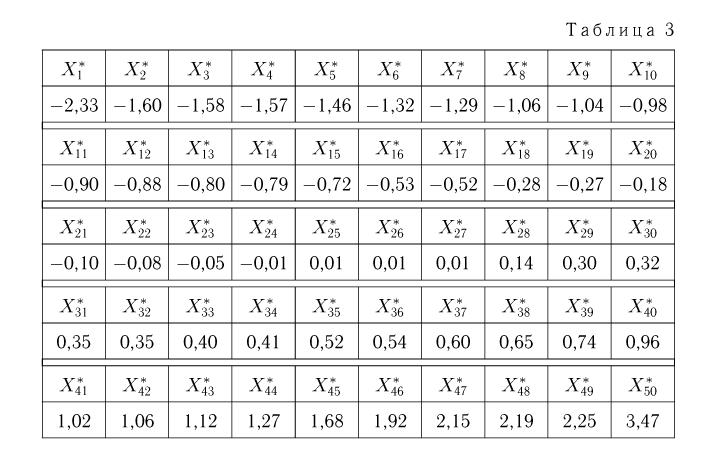

Вариационный и статистический ряды. Часто бывает удобно пользоваться не самой выборкой

Для

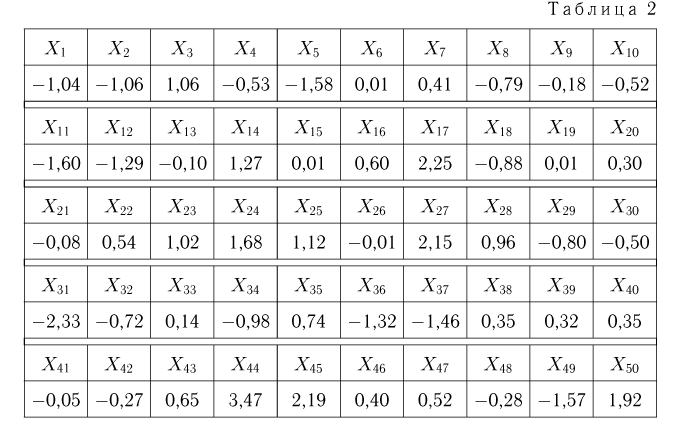

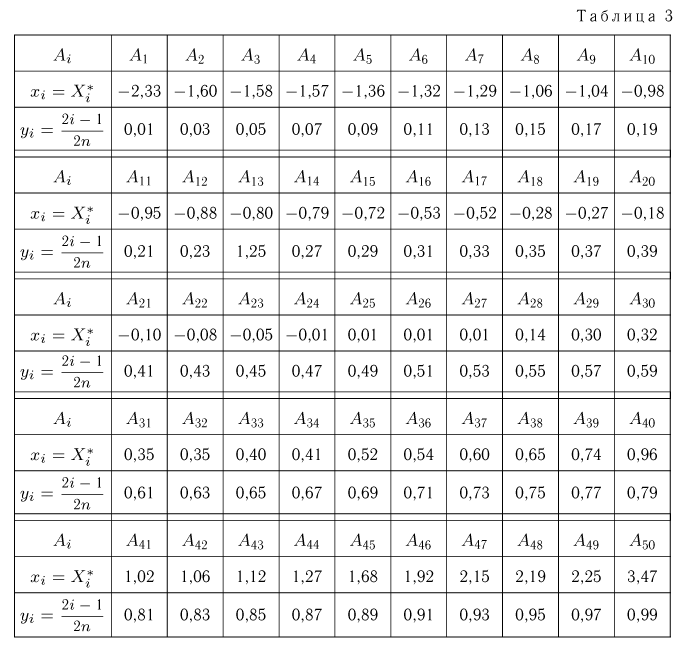

Пример 1. Измерение проекции вектора скорости молекул водорода на одну из осей координат дало (с учетом направления вектора) результаты

Вариационный ряд этой выборки приведен в табл. 3. Крайними членами вариационного ряда

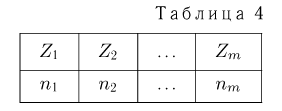

Если среди элементов выборки

ряда (табл.4), в котором

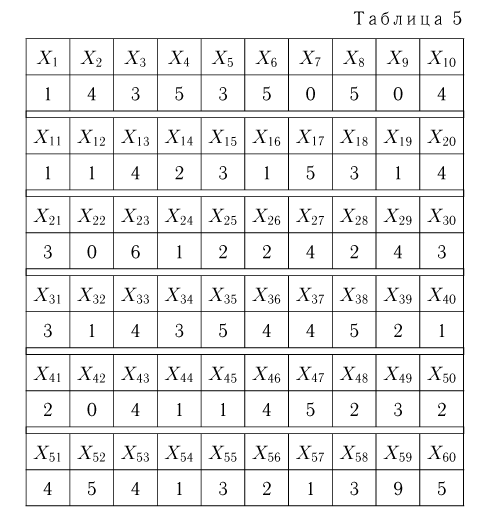

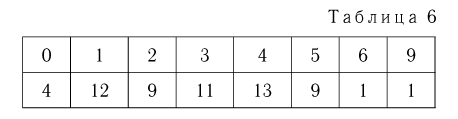

Пример 2. В течение минуты каждую секунду регистрировалось число попавших в счетчик Гейгера частиц. Результаты наблюдений приведены в табл. 5.

Статистический ряд выборки представлен в табл. 6.

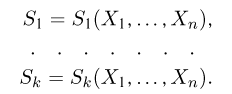

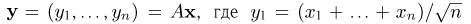

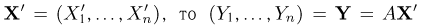

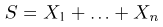

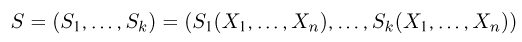

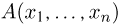

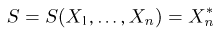

Статистики. Для получения обоснованных статистических выводов необходимо проводить достаточно большое число испытаний, т.е. иметь выборку достаточно большого объема п. Ясно, что не только использование такой выборки, но и хранение ее весьма затруднительно. Чтобы избавиться от этих трудностей, а также для других целей, полезно ввести понятие статистики, общее определение которой формулируется следующим образом. Назовем статистикой

Как функция от случайного вектора

определяется для дискретной наблюдаемой случайной величины X формулой

и для непрерывной — формулой

где суммирование или интегрирование производится по всем возможным значениям

Пример 3. Пусть выборка

Тогда

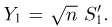

Мы, однако, не будем вычислять записанный интеграл, а воспользуемся тем фактом (см. пример 29, часть 1, гл.6, параграф 7), что любое линейное преобразование переводит нормально распределенный вектор в вектор, снова имеющий нормальное распределение, причем ортогональное преобразование переводит вектор с независимыми координатами, имеющими одинаковые дисперсии, в вектор с также независимыми и имеющими те же самые дисперсии координатами.

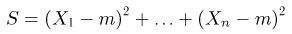

Из курса теории вероятностей известно, что статистика

Очевидно, что

Пусть теперь А — линейное ортогональное преобразование пространства

С другой стороны, в силу ортогональности преобразования А

Отсюда, в частности, следует, что

т.е.

Отметим, что проведенные рассуждения будут нами постоянно использоваться в гл. 4, посвященной статистическим задачам, связанным с нормально распределенными наблюдениями.

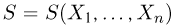

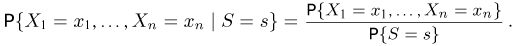

Важный класс статистик составляют так называемые достаточные статистики. Не давая пока строгого математического определения, скажем, что статистика S является достаточной, если она содержит всю ту информацию относительно теоретической функции распределения F(x), что и исходная выборка

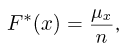

Эмпирическая функция распределения. Пусть мы имеем выборку

где

Функция

Построение эмпирической функции распределения

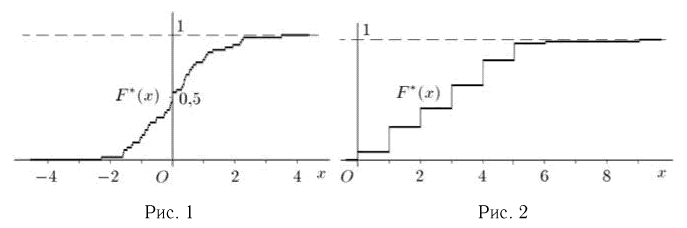

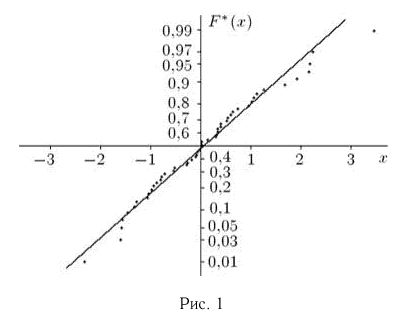

Пример 4. График эмпирической функции распределения, построенной по вариационному ряду из табл. 3, приведен на рис. 1.

Если выборка задана статистическим рядом (см. табл. 4), то эмпирическая функция распределения также постоянна на интервалах

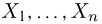

Пример 5. График эмпирической функции распределения, построенной по статистическому ряду из табл. 6, приведен на рис. 2.

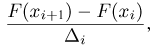

Гистограмма, полигон. Для наглядности выборку иногда преобразуют следующим образом. Всю ось абсцисс делят на интервалы

При наблюдении дискретной случайной величины вместо гистограммы часто используют полигон частот. Для этого по оси абсцисс откладывают все возможные значения

(полигон относительных частот). Для большей наглядности соседние точки соединяются отрезками прямой.

Для непрерывной наблюдаемой случайной величины полигоном относительных частот иногда называют ломаную линию, соединяющую середины отрезков, составляющих гистограмму.

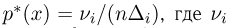

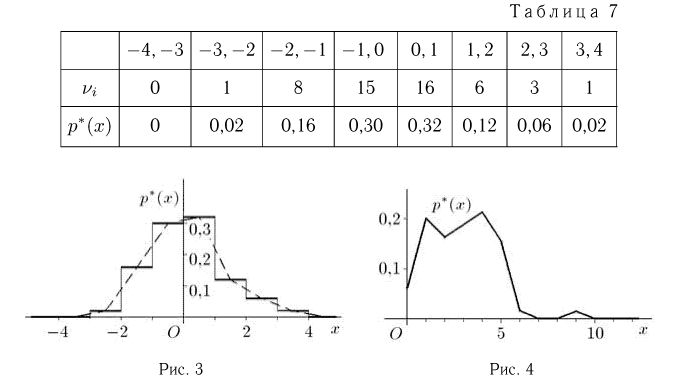

Пример 6. Построим гистограмму и полигон относительных частот выборки, представленной в табл. 2. Для этого выберем интервалы одинаковой длины

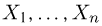

Пример 7. Построим полигон относительных частот выборки, приведенной в табл. 5. Возможные значения наблюдаемой случайной величины X (числа частиц, попавших в счетчик Гейгера) представляют собой неотрицательные целые числа. Воспользовавшись статистическим рядом из табл. 6, получаем полигон относительных частот, изображенный на рис. 4.

Предельное поведение эмпирической функции распределения.

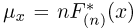

Предположим, что по выборке

Теорема Гливенко-Кантелли. При

Смысл теоремы Гливенко-Кантелли заключается в том, что при увеличении объема выборки п у эмпирической функции распределения исчезают свойства случайности и она приближается к теоретической функции распределения.

Аналогично, если п велико, то значение гистограммы

где

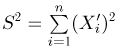

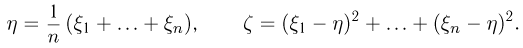

Выборочные характеристики. Эмпирическая функция распределения

второй момент

дисперсию

момент k-го порядка

центральный момент k-го порядка

и т.д. Соответствующие характеристики называются выборочными (выборочное среднее, выборочный второй момент, выборочная дисперсия и т.п.). Ясно, что выборочные характеристики как функции от случайных величин

где суммирование ведется по всем

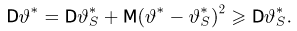

Наряду с выборочной дисперсией

Характеристику

Пример 8. Подсчитаем выборочное среднее и выборочные дисперсии для выборки, приведенной в табл. 2:

Для подсчета выборочной дисперсии

Основные распределения математической статистики

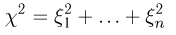

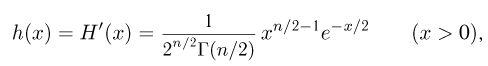

Наиболее часто в математической статистике используются: нормальное распределение,

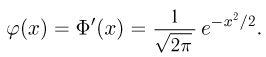

Нормальное распределение. Одномерное стандартное нормальное распределение (стандартный нормальный закон) задается своей плотностью распределения (см. часть 1, гл.5, параграф 4)

Значения функции Ф(x) и плотности

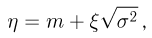

Общее одномерное нормальное распределение характеризуется двумя параметрами: средним (математическим ожиданием) т и дисперсией

где случайная величина

носит название

где

Значения функции

Тогда случайная величина

имеет

Еще одна схема, в которой появляется

при

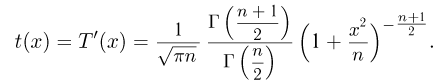

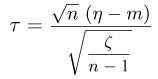

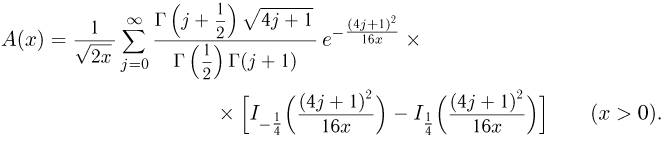

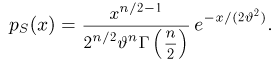

t-распределение. Пусть

называется t-распределением с п степенями свободы, t-распределение имеет плотность распределения

Значения функции t-распределения и

Далее, пусть

Тогда случайные величины

имеет t-распределение с n-1 степенями свободы (доказательство этого см. в примере 3).

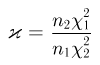

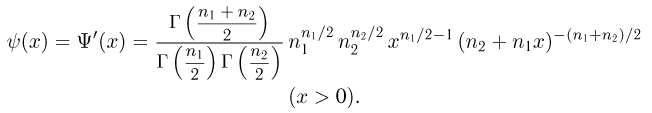

F-распределение. Пусть

носит название F-распределения с параметрами

Значения

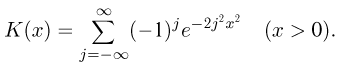

Распределение Колмогорова. Функция распределения Колмогорова имеет вид

Распределение Колмогорова является распределением случайной величины

где

Значения функции распределения Колмогорова приведены в [1], табл.6.1. Квантили распределения Колмогорова будем обозначать через

Здесь

где

Значения функции

Оценки неизвестных параметров

Как уже говорилось в гл. 1, одним из двух основных направлений в математической статистике является оценивание неизвестных параметров. В этой главе мы дадим определение оценки, опишем те свойства, которые желательно требовать от оценки, и приведем основные методы построения оценок. Завершается глава изложением метода построения доверительных интервалов для неизвестных параметров.

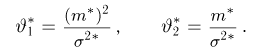

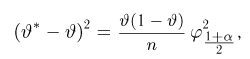

Статистические оценки и их свойства

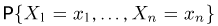

Предположим, что в результате наблюдений мы получили выборку

Оценкой неизвестного параметра

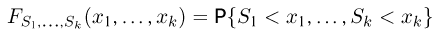

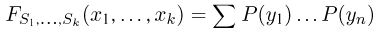

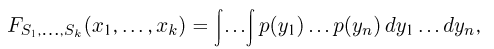

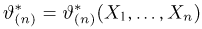

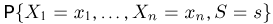

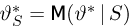

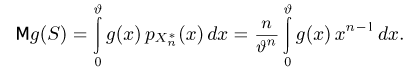

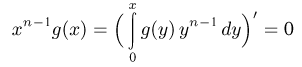

зависящую только от выборки

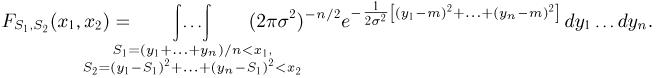

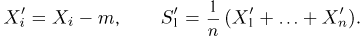

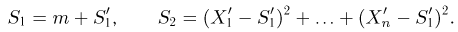

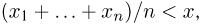

где суммирование ведется по всем переменным

где интегрирование ведется по области, выделяемой неравенством

Пример:

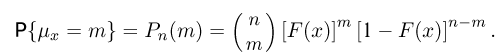

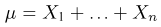

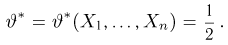

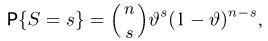

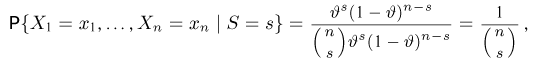

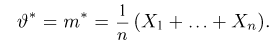

Предположим, что проведено п испытаний в схеме Бернулли с неизвестной вероятностью успеха

В качестве оценки

где

представляет собой суммарное число успехов в п испытаниях Бернулли. Статистика

Пример:

Выборка

Функция распределения

Однако вместо непосредственного вычисления написанного n-мерного интеграла заметим, что статистика

распределена по нормальному закону с параметрами

Разумеется, на практике имеет смысл использовать далеко не любую оценку.

Пример:

Как и в примере 1, рассмотрим испытания в схеме Бернулли. Однако теперь в качестве оценки неизвестной вероятности успеха

Такая оценка будет хороша лишь в том случае, когда истинное значение

Приведенный пример показывает, что желательно употреблять только те оценки, которые по возможности принимали бы значения, наиболее близкие к неизвестному параметру. Однако в силу случайности выборки в математической статистике мы, как правило, не застрахованы полностью от сколь угодно большой ошибки. Значит, гарантировать достаточную близость оценки

Опишем теперь те свойства, которые мы хотели бы видеть у оценки.

Главное свойство любой оценки, оправдывающее само название «оценка», — возможность хотя бы ценой увеличения объема выборки до бесконечности получить точное значение неизвестного параметра

Отметим, что правильнее было бы говорить о состоятельности последовательности оценок

Пример:

Оценка

Пример:

Пусть выборка

сходится к теоретическому моменту

Пример:

Выборка

с неизвестным параметром

Однако

Из курса теории вероятностей известно (см. часть 1, гл.7, параграф 1), что мерой отклонения оценки

называется смещением оценки

в дискретном случае и

в непрерывном, где суммирование или интегрирование ведется по всем возможным значениям

Оценка

при всех

Пример:

Оценка

Пример:

Выборочные моменты

Вычислим теперь математическое ожидание выборочной дисперсии

Таким образом,

то

и

Пример:

Пусть

является несмещенной. Очевидно, однако, что она не является состоятельной.

Примеры 8 и 9 показывают, что состоятельная оценка может быть сметенной и, наоборот, несмещенная оценка не обязана быть состоятельной.

Рассматривая несколько оценок неизвестного параметра

(дисперсия, как и распределение оценки, зависит от неизвестного параметра

Имеется несколько подходов к нахождению несмещенных оценок с минимальной дисперсией. Это связано с тем, что такие оценки существуют не всегда, а найти их бывает чрезвычайно сложно. Здесь мы изложим понятие эффективности оценки, основанное на неравенстве Рао-Крамера.

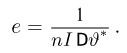

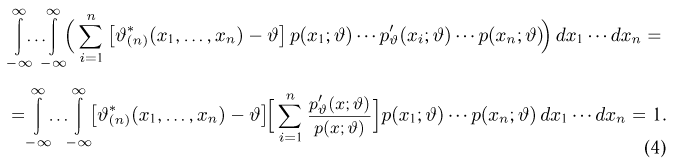

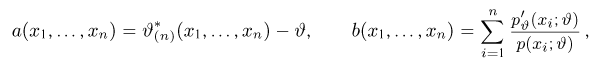

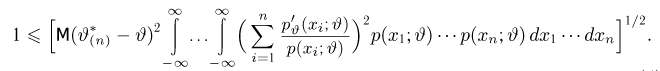

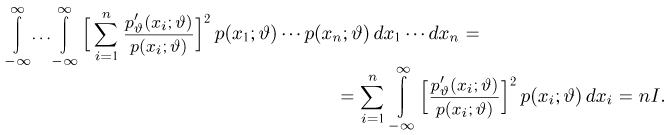

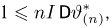

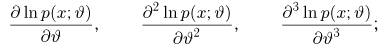

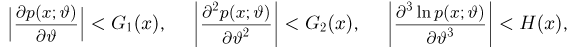

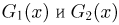

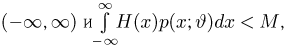

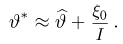

Теорема:

Неравенство Рао-Крамера. Пусть

где

а в непрерывном — формулой

Прежде чем переходить к доказательству теоремы, заметим, что по неравенству Рао-Крамера дисперсия любой несмещенной оценки не может быть меньше

Ясно, что эффективность любой оценки

Несмещенная оценка

Доказательство теоремы 1. Доказательство этой и всех остальных теорем будем проводить (если не сделано специальной оговорки) для непрерывного случая. Это связано с тем, что непрерывный случай, как правило, более сложен, и читатель, усвоивший доказательство для непрерывного случая, легко проведет его для дискретного.

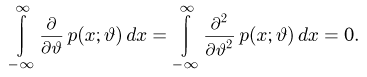

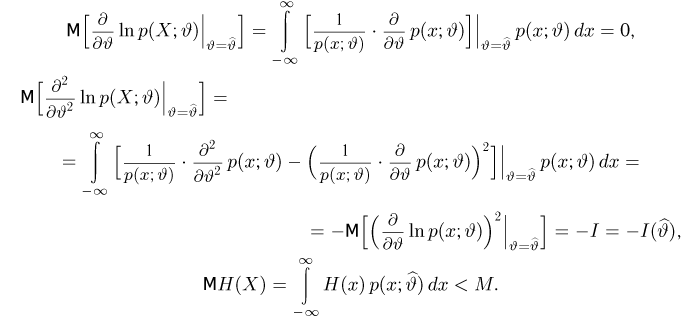

Как мы увидим из хода доказательства, условия регулярности семейства

функция

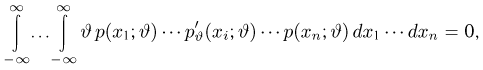

Приступим теперь к собственно доказательству теоремы. Заметим прежде всего, что, дифференцируя тождество

(в силу сформулированного условия это можно делать), получаем

Далее, в силу несмещенности оценки

Дифференцируя это равенство по

полученное из (1) и (2), находим

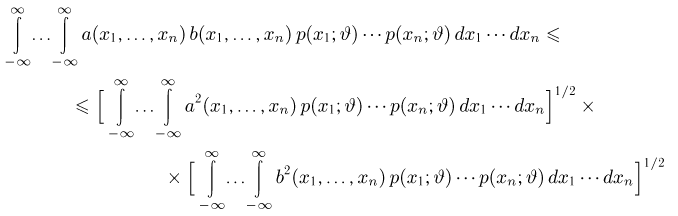

Воспользовавшись неравенством Коши-Буняковского

при

имеем

Заметим теперь, что в силу тождества (2)

Тогда неравенство (5) можно переписать в виде

Замечание:

Для превращения используемого при доказательстве теоремы 1 неравенства Коши-Буняковского, в равенство необходимо и достаточно существование таких функций

При этом оценка

Обозначая

и интегрируя уравнение (6), получаем, что необходимым условием существования эффективной оценки является возможность представления плотности распределения

где

Аналогичное представление для ряда распределения

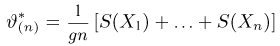

Экспоненциальные семейства играют в математической статистике важную роль. В частности, как мы показали, только для этих семейств могут существовать эффективные оценки, которые к тому же определяются формулой

(появление множителя

Замечание:

Неравенство Рао-Крамера можно обобщить на случай смещенных оценок:

И в этом случае неравенство превращается в равенство только тогда, когда семейство распределений экспоненциально.

Пример:

Рассмотрим оценку

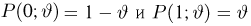

Найдем информацию Фишера (напомним, что в данном случае наблюдаемая величина X принимает всего два значения 0 и 1 с вероятностями

Таким образом,

Пример:

Рассмотрим оценку

Далее,

И в этом примере оценка

Пример:

Оценим неизвестную дисперсию

где

т.е. по отношению к неизвестной дисперсии

С другой стороны, нетрудно видеть, что

и, значит, ее эффективность. Впрочем, эффективность оценки

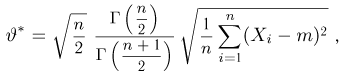

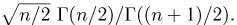

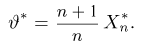

Пусть теперь мы оцениваем не дисперсию, а среднее квадратичное отклонение

Поэтому равенство

равную корню квадратному из оценки дисперсии с точностью до постоянного множителя

Пример:

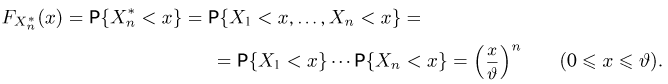

Пусть выборка

Функция распределения

Тогда

Значит, оценка

Мы видим, что дисперсия оценки

В заключение этого параграфа отметим, что эффективные по Рао-Крамеру оценки существуют крайне редко. Правда, как мы увидим в параграфе 4, эффективность по Рао-Крамеру играет существенную роль в асимптотическом анализе оценок, получаемых методом максимального правдоподобия. Кроме того, существуют обобщения неравенства Рао-Крамера (например, неравенство Бхаттачария [7]), позволяющие доказывать оптимальность более широкого класса оценок.

В следующем параграфе мы рассмотрим другой подход к определению оценок с минимальной дисперсией, базирующийся на достаточных статистиках.

Наиболее распространенные методы нахождения оценок приводятся в параграфах 3-6.

Наконец, в параграфе 7 описан подход к построению доверительных интервалов для неизвестных параметров.

Достаточные оценки

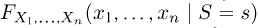

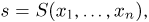

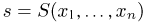

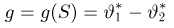

Первый шаг в поисках другого (не основанного на неравенстве Рао-Крамера) принципа построения оценок с минимальной дисперсией состоит во введении понятия достаточной статистики (отметим, что достаточные статистики играют в современной математической статистике весьма важную роль, причем как при оценке неизвестных

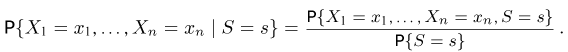

параметров, так и при проверке статистических гипотез). Назовем k-мерную статистику

достаточной для параметра

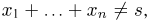

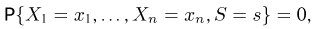

Пример:

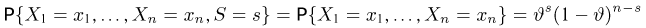

Пусть

— общее число успехов в п испытаниях Бернулли. Покажем, что она является достаточной для вероятности успеха

Если

(напомним еще раз, что каждое

то из (9) получаем, что

т. е. не зависит от

откуда

т. е. опять-таки не зависит от

Очевидно, что использовать приведенное выше определение для проверки достаточности конкретных статистик весьма сложно, особенно в непрерывном случае. Простой критерий достаточности задается следующей теоремой.

Теорема:

Факторизационная теорема Неймана-Фишера. Для того чтобы статистика

в дискретном случае или плотность распределения

в непрерывном случае выборки

где функция

Доказательство:

Для простоты изложения ограничимся только дискретным случаем. По определению условной вероятности,

Очевидно, что числитель в правой части (II) совпадает с вероятностью

Теперь, если S — достаточная статистика, то левая часть (12) не зависит от

Подставляя последнее равенство в (12), имеем

т.е. не зависит от

Замечание к теореме 2. Очевидно, что представление (10) справедливо с точностью до функции

Пример:

Пусть

является достаточной для (двумерного) параметра

т.е. имеет вид (10), где

Пример:

Пусть

является (одномерной) достаточной статистикой для

В частности, область изменения каждого аргумента

и положим

С учетом введенных функций.

Здесь уже при определении функции

является достаточной для параметра

Пример:

Покажем, что для экспоненциального семейства (7) существует одномерная достаточная статистика. Этот факт легко установить, если подставить выражение (7) в формулу для плотности распределения выборки

Полагая теперь

видим, что одномерная статистика

является достаточной для параметра

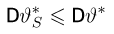

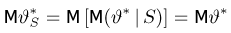

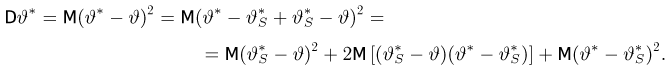

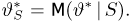

Как уже говорилось в гл. 1, смысл достаточной статистики S заключается в том, что она включает в себя всю ту информацию о неизвестном параметре

Начиная с этого момента и до конца параграфа будем для простоты предполагать, что неизвестный параметр

Пусть имеется некоторая оценка

Теорема:

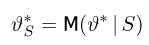

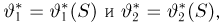

Улучшение оценки по достаточной статистике. Пусть S — достаточная статистика, а

при всех

Доказательство:

В силу достаточности статистики 5 условное распределение, а значит, и условное математическое ожидание оценки

для условного математического ожидания немедленно следует несмещенность оценки

Наконец,

Используя опять свойство условного математического ожидания, получаем

Поэтому

Замечание:

Неравенство (13) превращается для некоторого

Замечание:

Утверждение теоремы остается в силе и для смещенной оценки

Смысл теоремы 3 заключается в том, что взятие условного математического ожидания, т. е. переход к оценке

Пример:

Пусть

Нетрудно показать, что статистика S является достаточной для параметра

Иными словами, мы из совсем плохой оценки

Рассмотренный пример приоткрывает нам те возможности, которые несет с собой теорема 3. Однако, прежде чем сделать последний шаг, введем еще одно определение. Назовем статистику

при всех

Теорема:

Минимальность дисперсии оценки, зависящей от полной достаточной статистики. Пусть S — полная достаточная статистика,

является единственной несмещенной оценкой с минимальной дисперсией.

Доказательство теоремы немедленно вытекает из предыдущих результатов. Действительно, в силу теоремы 3 оценка с минимальной дисперсией обязательно должна находиться среди оценок, зависящих только от достаточной статистики S; в противном случае ее можно было бы улучшить с помощью условного математического ожидания. Но среди оценок, зависящих только от S, может быть максимум одна несмещенная. В самом деле, если таких оценок две:

имеет при всех значениях

что в силу полноты статистики S влечет за собой равенство

Перейдем к обсуждению полученных результатов.

Условие полноты статистики S, как мы видим, сводится к единственности несмещенной оценки

Сравнение размерностей полной статистики S и оцениваемого параметра

Сформулируем очевидное следствие из теоремы 4. которое удобно применять во многих частных случаях.

Следствие из теоремы 4. Если оценка

Пример:

Пусть

является достаточной для параметра

Пусть теперь

Тогда

что

Рассмотрим теперь оценку

(см. пример 12) неизвестного среднего квадратичного отклонения

Пример:

Рассмотрим оценку

параметра

Отсюда, в частности, следует, что если

при всех х. Поэтому

Таким образом, в силу следствия из теоремы 4 и в этом примере оценка

Метод моментов

Пусть мы имеем выборку

Суть метода моментов заключается в следующем: так как выборочные моменты являются состоятельными оценками теоретических моментов (см. пример 8), мы можем в написанной системе равенств при большом объеме выборки п теоретические моменты

Можно показать, что при условии непрерывной зависимости решения этой системы от начальных условий

Теорема:

Асимптотическая нормальность оценок, полученных методом моментов. При некоторых условиях, наложенных на семейство

при

Доказательство:

Будем полагать, что выполнены следующие условия: а) параметры

б) существует теоретический момент

в) функция

дифференцируема по

Доказательство теоремы проведем для одномерного случая, предоставляя общий случай читателю. Оно является комбинацией следующих результатов: теоремы о дифференцируемости обратного отображения и центральной предельной теоремы. Действительно, поскольку существует дисперсия DX, то при каждом истинном значении

асимптотически при

где

причем

Пример:

Найдем методом моментов оценку неизвестной вероятности успеха

Итак, оценка

Пример:

Выборка

с двумя неизвестными параметрами

Отсюда для определения оценок

решение которой имеет вид

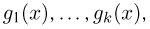

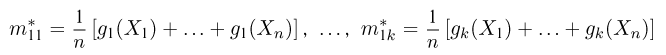

Вообще говоря, в методе моментов не обязательно использовать первые k моментов. Более того, можно рассматривать моменты не обязательно целого порядка. Иногда для использования в методе моментов привлекают более или менее произвольные функции

функций

Пример:

Пусть выборка

Следует отметить, что оценки, полученные методом моментов, обычно имеют эффективность существенно меньше единицы и даже являются смещенными. Иногда из-за своей простоты они используются в качестве начального приближения для нахождения более эффективных оценок.

Метод максимального правдоподобия

Метод максимального правдоподобия является наиболее распространенным методом нахождения оценок. Пусть по-прежнему выборка

в дискретном случае и

в непрерывном называется функцией правдоподобия. Отметим,что в функции правдоподобия

При практической реализации метода максимального правдоподобия удобно пользоваться не самой функцией правдоподобия, а ее логарифмом.

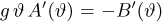

Уравнением правдоподобия называется уравнение

Если функция правдоподобия дифференцируема по

Пример:

Найдем оценку неизвестной вероятности успеха

где

Решая это уравнение, имеем

Поскольку

то

Оказывается, имеется тесная связь между эффективными оценками и оценками, полученными методом максимального правдоподобия. А именно, справедлива следующая теорема.

Теорема:

Совпадение эффективной оценки с оценкой максимального правдоподобия. Если (естественно, при условиях регулярности теоремы 1) существует эффективная оценка

Доказательство теоремы 6 представляет собой дальнейшее уточнение доказательства теоремы 1. Действительно, как следует из замечания 1 к теореме 1, из существования эффективной оценки

Поэтому из условия строгой положительности информации I вытекает строгая положительность

уравнения правдоподобия

Это решение совпадает с эффективной оценкой

В общем случае оценка максимального правдоподобия может быть не только неэффективной, но и смещенной. Тем не менее она обладает свойством асимптотической эффективности в следующем смысле.

Теорема:

Асимптотическая эффективность оценки максимального правдоподобия. При некоторых условиях на семейство

Доказательство:

Сначала сформулируем условия теоремы (см. [9]), которые, как мы увидим далее, гарантируют возможность дифференцируемости под знаком интеграла и разложения

а) для (почти) всех х существуют производные

б) при всех

где функции

в) информация I конечна и положительна для всех

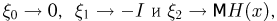

Обозначим через

причем

где случайные величины

Рассмотрим поведение

Поэтому

Вернемся к уравнению (14) и воспользуемся сначала тем фактом, что при

Величина

Поэтому оценка

Замечание:

Доказанная теорема гарантирует, что среди всех решений уравнения правдоподобия существует по крайней мере одно

поскольку в силу закона больших чисел именно к расстоянию Кульбака-Лейблера при

здесь

В случае, когда семейство

Пример:

Выборка

Система уравнений правдоподобия имеет вид

Таким образом,

Читателю предлагается самостоятельно показать, что

Оказывается, однако, что если мы в качестве оценки параметра

Метод минимального расстояния

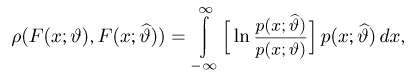

Суть этого метода заключается в следующем. Предположим, что любым двум функциям распределения

называемое расстоянием, причем

т. е. такое значение

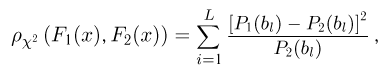

Приведем примеры некоторых наиболее часто встречающихся в математической статистике расстояний.

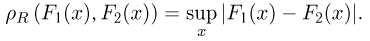

Равномерное расстояние (расстояние Колмогорова) определяется формулой

Расстояние

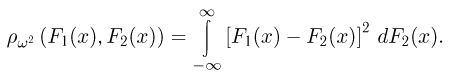

Расстояние

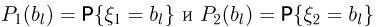

где вероятности

Использование приведенных выше расстояний для получения оценок весьма сложно в вычислительном плане, и поэтому они употребляются крайне редко. Здесь мы упомянули об этих расстояниях только потому, что применение оценок, полученных с их помощью, позволяет упростить вычисление уровней значимости критериев при проверке сложных непараметрических статистических гипотез, поскольку такие оценки естественным образом связаны с соответствующими критериями (см. параграф 5 гл. 3).

Метод номограмм

Еще одним методом, позволяющим, пользуясь только номограммами (специальным образом разлинованными листами бумаги, которые в математической статистике носят название вероятностной бумаги), весьма просто и быстро оценить неизвестные параметры, является метод номограмм. Его сущность состоит в следующем. Пусть мы имеем выборку

Казалось бы, мы пришли к не менее сложной задаче: найти «чрезвычайно простой» способ приближения эмпирической функции распределения функцией распределения из семейства

Практическая реализация метода номограмм происходит следующим образом. Сначала выборку

Пример 26. Предполагая в примере 1 из гл. 1, что проекция вектора скорости молекул водорода распределена по нормальному закону, оценим с помощью метода номограмм неизвестное математическое ожидание

Оценка

правдоподобия (см. пример 18, а также пример 8 из гл. 1):

Следует отметить, что с помощью метода номограмм можно судить также о правильности выбора семейства

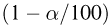

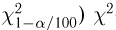

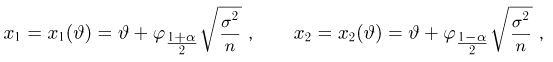

Доверительные интервалы

Полученные в предыдущих параграфах оценки неизвестных параметров естественно называть точечными, поскольку они оценивают неизвестный параметр одним числом или точкой. Однако, как мы знаем, точечная оценка не совпадает с оцениваемым параметром и более разумно было бы указывать те допустимые границы, в которых может находиться неизвестный параметр

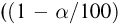

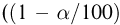

Доверительной вероятностью назовем такую вероятность

Задавшись доверительной вероятностью

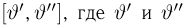

Доверительные интервалы определим, следуя Ю. Нейману, опираясь на точечные оценки. По заданной оценке

Итак, пусть у нас имеется выборка

(напомним, что

Именно интервал

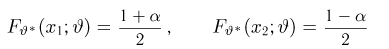

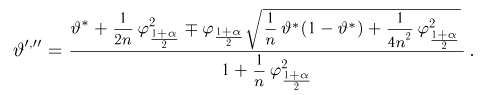

Пример 27. Построим симметричный доверительный интервал доверительной вероятности а для неизвестной вероятности успеха

где

При малом объеме выборки п процедура построения доверительных интервалов трудоемка, поскольку она практически сводится к перебору значений неизвестного параметра. Поэтому существуют специальные таблицы (см. [1], табл. 5.2), которые по наблюденным значениям числа успехов

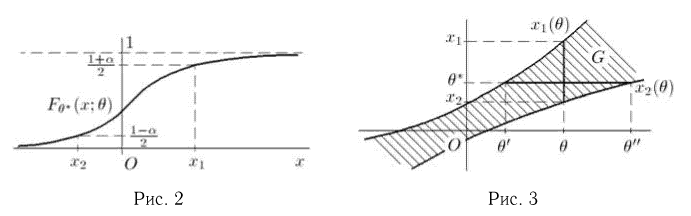

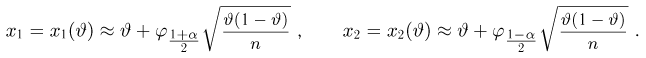

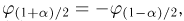

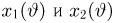

При больших объемах выборки п пользуются тем фактом, что в силу интегральной теоремы Муавра-Лапласа оценка

связаны с

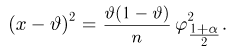

Учитывая, что

Последнее уравнение, как нетрудно видеть, представляет собой уравнение эллипса (рис. 4) (физически непонятный выход эллипса за полосу

откуда окончательно получаем

Пример:

Построим симметричный доверительный интервал доверительной вероятности а для неизвестного среднего

Оценка

т.е.

Пример:

Как и в предыдущем примере, предположим, что выборка

Тогда случайная величина

определяются формулами

где

представляют собой уравнения двух лучей, исходящих из начала координат (рис.6), и, значит, границы симметричного доверительного интервала доверительной вероятности а для неизвестной дисперсии

Пример:

Рассмотрим, наконец, случай, когда в выборке из нормальной генеральной совокупности неизвестны оба параметра: среднее

и выборочной дисперсией

(см. пример 25).

Построение доверительного интервала

которая, как говорилось в параграфе 4 гл. 1, имеет t-распределение с п — 1 степенями свободы. Обозначим через

Продолжая рассуждения, как и в случае известной дисперсии, и учитывая равенство

Доверительный интервал

При этом нужно учитывать, что квантили

В заключение отметим, что в современной математической статистике доверительные интервалы строят так же, основываясь на критериях значимости.

Решение заданий и задач по предметам:

- Теория вероятностей

- Математическая статистика

Дополнительные лекции по теории вероятностей:

- Случайные события и их вероятности

- Случайные величины

- Функции случайных величин

- Числовые характеристики случайных величин

- Законы больших чисел

- Статистические оценки

- Статистическая проверка гипотез

- Статистическое исследование зависимостей

- Теории игр

- Вероятность события

- Теорема умножения вероятностей

- Формула полной вероятности

- Теорема о повторении опытов

- Нормальный закон распределения

- Определение законов распределения случайных величин на основе опытных данных

- Системы случайных величин

- Нормальный закон распределения для системы случайных величин

- Вероятностное пространство

- Классическое определение вероятности

- Геометрическая вероятность

- Условная вероятность

- Схема Бернулли

- Многомерные случайные величины

- Предельные теоремы теории вероятностей

- Генеральная совокупность

Такое случается с сильными классификаторыми (например, нейросетями), которые учились на метки классов, а не на вероятности: тем самым процесс обучения стимулировал их всегда давать как можно более близкий к 0 или 1 ответ.

Такое случается с сильными классификаторыми (например, нейросетями), которые учились на метки классов, а не на вероятности: тем самым процесс обучения стимулировал их всегда давать как можно более близкий к 0 или 1 ответ.